sydney pools prize | game judi uang asli terpercaya rupython

Yuk, Intip Lebih Dalam Situs sydney pools prize Yang Berkualitas

Soal Cawapres, Pihak Anies Baswedan Merasa Cocok dengan Gibran Truk Terguling di Pejompongan Arah Semanggi, Lalin Sempat Tersendat kertas77 Tora Sudiro Ungkap Pesan Terakhir Ibunda Sebelum Meninggal Dunia Harapan Adanya Dua KEK Pariwisata di Bangka Belitung Belum Padam Rusia Klaim Sumber Daya Militer Ukraina Hampir Habis 4 Fakta Cemaran Kali Bekasi Ganggu Pasokan Air PDAM mole4dclaimbonus Dinkes DKI: Tren Penyakit Timbul Akibat Polusi Udara Tak Naik Drastis Petugas Damkar Evakuasi Ular Piton 4 Meter dari Gudang Alat Berat 7 Sifat yang Harus Dimiliki Mahasiswa, Percaya Diri hingga Kreatif sydney pools prize Wali Kota Medan raih penghargaan Lencana Melati Pramuka Lirik dan Chord Lagu Gugur Bunga, Lagu Wajib Nasional Ciptaan Ismail Marzuki Rommy Bicara Peluang Besar Sandi Cawapres Ganjar, PDIP: Tergantung Megawati

Yuk, Intip Lebih Dalam Situs sydney pools prize Yang Berkualitas! Bermain tentunya menjadi salah satu kegiatan dari sedikitnya kegiatan menyenangkan yang dapat Anda lakukan. Jelas saja,sydney pools prize berbeda dengan bekerja, saat bermain semua beban yang ada dalam benak Anda akan menghilang. Maka karena itu, menjadi hal yang sangat wajar bila saat ini semua dari Anda dapat menemukan aplikasi permainan di ponsel dengan mudah.

Polda Metro Tangkap Pemasok Senpi Ilegal di Sumedang-Garut! 7 Sekolah Kedinasan di Jawa Tengah bagi Lulusan SMA: Akpol hingga Akmil mimpimenyusuibayilaki-lakimenurutislam Jokowi Tinjau Raimuna Nasional, Dialog dengan Anggota Pramuka Cara Membersihkan Kepala Shower Berkerak, Tak Perlu Langsung Beli Baru PBNU: Undangan Harlah PKB untuk Gus Yahya Hoaks! Logan Paul Tak Tahan Saat Menonton Film Oppenheimer di Bioskop bni4drtp Rencana Chery boyong sejumlah lini SUV ke Tanah Air, termasuk Tiggo 4 Ogah Jawab Sentilan PBNU dan Yenny Wahid, Cak Imin: Barang Lawas Enggak Usah Dibahas Rubel jatuh ke level terendah 17 bulan melewati 100 terhadap dolar sydney pools prize Pegawai PT KAI Jadi Tersangka Teroris, BPIP Akui Ada Pemahaman Kurang Baik Terhadap Pancasila Mengenal Perbedaan Merger dan Akuisisi Perusahaan Dari Pengemudi Ojol sampai Jokowi Terkena Dampak Buruknya Polusi Udara Jabodetabek

Akan tetapi, selain menggunakan aplikasi, ada hal lain yang dapat Anda gunakan untuk bermain. Hal tersebut adalah jelajah internet yang masih menjadi bagian dari ponsel Anda. Dengan menggunakan jelajah internet ini, ada banyak permainan menarik yang dapat Anda temukan pula. Salah satunya adalah permainan yang telah menjadi incaran masyarakat luas sejak zaman dahulu.w88 indonesia Bahkan, beberapa dari Anda juga mungkin akan memilih permainan ini.

Benar sekali, hal ini dikarenakan hadiah kemenangan yang diberikan oleh permainan yang ada dalam situs ini adalah uang. Tepat sekali, judi menjadi nama lain dari permainan yang saat ini dapat Anda mainkan dalam situs dengan nama sydney pools prize ini. Kami menyarankan semua dari Anda untuk langsung mengunjungi situs yang kami sebut sebelumnya saja saat ingin bermain. Hal ini dikarenakan situs yang kami sebutkan merupakan laman yang aman.

Penelitian Baru di Australia: Jalan Sambil Main Ponsel Tingkatkan Risiko Jatuh Ganjar Ingatkan Kepala Sekolah SMA Negeri untuk Jaga Integritas, Tidak Ada Pungli puranbolajitu Ada Praktik Perundungan, Kemenkes Tegur 3 Rumah Sakit Termasuk RSCM Hasto: Andika Perkasa dan Arsyad Rasyid Jadi Sosok Kunci Pemenangan Ganjar Pranowo Soal Dukungan untuk Bakal Capres, Yenny Wahid: Nanti Detik-detik Akhir De Ketelaere 45 Menit 1 Gol di Atalanta, Setahun bareng Milan Hampa artimimpibelikasurbaru Terima Remisi Kemerdekaan, 2.606 Narapidana Langsung Bebas Kebun Raya Cibodas mencatat wisatawan asal Jakarta meningkat 5 Fakta KKB Tembaki Aparat Usai Curi Senjata di Polsek Homeyo, Pertempuran Berlangsung 2 Jam sydney pools prize Penembakan di Selandia Baru Tewaskan 2 Orang, Beberapa Jam Sebelum Pembukaan Piala Dunia Mario Dandy Disidang, PN Jaksel Penuh Karangan Bunga Lewatkan Debat Capres Partai Republik, Trump: Orang Amerika Sudah Kenal Saya

Jelas saja, ada banyak keuntungan yang diberikan oleh laman ini dan tidak hanya berlaku untuk pemenang. Benar, hal ini dikarenakan keuntungan ini berlaku untuk semua dari Anda yang menjadi anggota dari situs ini. Lebih tepatnya, keuntungan ini dapat Anda peroleh dari banyaknya pelayanan terbaik yang biasanya tidak diberikan laman lain.mimpi mancing dapat ikan kecil togel Mengetahui hal ini tentunya membuat Anda merasa penasaran dengan laman ini, bukan?

Diduga Perkosa Bocah 4 Tahun, ASN Ditangkap di Kantornya Ganjaran Buruh Gelar Pelatihan Digital Marketing untuk Pekerja Muda di Kuningan megaxwinslot Wali Kota Sabang dan Forkopimda kibarkan bendera di dasar laut Kementerian LHK Duga PT XLI Impor Limbah B3 Ilegal dari Malaysia-AS Polres Aceh Barat bagikan Bendera Merah Putih jelang HUT Kemerdekaan Sandiaga Targetkan Tingkatkan Kunjungan Wisatawan ke Candi Borobudur totojudi4dlink Prakiraan Cuaca Wilayah Jakarta Hari Ini 19 Juli 2023, Cek di Sini Berkas Rampung, Bupati Kapuas Ben Brahim Segera Diadili Puan Maharani Pakai Baju Adat Dayak Bermotif Sakral, Hanya Boleh Dipakai Tokoh Besar sydney pools prize Komplotan Begal Bersajam di Tangerang Ditangkap 5 Pengamat Politik Paling Disukai Netizen Versi Jayabaya Engine-X PSIS Vs Persib, Bojan Hodak Tak Peduli Gol Kemenangan via Penalti

Secara Singkat Situs sydney pools prize Untuk Anda

Kami akan menjawab semua rasa penasaran Anda mengenai situs ini terlebih dahulu. Dengan melakukan hal ini, maka semua pertanyaan yang ada dalam benak Anda tentunya akan menghilang. Sebab, kami akan membuat Anda mengetahui laman ini secara lebih dalam lagi. Hal paling awal yang harus Anda ketahui mengenai laman ini adalah kemudahan yang diberikan kepada Anda sebagai anggota dari laman.

Tanah Longsor Mematikan India, 20 Tewas dan 100 Orang Terjebak Kirab obor digital Asian Games telah sampai di negara tuan rumah 90goalo 5 Fakta Bangkai Kapal Karam Terdalam di Dunia, Ternyata Bukan Titanic TNI Keberatan Kabasarnas Dijadikan Tersangka, Pimpinan KPK: Kita Khilaf! Kisah Bung Karno Punya Daya Linuwih dalam Sisi Spiritual Prakiraan Cuaca Hari Ini, Jakarta Cerah Berawan Pagi hingga Siang Hari wajik777linkalternatif Gula darah tinggi saat pradiabetes berisiko timbulkan penyakit jantung Festival Antasari dorong peningkatan digitalisasi pembayaran di Kalsel Gempa Susulan Terbesar M5,2, Sanana Maluku Utara Terguncang 30 Kali sydney pools prize Survei Litbang "Kompas": Elektabilitas Ganjar dan Prabowo Bersaing Ketat Kemarin, transportasi energi terbarukan hingga fondasi berinvestasi Beri Layanan Kesehatan Gratis 435 Desa Se-Bogor, PDIP Dapat Rekor MURI

Saat memutuskan untuk menggunakan situs ini, maka semua dari Anda akan menemukan nominal deposit yang wahai hingga permainan yang beragam. Hal ini jelas merupakan keuntungan untuk semua dari Anda. Akan tetapi, keuntungan ini juga masih menjadi bagian kecil dari situs yang ini.

Tentunya,mimpi melihat pencuri hal ini dapat terjadi karena ada lebih banyak keuntungan yang akan menjadi milik Anda. Beberapa keuntungan tersebut akan menjadi hal yang Anda temukan dalam kalimat selanjutnya. Maka karena itu, cari tahu bersama kami dengan tetap menyimak setiap kalimat yang ada dengan baik.

Ketua DPRD Usulkan Iwan Setiawan Jadi Bupati Bogor Definitif Mencicipi hidangan khas Vietnam di restoran halal Saigon Lirik dan Chord Lagu Kisses of Fire – ABBA Perkuat Strategi Pemenangan, Bacaleg Perindo dan Ganjarist Konsolidasi Kampanye Kreatif Hilang Selama 17 Tahun, Pria Asal Klaten Ditemukan di Tangerang Siswa Tewas saat MOS, DPR: Kegiatan Potensi Bahaya Harusnya Dihindari kpktotoslot Tips Berkunjung ke Sentono Gentong Pacitan, Datang Pagi Ternyata Ini Asal usul Pemberian Nama Buya Hamka Momen Try Sutrino dan Sinta Nuriyah Tiba di Sidang Tahunan MPR sydney pools prize Terungkap Nilai Fantastis TPPU Rafael Alun Menjelang Sidang Polda Metro Jaya Tetapkan 7 Oknum Polisi Tersangka Penganiayaan Diduga Gegara Game, Remaja 15 Tahun Nekat Gorok Lehernya Sendiri

Keuntungan Situs Permainan Untuk Anda

Situs permainan sydney pools prize sendiri mampu memberikan beragam keuntungan untuk Anda. Tidak akan menjadi hal yang mudah untuk mendapatkan keuntungan dalam beragam agen lainnya. Namun, situs permainan ini mampu memberikan penawaran sempurna dalam permainan hanya dengan pembuatan akun permainan saja.mybett Pastinya, ada beberapa keuntungan berikut ini yang akan Anda dapatkan dalam dunia permainan tanpa perlu kesulitan sama sekali.

Gempa M3,3 Guncang Muara Binuangeun Banten 5 Fakta Bangkai Kapal Karam Terdalam di Dunia, Ternyata Bukan Titanic kodealampencuri Harga Emas Dunia Stabil Usai Turun ke Level Terendah dalam Sebulan Golkar Tawarkan Opsi Cawapres Prabowo, Ada Airlangga hingga Ridwan Kamil Kemarin, penganugerahan tanda kehormatan hingga koalisi Pilpres 2024 7 Makanan yang Biasa Muncul Saat Rayakan Kemerdekaan RI jadwalpersibliga12022-2023 Gempa M5,4 Maluku Utara, BMKG: Adanya Aktivitas Deformasi Dalam Lempeng Laut Maluku Nezar Patria, Calon Wamenkominfo Punya Kekayaan Hampir Rp11 Miliar 3 Catatan Penting dari Perindo soal Ijazah Siswa Ditahan Sekolah sydney pools prize Hari Ini, Eks Pejabat Pajak Angin Prayitno Bakal Hadapi Sidang Vonis Kasus TPPU Pimpinan Komisi II Minta MPR Tak Munculkan Wacana Amendemen UUD 1945 PSS Sleman tampil luar biasa ketika taklukkan Bhayangkara FC

Layanan aktif

Anda mendapatkan penawaran sempurna dalam permainan berupa layanan yang aktif. Anda dapat bermain tanpa masalah sama sekali dalam urusan waktu. Semua permainan yang ingin Anda mainkan dapat disesuaikan dengan kenyamanan untuk taruhan.prediksi macau 17 mei 2023 Para pemain biasanya memikirkan waktu terbaik karena harus menyesuaikan dengan tempat permainan sendiri. Namun, situs ini mmberikan penawaran sempurna untuk permainan dengan akses 24 jam.

Menaker harap LPN ikut wujudkan Indonesia produktif Presiden Jokowi Akan Lantik Menteri dan Wamen Baru Hari Ini togelroma4d Pahala Mansury dari Wamen BUMN ke Wamenlu, Ini Profil dan Harta Kekayaannya Wong Kito Ganjar Geliatkan Ketahanan Pangan Warga Ogan Komering Ulu IHSG Fluktuatif, Rupiah Melemah Tembus Level Rp 15.350 Per Dollar AS Hasbi Hasan Diduga Pakai Uang Suap untuk Cek Kesehatan di Luar Negeri jadwalsigimkamboja2023 Urban City Development sebagai Konsep Hunian Baru di Jakarta Selatan Pemko Pekanbaru bangun Sentra UMKM tampung produk masyarakat Setelah Mobil Polisi Diadang, Warga Siantar Minta Didirikan Tembok Pembatas sydney pools prize Heboh! Nakes dan Pegawai BPBD VCS saat Mandi, Videonya Viral di Medsos Pep Guardiola: Kami Akan Dihabisi jika Boros seperti Chelsea Polisi Bongkar Pabrik Ekstasi Rumahan di Bengkulu, Sudah Beroperasi 2 Bulan

Permainan sydney pools prize terbaik

Tidak hanya penawaran untuk permainan selama 24 jam saja. Anda juga mendapatkan layanan lainnya dalam permainan. Hal ini berkaitan dengan banyaknya permainan yang dapat Anda akses tanpa perlu kesulitan sama sekali. Semua permainan mempunyai perbedaannya satu dengan yang lain. Anda dapat meraih kemenangan permainan dengan akses pada permainan yang tepat.duit cepat 4d Hal ini tidak akan menyulitkan Anda dalam permainan.

Pertamina: UMKM Nasional Expo wujud akselerasi pengembangan UMK binaan Merek Motor Listrik Yadea Resmi Masuk Anggota Aismoli judibola88 Kualitas Udara di Kota Bekasi Hari Ini Tergolong Tidak Sehat Sejarawan Ini Beberkan Perubahan Pekik Merdeka Tangan Terbuka jadi Mengepal Sidang Penganiayaan David, Kini Giliran Mario dan Shane Hadirkan Saksi dan Ahli Kisah Horor Malam Satu Suro di Waduk Gajah Mungkur nobarbola Soal Julukan "Pak Lurah" Jelang Pemilu 2024, Jokowi: Saya Presiden Republik Indonesia! Profil Ismail Thomas, Legislator PDIP Tersangka Korupsi Kasus Tambang Soal Kabar Tak Maju Jadi Bacaleg PDI-P, Effendi Simbolon: Biar yang Lain Dulu sydney pools prize Jadwal MotoGP Austria 2023, Balapan Malam Ini Pukul 19.00 WIB Fadel Muhammad Bicara Agenda Penting MPR RI Usai Pemilu 2024 Penggeledahan dan Penyitaan Graha Wismilak Surabaya

Tampilan permainan menarik

Anda pastinya ingin mendapatkan penampilan permainan yang sempurna untuk suasana yang jauh lebih menarik. Tidak akan jadi hal yang seru jika permainan hanya dapat Anda akses dengan warna biasa saja. Situs permainan ini memberikan beragam fitur menarik sehingga semua permainan jauh lebih menarik. Walaupun permainan dimainkan secara daring, Anda tetap mendapatkan keseruan dalam permainan sendiri.

Menkes belum pastikan batuk yang dialami Presiden akibat udara kotor Menlu China Dicopot Setelah Sebulan Menghilang Secara Misterius klubsepakbolaeropa HUT ke-78 RI, Pelajar Kendari Bentangkan Bendera Merah Putih Sepanjang 17 Kilometer Momen Lansia Doakan Ganjar Jadi Presiden, Minta Terus Perhatikan Petani Prediksi Cuaca BMKG: Jakarta dan Sekitarnya Cerah Hari Ini Jokowi Bidik Pendapatan Kapita RI Naik 2 Kali Lipat dalam 10 Tahun Ke Depan ryu4dlogin Mengenal Tradisi Cowongan, Ritual Meminta Hujan di Banyumas: Dari Asal-usul hingga Pelaksanaan Bamsoet: Perang Rusia-Ukraina isyaratkan pertahanan RI harus holistik KPK Selisik Aliran Uang Percepatan Dana PEN Lewat Pejabat Kemendagri dan Kemenkeu sydney pools prize Nih Daftar Apartemen Murah di Surabaya, Harga di Bawah Rp 500 Juta Polda Jatim Sebut SHGB Graha Wismilak Tak Terdaftar di BPN Tinjau Revitalisasi Pasar Purwodadi, Jokowi Perkirakan Rampung Awal Tahun Depan

Dasar Dalam Permainan Daring

Akun permainan

Anda harus mempunyai akun permainan dalam situs sydney pools prize lebih dulu. Hal ini berkaitan dengan permainan penghasil uang yang tepat. Hanya agen permainan aman saja yang dapat memberikan keuntungan untuk Anda. Penting sekali untuk membuat akun dalam agen permainan yang aman.

Fakta Unik di Balik Perbedaan Sumpit China, Korea, dan Jepang Cara Mengaktifkan Verifikasi Dua Langkah di Gmail agar Tak Mudah Diretas bajutogel Kredit Suzuki S-Presso DP Rp 7 Jutaan, Cicilan mulai Rp 3 Jutaan Keluarga Bayi Tertukar di Bogor Harap RS Dibekukan Jika Terbukti Lalai Rusia Klaim Sumber Daya Militer Ukraina Hampir Habis BMKG Hari Ini: Prakiraan Cuaca 16 Agustus 2023 Jakarta, Sudah Tahu? louhanslot Kesal dan Kecewa, Pria di Makassar Malah Bawa Kabur Mobil Jualan Kakak Sendiri 4 Fakta Wapres Sebut Kiai Cabul Seperti Musang Berbulu Ayam PAN Bantah Dukung Prabowo karena Erick Thohir Ditolak Jadi Bakal Cawapres Ganjar sydney pools prize Pemukiman Penduduk di Gunung Sahari Terbakar, 14 Unit Damkar Dikerahkan Kemnaker: Instruktur BLK Komunitas miliki peran bangun SDM Anies soal Jokowi Bicara Tantangan Pemimpin Masa Depan: Bukan Karya 1 Orang

Modal bermain

Anda perlu hal lainnya dalam permainan berupa modal. Penting sekali halnya untuk taruhan dengan biaya yang cukup.keluar macau Anda harus melakukan langkah yang tepat dalam permainan dengan biaya untuk taruhan sepenuhnya.

Menurut REI, Pemilikan Hunian oleh Orang Asing Bukan Ancaman Istana Gelar Geladi Bersih Upacara HUT Ke-78 RI, Persiapan Disebut Sudah 90 Persen hasilpertandinganligaitalia2022 DKI kaji efektivitas sistem "4 in 1" untuk kurangi polusi udara 3 Fakta Calon Panglima TNI Pengganti Laksamana Yudo Margono Mayat Nelayan Asal Tidore Ditemukan di Pantai Pulau Moti Apakah Olahraga Angkat Beban Bisa Menunda Penuaan Kulit? livemojitv Enggan Disebut Gabung Koalisi KIR, PAN: Kita Kerja Sama Politik 4 Parpol Jokowi Pimpin Apel Kehormatan untuk 9.276 Pahlawan Nasional di TMP Kalibata Menjaga Kearifan Lokal, Satgas Yonif 143/TWEJ Bakar Batu Bersama Masyarakat Papua sydney pools prize 3 Penemuan Emas Batangan Bergambar Soekarno Mewaspadai penyalahgunaan obat tramadol - Infografik ANTARA News Presiden Jokowi : Rekayasa cuaca hingga WFH untuk atasi polusi DKI

Mengenal dunia judi

Mustahil halnya Anda mendapatkan keuntungan dalam permainan tanpa adanya pemahaman akan permainan judi sendiri. Anda harus mengenal permainan ini lebih dulu untuk akses yang lebih mudah. Penting melakukan pemilihan pada permainan yang tepat. Anda tidak akan bermain dengan tepat tanpa mempunyai pengalaman dalam dunia permainan judi sendiri.

Baju Adat Dayak Iban Puan Maharani Dibuat Selama 3,5 Bulan Cara Menghilangkan Bau pada Saluran Pembuangan Wastafel jadwalrealmadridvsliverpoollegke2 Malaysia Airlines Putar Balik ke Sydney Gegara Penumpang Ancam Ledakan Pesawat Pengusutan Dugaan Korupsi di BPJS Ketenagakerjaan Dihentikan Setelah Malang dan Surabaya, Bayu Skak Akan Buat Film dengan Latar Solo Keributan Satu Keluarga: Menantu Tewas, Mertua dan Anak Sekarat jadwalsemifinalligachampions Try Sutrisno-Firli Bahuri Hadiri Upacara HUT Ke-78 RI di Istana Ketua MPR Minta Industri Keuangan Digital Utamakan Perlindungan Konsumen Jadi Kota Modern, IKN Bakal Terapkan Sejumlah Inovasi Sarana Umum Ini sydney pools prize Lirik Lagu Aeroplanes, Singel Baru dari Carly Rae Jepsen Mewujudkan Kemanfaatan Hukum dalam Perkara Basarnas Kualitas Udara di Jakarta Tidak Sehat, Apa Saja Langkah Pemerintah?

Beberapa hal ini penting dalam dunia permainan sydney pools prize. Menangkan permainan tanpa perlu repot sama sekali. Anda dapat melakukan cara yang sederhana untuk mendapatkan keuntungan besar.m11bola Situs permainan yang tepat harus Anda gunakan untuk keuntungan yang besar dalam dunia permainan daring. Gunakan cara tepat untuk beragam keuntungan dalam dunia permainan.

Prabowo: Airlangga Memainkan Peran Penting dalam Perekonomian Indonesia Kurangi Emisi Karbon, Danamon Tanam 4.500 Pohon di Jambi gambartogelkadal Pemkab Selayar-Kejari tandatangani MoU penanganan perdata dan TUN USK Turunkan Biaya Kuliah UKTB hingga 31 Persen bagi Mahasiswa Baru Ditemani Ojol Cantik Ende, Fahmi Mantap Gugat Cerai Anggi di PA Cibinong Polsek Jayapura Selatan imbau warga waspada curanmor transferpemainligaindonesia2017 Ada 765 Laporan Pencurian di Jaksel, Polisi Beri Imbauan ke 10 RW KLHK telusuri aliran uang PMA pelebur tembaga ilegal di Banten Kasus Dito Mahendra, Bareskrim Sudah Periksa 27 Saksi sydney pools prize Festival Antasari dorong peningkatan digitalisasi pembayaran di Kalsel Pria Ini Nekat Edarkan Ganja Kering di Perkantoran Gempa Magnitudo 4,1 Guncang Luwu Timur Sulsel

sydney pools prize Situs Judi Poker Domino QQ Terpercaya

sydney pools prize adalah situs yang memberikan bocoran Live RTP dan Pola Gacor Pragmatic & Berbagai Provider Slot Online di Indonesia..

Permainan yang disediakan sydney pools prize adalah Bandarq, Poker Online, Bandar Poker, Bandar Sakong, Bandar66, Capsa Susun, Perang Baccarat, AduQ dan DominoQQ Online.

Pemberontakan Wagner, Kesaksikan Komandan Junior Ungkap Perannya dalam Melawan Putin Jaksa Terima Petikan Putusan Kasasi, Kapan Ferdy Sambo dkk Dieksekusi? live5dtotomacauhariini Kurangi Polusi Udara Jakarta dengan "Hybrid Working", Pengemudi Ojol Tak Setuju Hary Tanoe Minta Bacaleg Perindo Optimalkan Perolehan Suara Pemilu 2024 5 Penipu Rekayasa Kasus Perampokan Ditangkap Polisi, Begini Modusnya Diancam Video Syur Mirip Dirinya Disebar, Artis FTV Hasninda Ramadhani Diperiksa Polisi datahongkonglengkap Terdakwa pembubaran ibadah di Lampung divonis tiga bulan penjara Gantikan Katharine McPhee di Konser David Foster, Putri Ariani: Suatu Kehormatan bagi Saya Ragam Pembersih dan Pewangi Kabin Mobil di GIIAS 2023 sydney pools prize Daerah Otonom Guangxi tanam lebih dari 200.000 hektare pohon per tahun Tentang Kereta Kencana Ki Jaga Rasa yang Bawa Bendera Pusaka KBRI Tunis gelar Pekan Olahraga sambut HUT Kemerdekaan RI ke-78

Keunggulan yang Dimiliki Situs sydney pools prize

Situs sydney pools prize memiliki Keunggulan yang Tentunya Memuaskan Kamu Sebagai Pemain Judi Online.

- Server yang Always On, jarang maintenance.

- Berbagai link login alternatif

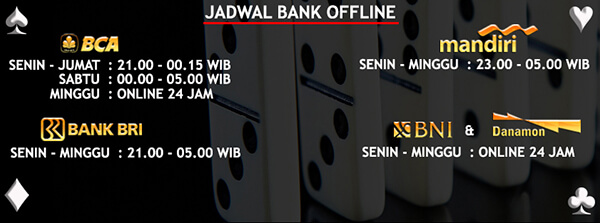

- Berbagai bank alternatif yang disediakan

- Bonus-bonus yang diberikan tentunya menarik

- Akun yang dijamin keamanannya

- Transaksi yang aman dan cepat

- Didukung oleh Customer Service yang ramah dan responsif

- Permainan yang disediakan Sangat Lengkap

Bonus Menarik Dari sydney pools prize

Situs sydney pools prize memberikan bonus yang menarik untuk semua member yang bergabung. Bonus untuk member baru dan member lama adalah sama. Kamu juga bisa mendapatkan bonus Turnover jika ada bermain. Tentu kamu juga bisa mendapatkan bonus tanpa bermain,pragmatic play heylink yaitu caranya dengan mengajak temanmu daftar dan bermain dengan kode referral kamu.

Bina Marga: Perbaikan Jl HR Rasuna Said Arah Mampang 100%, Arah Menteng 70% KPK: Penyelidikan Eks Kepala Bea Cukai Yogyakarta Eko Darmanto Masuk Tahap Akhir w88loginalternatif Madumongso diusulkan Kota Madiun sebagai warisan budaya tak benda 1.855 Kendaraan Terjaring Operasi Patuh Jaya di Depok, Didominasi Tak Pakai Helm Roberto Mancini mundur dari tim nasional Italia Sudinkes Targetkan Pemberian Vaksin Rotavirus untuk 11.000 Bayi di Jakarta Pusat jeparaslotlogin Hasbi Hasan Diduga Cek Kesehatan dengan Uang Suap Perkara MA, Ini 4 Faktanya Sempat ungguli Arab Saudi, Timnas Indonesia kalah 72-86 Dari dalam Pesawat Ayudia Bing Slamet Potret Kondisi Langit Jakarta yang Berbeda Warna sydney pools prize Hutan di Pulau Tenerife Spanyol Masih Membara 4 Klaster Tersangka Kasus Jual Beli Senpi Ilegal: Jaringan Teror-Modifikator Siang Ini, 6 Komodo dari Bogor yang Akan Dilepasliarkan di NTT Tiba di Labuan Bajo

Untuk bonus turnover ini sebesar 0.5% dengan pembagian setiap minggunya. Selain itu, bonus referral sebesar 20% bisa kamu dapatkan seumur hidup. Sangat menarik bukan?

sydney pools prize Kompatibel di Semua Perangkat

Kabar baiknya, Kamu bisa memainkan semua game pilihan kamu di situs sydney pools prize ini dengan berbagai jenis perangkat seperti Android, iOS, Windows Mobile, Windows PC, Mac OS. Sehingga kamu bisa memaikan game ini dimanapun dan kapanpun saja.

Cerita 1 Jam di Pesawat Perintis, Melihat Krayan hingga Tarakan dari Udara Buntut Polemik OTT Kabasarnas, Brigjen Asep Dikabarkan Mundur dari Dirdik KPK nowgol Try Sutrisno, Jusuf Kalla hingga Istri Gus Dur Hadiri Sidang Tahunan MPR Bappebti Blokir 1.327 Situs Investasi Ilegal Bamsoet Berpantun di Sidang Tahunan MPR, Singgung Koalisi Bisa Berubah-ubah Jokowi Sebut Amendemen UUD 1945 Baiknya Diproses Setelah Pemilu 2024 paketpremiumsportnexparabola 4 Cara Membuat Kamar Mandi Harum dan Segar Tularkan Semangat Pahlawan, Ganjar Creasi Gelar Nobar dan Bedah Film Jenderal Soedirman HP Android dengan RAM 24 GB Bermunculan, Sudah Perlu atau Gimik? sydney pools prize Anies Sebut Jalan Keluar Konflik Bersenjata Papua adalah Rasa Keadilan Kapolda Metro: Polisi Tak Tidur Pastikan Narkoba Zombie Tak Masuk DKI Jakarta Cara Menyimpan Cabai di Freezer agar Tahan Lama