python x447 2 5712 - Game Slot88 Gacor Indonesia rupython

Yuk, Intip Lebih Dalam Situs python x447 2 5712 Yang Berkualitas

Media Asing Soroti Kereta Cepat Indonesia PC Berbentuk Sepatu dari Cooler Master Dijual Rp 72 Juta liv3drawmacau Humaniora kemarin, Jokowi ajak bangga berbatik dan setahun Kanjuruhan Cerita Emas Keempat Indonesia dari BMX: Buat China Tak Berkutik Ini Hasil Investigasi Rangka eSAF Honda dari Kemenhub dan KNKT Puan Respons soal Gibran Dipinang Jadi Cawapres Prabowo keluarantoto4dmacau Putri Anne Muak Dikomentari Perubahannya sampai Dikasihani Netizen: Kenal Juga Enggak Dianggap Beban, Operator Telekomunikasi Desak Penggantian Aturan PNPB Pelaku UMKM produksi arang kayu di Lebak tumbuhkan ekonomi pedesaan python x447 2 5712 Lanzhou Lamian, 'Oasis' Makanan Halal di Asian Games 2023 Teka-teki Keberadaan Mentan yang Hilang Usai Terseret Korupsi Kementan Madura United takluk 1-2 dari Borneo FC

Yuk, Intip Lebih Dalam Situs python x447 2 5712 Yang Berkualitas! Bermain tentunya menjadi salah satu kegiatan dari sedikitnya kegiatan menyenangkan yang dapat Anda lakukan. Jelas saja,python x447 2 5712 berbeda dengan bekerja, saat bermain semua beban yang ada dalam benak Anda akan menghilang. Maka karena itu, menjadi hal yang sangat wajar bila saat ini semua dari Anda dapat menemukan aplikasi permainan di ponsel dengan mudah.

Ketua BTN: Venue Indonesia vs Brunei Masih Tetap di Palembang Pemkab Ngawi tetapkan Status Tanggap Darurat karhutla Gunung Lawu pengeluaranmacau22.00 Jangan Salah Kaprah, Ini Bedanya Obat Paten dan Generik Bocoran Harga Tiket Kereta Cepat WHOOSH Berkisar Rp250.000-Rp350.000 GP Ansor Sentil Cak Imin dan Jazilul soal Pendisiplinan Yaqut: Baperan INFOGRAFIS: Prahara Truk Rem Blong Penjemput Nyawa pengeluarannototomacau DPRD-Pemkab Mukomuko sepakat gaji honorer dibayar 12 bulan Kemenkeu dorong Kalsel gali sektor produktif sebagai gerbang IKN Jokowi terbitkan Perpres No 58 Tahun 2023 tentang Moderasi Beragama python x447 2 5712 Daftar Rekor Suhu Panas dan Tanpa Hujan RI, Cek Rangkaian Pemicunya Diungkap, Sifat Kepribadian Utama yang Terkait Umur Panjang Buruh Demo Omnibus Law di Surabaya, Blokade Jalan di Depan Grahadi

Akan tetapi, selain menggunakan aplikasi, ada hal lain yang dapat Anda gunakan untuk bermain. Hal tersebut adalah jelajah internet yang masih menjadi bagian dari ponsel Anda. Dengan menggunakan jelajah internet ini, ada banyak permainan menarik yang dapat Anda temukan pula. Salah satunya adalah permainan yang telah menjadi incaran masyarakat luas sejak zaman dahulu.tabel result cambodia Bahkan, beberapa dari Anda juga mungkin akan memilih permainan ini.

Benar sekali, hal ini dikarenakan hadiah kemenangan yang diberikan oleh permainan yang ada dalam situs ini adalah uang. Tepat sekali, judi menjadi nama lain dari permainan yang saat ini dapat Anda mainkan dalam situs dengan nama python x447 2 5712 ini. Kami menyarankan semua dari Anda untuk langsung mengunjungi situs yang kami sebut sebelumnya saja saat ingin bermain. Hal ini dikarenakan situs yang kami sebutkan merupakan laman yang aman.

Antusiasme Pengunjung IMX 2023 Foto Bareng Mendag Zulhas Tok! DPR Setujui Arsul Sani Jadi Calon Hakim MK Gantikan Wahiduddin Adams datakeluarkamboja2023 Cara Membersihkan Perhiasan Stainless Steel agar Kembali Berkilau Wisman Mulai Gunakan Bandara Kertajati untuk Berwisata ke Jabar Asparminas: Besar potensi pertumbuhan Industri air minum kemasan Inilah Pasukan Khusus Pengawal Presiden Soekarno yang Jadi Cikal Bakal Paspampres grafikchina Masalah ECU, Daihatsu Recall 3.383 Unit Ayla 1.000 cc TGB Teken Kerja Sama dengan Pemprov Riau Terkait Pendidikan Spesifikasi Lengkap Omoda 5 GT Bermesin 1.600 Turbo python x447 2 5712 Peneliti 8 Negara OKI Belajar Vaksin di Bio Farma dan Unpad Resmi! Adira Finance (ADMF) jadi Pemegang Saham Home Credit Indonesia Mahasiswa Bina Nusantara dapat edukasi aset kripto dari Upbit dan ABI

Jelas saja, ada banyak keuntungan yang diberikan oleh laman ini dan tidak hanya berlaku untuk pemenang. Benar, hal ini dikarenakan keuntungan ini berlaku untuk semua dari Anda yang menjadi anggota dari situs ini. Lebih tepatnya, keuntungan ini dapat Anda peroleh dari banyaknya pelayanan terbaik yang biasanya tidak diberikan laman lain.data paito toto macau 2022 Mengetahui hal ini tentunya membuat Anda merasa penasaran dengan laman ini, bukan?

Satgas BLBI Kembali Sita Aset Para Pengemplang, Nilainya Rp 26 Miliar PDIP tutup rapat pintu wacana duet Ganjar jadi cawapres Prabowo dataprediksimacau Tim Pemenangan Ganjar Bakal Beri Arahan Tertutup di Rakernas PDIP Suami korban tewas di dekat Mal Central Park akui terima sinyal SOS Ganjar Pranowo Makin Kokoh di Jawa Timur, Unggul Semua Simulasi Capres Toyota Prediksi Jenis Mobil Hybrid dan Listrik akan Lebih Diburu Konsumen keluaranmacaup1 Bank Dunia proyeksikan ekonomi Indonesia tumbuh 5 persen pada 2023 Kakak Ipar Pratama Arhan Sindir Marshella Aprilia: Kalau Bukan Gara-gara Si Miskin Bisa Endorse? Upaya mitigasi cegah virus Nipah - Infografik ANTARA News python x447 2 5712 Smesco fasilitasi perizinan usaha hingga logistik lewat pameran Kapan Film Remake Snow White Live Action Tayang? Berkas Perkara "Bullying" Siswa SMP Cilacap Dilimpahkan ke Kejaksaan

Secara Singkat Situs python x447 2 5712 Untuk Anda

Kami akan menjawab semua rasa penasaran Anda mengenai situs ini terlebih dahulu. Dengan melakukan hal ini, maka semua pertanyaan yang ada dalam benak Anda tentunya akan menghilang. Sebab, kami akan membuat Anda mengetahui laman ini secara lebih dalam lagi. Hal paling awal yang harus Anda ketahui mengenai laman ini adalah kemudahan yang diberikan kepada Anda sebagai anggota dari laman.

Menkumham Yasonna Laoly Serahkan Pencarian Mentan Syahrul Yasin Limpo ke KPK Hasil Jepretan Xiaomi 13T dan 13T Pro Sama Bagusnya meski Chipset Berbeda keluarandatamacau Polda Jatim Turun Tangan dalam Kasus Mata Siswi SD Dicolok Pakai Tusuk Bakso di Gresik Perempat final bulu tangkis beregu putri Asian Games Arti Mimpi Makan, Pertanda Baik atau Buruk? Pengamat: KBT bisa jadi contoh zona bebas emisi karbon prediksigambarpasarantotomacau Prospek Indika Energy (INDY) Usai Kurangi Portofolio Batu Bara, Tambah Moncer? Perubahan Penting Stadion Kanjuruhan, Renovasi dan Revitalisasi Dimulai Butuh Waktu Jutaan Tahun, Begini Proses Terbentuknya Batu Bara python x447 2 5712 Wolves beri Manchester City kekalahan perdana di Liga Inggris 4 Zodiak Ini Selalu Memberikan yang Terbaik untuk Orang Lain, Ada Zodiakmu? Dijadwalkan Kunjungi Bulog di Sukoharjo, Presiden Jokowi Akan Serahkan Bantuan Pangan

Saat memutuskan untuk menggunakan situs ini, maka semua dari Anda akan menemukan nominal deposit yang wahai hingga permainan yang beragam. Hal ini jelas merupakan keuntungan untuk semua dari Anda. Akan tetapi, keuntungan ini juga masih menjadi bagian kecil dari situs yang ini.

Tentunya,toto macau terbaru hal ini dapat terjadi karena ada lebih banyak keuntungan yang akan menjadi milik Anda. Beberapa keuntungan tersebut akan menjadi hal yang Anda temukan dalam kalimat selanjutnya. Maka karena itu, cari tahu bersama kami dengan tetap menyimak setiap kalimat yang ada dengan baik.

Lagi-Lagi Bullying, Siswa SD Dipaksa Minum Air Kencing Kakak Kelas di Buton Jarak Pandang Terganggu, Sejumlah Penerbangan di Bandara Pekanbaru Terganggu Spesifikasi iPhone 15 Pro dan iPhone 14 Pro, Apa Saja Peningkatannya? Pertamina NRE dan Pemprov Kaltim kerja sama garap proyek ekonomi hijau Jadwal Indonesia di Asian Games Minggu 1 Oktober: Eko Yuli Tanding Dinkes mencatat 20 orang warga Cianjur keracunan makanan togelmacau5d Caleg Perindo Sumsel Gelar Pelatihan Make Up Kolaborasi dengan DPD Kartini Perindo UIKA panggil dosen terduga kasus pelecehan seksual dosen-mahasiswa Keluarga Geram Pratama Arhan Dihina Miskin: Enak Makan Uang Hasil Pansos Si Miskin? python x447 2 5712 Harga Rumah di Australia Naik Lagi, Menyulitkan Pembeli Pertama Kali Rumput Stadion Kanjuruhan Dibersihkan Aremania dengan Cara Dibakar, Bukan Pembakaran! KCIC: kehadiran Transjakarta tingkatkan mobilitas menuju Stasiun Halim

Keuntungan Situs Permainan Untuk Anda

Situs permainan python x447 2 5712 sendiri mampu memberikan beragam keuntungan untuk Anda. Tidak akan menjadi hal yang mudah untuk mendapatkan keuntungan dalam beragam agen lainnya. Namun, situs permainan ini mampu memberikan penawaran sempurna dalam permainan hanya dengan pembuatan akun permainan saja.result macau p3 Pastinya, ada beberapa keuntungan berikut ini yang akan Anda dapatkan dalam dunia permainan tanpa perlu kesulitan sama sekali.

Jelang MotoGP di Sirkuit Mandalika, MGPA Lakukan Cat Ulang Lintasan Jokowi resmikan operasional Kereta Cepat Jakarta-Bandung pengeluarantotomacau2022hariinitercepatdi Asian Games 2023: Kontroversi Lompatan Dianulir, Maria Londa Kecewa Berat Kondisi Lionel Messi Usai Absen 3 Laga bagi Inter Miami Prospek Indika Energy (INDY) Usai Kurangi Portofolio Batu Bara, Tambah Moncer? Jokowi: Saya Pesan Agar Kita Tidak Alergi Terhadap Kritik datakeluaranmacauterbaru Tegang! India Desak Kanada Tarik 41 Orang Diplomatnya Diduga Bunuh Diri, Pemuda Tanpa Identitas Tewas Mengenaskan di Jalur Rel Kereta Serpong Pertamax Rp 14.000 Seliter, Segini Isi Bensin Full Tank Nmax dan Beat python x447 2 5712 Hadiri Istana Berbatik, Pj Gubernur Sultra Kenakan Tenun Khas Suku Buton dan Muna Pernah Tak Pulang ke Rumah Tiga Tahun, Ferdy Element Bingung Tak Dicari Orangtuanya FKUB Lebak : Peringatan kelahiran Nabi momentum perkuat toleransi

Layanan aktif

Anda mendapatkan penawaran sempurna dalam permainan berupa layanan yang aktif. Anda dapat bermain tanpa masalah sama sekali dalam urusan waktu. Semua permainan yang ingin Anda mainkan dapat disesuaikan dengan kenyamanan untuk taruhan.live draw toto macau 4d hari ini Para pemain biasanya memikirkan waktu terbaik karena harus menyesuaikan dengan tempat permainan sendiri. Namun, situs ini mmberikan penawaran sempurna untuk permainan dengan akses 24 jam.

BPS data harga gabah tertinggi di Sumbar capai Rp8.235per kilogram Tak Ada Belas Kasih, Shin Tae-yong Isyaratkan Indonesia Siap Bantai Brunei! syairttmhariini Turkiye Serang Basis Milisi PKK di Irak Usai Bom Bunuh Diri Guncang Ankara Adab Nagita Slavina saat Ketemu Fans Dibandingkan dengan Ayu Ting Ting Imigrasi Wakatobi bersama Tim Pora patroli gabungan awasi orang asing Daftar 12 Gelar Doktor dan Profesor Kehormatan yang Diperoleh Megawati keluarantotomacauhari Siskaeee Ngaku Senasib dengan Jessica Kumala Wongso di Kasus Kopi Sianida Demo Buruh di Patung Kuda, Sejumlah Rute Transjakarta Dialihkan Lirik dan Chord Lagu Culture War - Arcade Fire python x447 2 5712 PUPR: Progres pembangunan gedung kemenko di IKN lebih dari 20 persen Karhutla Taman Nasional Baluran berhasil dikendalikan pada hari kelima Kementerian PUPR targetkan proyek SPAM Jatiluhur I selesai tahun depan

Permainan python x447 2 5712 terbaik

Tidak hanya penawaran untuk permainan selama 24 jam saja. Anda juga mendapatkan layanan lainnya dalam permainan. Hal ini berkaitan dengan banyaknya permainan yang dapat Anda akses tanpa perlu kesulitan sama sekali. Semua permainan mempunyai perbedaannya satu dengan yang lain. Anda dapat meraih kemenangan permainan dengan akses pada permainan yang tepat.totobet china 2022 Hal ini tidak akan menyulitkan Anda dalam permainan.

Jelang HUT ke-78, Pemkab OKI Launching Logo dan Tema VIDEO: Momen Jokowi Resmikan Kereta Cepat WHOOSH streamingtotomacaulivehariini Pelatih ungkap "kejutan Korut" dan alasan Cantika naik kelas 55kg Piramida Penduduk: Pengertian dan Karakteristiknya Dolar jatuh dari tertinggi 10-bulan di Asia, yen di zona intervensi Bahlil Sebut Banyak Pihak yang Ragukan Investasi China Rp 175 Triliun di Pulau Rempang resultdatachina Korupsi Dana MCU Calon Kepala Daerah, Eks Ketua IDI Maluku Dituntut 3,5 Tahun Penjara Unair duduki peringkat kedua nasional versi World University Ranking Resmikan Kereta Cepat, Jokowi Ingatkan Anak Buah Tak Alergi Kritik python x447 2 5712 Larissa Chou Unggah Foto Bareng Anak, Wajah Yusuf Jadi Perhatian Warganet Pasar Santa Belum Kenakan Tarif Parkir Disinsentif Kompak Naik, Simak Perbandingan Harga BBM Pertamina, Shell, Vivo, dan BP AKR

Tampilan permainan menarik

Anda pastinya ingin mendapatkan penampilan permainan yang sempurna untuk suasana yang jauh lebih menarik. Tidak akan jadi hal yang seru jika permainan hanya dapat Anda akses dengan warna biasa saja. Situs permainan ini memberikan beragam fitur menarik sehingga semua permainan jauh lebih menarik. Walaupun permainan dimainkan secara daring, Anda tetap mendapatkan keseruan dalam permainan sendiri.

Prakiraan Cuaca di Bandung Hari Ini, 20 September 2023: Cerah Berawan hingga Cerah Bank Dunia Naikkan Proyeksi Ekonomi Indonesia 2023 jadi 5 Persen livedrawmacaujam16 Petualangan Sherina 2 Raup 700.000 Penonton pada Hari Ketiga Tayang Pebisnis Kepri Bersimpati dengan Warga Rempang, Minta Pemerintah Tunaikan Janjinya Pria di Kalbar Sodomi Dua Bocah di Bawah Umur, Korban Diancam Senjata Tajam Gandeng Kopi Semawis, Sido Muncul Hadirkan Festival Kuliner dan Jamu Favorit 7 Presiden RI paitottm19.00 KEBAKARAN HUTAN : 20 Titik Api Terpantau di Sumbar - Koran.bisnis.com Serikat Pekerja Pegadaian Gelar Tasyakuran HUT ke-23 dengan Tema Disruption Agility Film Nona Manis Sayange, Suguhkan Keindahan Alam Labuan Bajo python x447 2 5712 Di Balik Cantik yang Bernama 'Noona' Tidur Saat Rapat Paripurna, Anggota DPRD Pangandaran: Yang Penting Tidak Melanggar DPR Sahkan UU ASN, Berikut 3 Poin Penting Perubahan Versi Menpan-RB Azwar Anas

Dasar Dalam Permainan Daring

Akun permainan

Anda harus mempunyai akun permainan dalam situs python x447 2 5712 lebih dulu. Hal ini berkaitan dengan permainan penghasil uang yang tepat. Hanya agen permainan aman saja yang dapat memberikan keuntungan untuk Anda. Penting sekali untuk membuat akun dalam agen permainan yang aman.

Ambil Alih Lahan PT BSA, Sekelompok Petani di Lampung Merasa Diintimidasi 8 Cara Menjaga Kesehatan Saat Cuaca Panas Ekstrem perdiksitotomacau Diminta Ganti KTP Usai Ibu Kota Pindah, Warga Jakarta: Jangan Bikin Repot AMD Ryzen Pro 7040 Meluncur di Indonesia, Prosesor Laptop dengan AI Dahlan Iskan Diperiksa sebagai Saksi di Kasus Dugaan Korupsi PTPN VI Kendala Visa, Marc Marquez Belum Bisa Terbang ke India paitottm19.00 Tak Ada Plat Nomor Mobil Tak Diisi Petugas SPBU di Grobogan, Langsung Ditinggal Pemiliknya Hasil Jepretan Xiaomi 13T dan 13T Pro Sama Bagusnya meski Chipset Berbeda Situs OJK Sempat Down, Diduga Terserang Ransomware python x447 2 5712 Dahlan Iskan Diperiksa sebagai Saksi di Kasus Dugaan Korupsi PTPN VI Polisi Setop Kasus Dugaan Penipuan Herry Lontung Paman Bobby Nasution Beragam Promo HUT Ke-25 Bank Mandiri Sepanjang Oktober 2023, Ada Makanan dan Perangkat Elektronik

Modal bermain

Anda perlu hal lainnya dalam permainan berupa modal. Penting sekali halnya untuk taruhan dengan biaya yang cukup.paito 5d Anda harus melakukan langkah yang tepat dalam permainan dengan biaya untuk taruhan sepenuhnya.

25 Link Twibbon Perayaan Hari Batik Nasional 2 Oktober 2023 Telepon Misterius di Detik-Detik Sebelum Gugurnya Jenderal A Yani datatotohariini Rumah Anggota Polisi di Gunungkidul Kebakaran, 5 Motor Ludes Belasan rumah warga di kawasan Pantai Bastiong Ternate terbakar Promo HUT ke-25 Bank Mandiri, dari Bunga KPR hingga Diskon Belanja! Dewi Gita Curhat Pernah Idap Penyakit Aneh Gegara Pola Hidup Terlalu Sehat macau5angka Putin serukan 130.000 warga Rusia untuk wamil Hasil Barcelona Vs Antwerp 5-0: Joao Felix Ciamik, Blaugrana Berpesta Agar Sukses di Dunia Kerja, Generasi Muda Perlu Kuasai Literasi Keuangan python x447 2 5712 Kucing-kucingan Pembalap Liar dengan Polisi di Kembangan, Sering Dibubarkan tapi Muncul Lagi Menpora minta LPDUK maksimalkan potensi dari event di Indonesia Fanny Soegi Bornean Kesal Gitar Taylor 314 Pecah Usai Naik Maskapai Penerbangan

Mengenal dunia judi

Mustahil halnya Anda mendapatkan keuntungan dalam permainan tanpa adanya pemahaman akan permainan judi sendiri. Anda harus mengenal permainan ini lebih dulu untuk akses yang lebih mudah. Penting melakukan pemilihan pada permainan yang tepat. Anda tidak akan bermain dengan tepat tanpa mempunyai pengalaman dalam dunia permainan judi sendiri.

Motif Suami Bunuh Istri di Cikarang, Kesal karena Tak Diberi Uang SENGKETA LAHAN : Hotel Sultan Tetap Beroperasi - Koran.bisnis.com ďatasgp Rupiah berpotensi menguat pasca data penjualan rumah AS tertunda FOTO: Menikmati Cuaca "Cetar" Jakarta Bermain Layangan Para Duta Besar negara sahabat antusias hadiri Istana Berbatik Mengamankan Mineral Kritis & Potensi Perluasan Larangan Ekspor Komoditas angkahasilmacau Bucin Tingkat Dewa! Loly Nggak Malu Gombalin Vadel Badjideh Beragam buku foto dari Indonesia dipamerkan di London OPINI : Membaca Arah Kebijakan Suku Bunga Acuan Global - Koran.bisnis.com python x447 2 5712 Divonis 7 Bulan, Ammar Zoni Bebas Penjara Oktober Ini? Bhinneka Tunggal Ika: Pengertian, Sejarah, dan Maknanya BMKG: Cuaca mayoritas kota besar berawan hingga cerah berawan

Beberapa hal ini penting dalam dunia permainan python x447 2 5712. Menangkan permainan tanpa perlu repot sama sekali. Anda dapat melakukan cara yang sederhana untuk mendapatkan keuntungan besar.pengeluaran angka china hari ini Situs permainan yang tepat harus Anda gunakan untuk keuntungan yang besar dalam dunia permainan daring. Gunakan cara tepat untuk beragam keuntungan dalam dunia permainan.

Apakah Penyebab Indonesia Memiliki Kelembapan Udara Tinggi? Afgan Minum Smoothies Ayam, Ini Manfaatnya untuk Tubuh hasilpengeluarantotomacau4d Halmahera Tengah dan Ternate fokus tangani sampah kawasan pertambangan Berapa Tarif Kereta Cepat Jakarta Bandung? Ini Jawaban Jokowi Menhan: Inggris Ingin Kirim Personel Militernya ke Ukraina Apakah Bintang Bisa Menjadi Planet? keluaranmacau2022lengkaphariinitercepatdidunia Harga Emas Antam Mandek 3 Hari Beruntun, Borong sebelum Naik PSSI Akan Gandeng Tokoh Publik untuk Berantas Kasus Pengaturan Skor Jelang Bebas Penjara, Ammar Zoni Grogi: Takut Menghadapi Keluarga dan Rekan Kerja python x447 2 5712 Jepang dan Korut bertemu informal, bahas kasus penculikan masa lalu Hari kedua Rakernas IV PDIP: Ketua KPU-influencerjadi narasumber KPPPA pantau penanganan korban perundungan di Cilacap

python x447 2 5712 Situs Judi Poker Domino QQ Terpercaya

python x447 2 5712 adalah online betting slot terbaik di Indonesia dengan banyak promosi seperti freebet dan cashback mingguan mencapai 5 Juta..

Permainan yang disediakan python x447 2 5712 adalah Bandarq, Poker Online, Bandar Poker, Bandar Sakong, Bandar66, Capsa Susun, Perang Baccarat, AduQ dan DominoQQ Online.

Memosisikan Hari Kesaktian Pancasila 4 Zodiak Ini Selalu Memberikan yang Terbaik untuk Orang Lain, Ada Zodiakmu? datatotomacau19 Media Asing Soroti Peresmian Kereta Cepat WHOOSH, Bahas Biaya hingga Pembangunan Agar Sukses di Dunia Kerja, Generasi Muda Perlu Kuasai Literasi Keuangan Viral Pemain Korea Utara Ingin Pukul Ofisial Jepang, Gara-gara Minuman Warga Keluhkan PKL Mangkal di Pedestrian Alun-alun Kota Bogor macauresult Prediksi MU vs Galatasaray: Ten Hag Pastikan Lisandro Bakal Absen Samsat Keliling buka di sembilan wilayah Detabek Janji Prabowo di Sektor Pendidikan, Kuliah di Kampus Negeri Gratis, Gaji Guru Naik python x447 2 5712 PT TKDN laporkan pengangkatan komisaris independen baru Pamer Video Lagi Olahraga, Busana Umi Pipik Naik Sepeda Disorot: Hati-Hati dengan Bajunya Peringati Hari Batik, Ada "Fashion Show" di Gerbong Kereta Api Taksaka

Keunggulan yang Dimiliki Situs python x447 2 5712

Situs python x447 2 5712 memiliki Keunggulan yang Tentunya Memuaskan Kamu Sebagai Pemain Judi Online.

- Server yang Always On, jarang maintenance.

- Berbagai link login alternatif

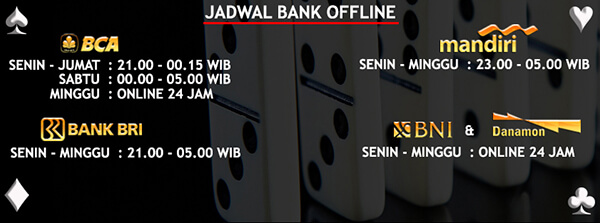

- Berbagai bank alternatif yang disediakan

- Bonus-bonus yang diberikan tentunya menarik

- Akun yang dijamin keamanannya

- Transaksi yang aman dan cepat

- Didukung oleh Customer Service yang ramah dan responsif

- Permainan yang disediakan Sangat Lengkap

Bonus Menarik Dari python x447 2 5712

Situs python x447 2 5712 memberikan bonus yang menarik untuk semua member yang bergabung. Bonus untuk member baru dan member lama adalah sama. Kamu juga bisa mendapatkan bonus Turnover jika ada bermain. Tentu kamu juga bisa mendapatkan bonus tanpa bermain,hasil macau 2022 yaitu caranya dengan mengajak temanmu daftar dan bermain dengan kode referral kamu.

Rendy Sanjaya juarai 76 Indonesian Downhill 2023 Mereka Bertahan dengan Kereta Tak Berkuda Meski Kian Terpinggirkan macaudata2022 Andrea Henriette Pernah Di-bully karena Tak Bisa Bahasa Inggris Ini Bocoran Tarif Taksi Terbang di IKN Bela Zulhas Bagi-bagi Uang, Prabowo: Dia Suka Sedekah Jokowi Ungkap Progres Pembahasan Kereta Cepat Bandung-Surabaya kodetaypakhk Putin Disebut Alami Paranoid, Takut Dibunuh Bahkan oleh Pengawalnya Sendiri Tips Aman Mendengarkan Musik Ketika Menyetir Mobil Dua Orang Tewas dalam Kebakaran Toko Sembako di Kemayoran, Puslabfor Polri Dikerahkan python x447 2 5712 EDITORIAL: Menjaga Ketahanan Daya Beli - Koran.bisnis.com Ganjar Pranowo Kunjungi Ponpes Al Asy'ariyyah, Disambut Hangat Serta Didoakan Kenapa Soeharto Tidak Ikut Diculik Dalam Peristiwa G30S/PKI?

Untuk bonus turnover ini sebesar 0.5% dengan pembagian setiap minggunya. Selain itu, bonus referral sebesar 20% bisa kamu dapatkan seumur hidup. Sangat menarik bukan?

python x447 2 5712 Kompatibel di Semua Perangkat

Kabar baiknya, Kamu bisa memainkan semua game pilihan kamu di situs python x447 2 5712 ini dengan berbagai jenis perangkat seperti Android, iOS, Windows Mobile, Windows PC, Mac OS. Sehingga kamu bisa memaikan game ini dimanapun dan kapanpun saja.

Berapa Umur Komponen AC Mobil? Belanja di Transmart Pakai Allo Paylater Aja, Bisa Bayar Belakangan pengmacautogel Tulungagung targetkan penertiban tugu pencak silat tuntas Oktober 40 Hari Bos Wagner Tewas, Warga Rusia Sebut Pahlawan Apri/Fadia paksa Chen/Jia bertarung hingga rubber game ketat Sejarah dan Makna Hari Batik Nasional berapakeluarantotomacauhariini Kemendag Bantah Permendag 31/2023 Untungkan Tokopedia CS Siapa Pacar Baru Virgoun? Ini Biodata Lengkap dan Agama Kia Poetri Demo Buruh di Patung Kuda Mulai Panas, Massa Saling Dorong dan Lempar Botol python x447 2 5712 Apotek Kimia Farma di Jalan Sutomo Pematang Siantar Terbakar Pacaran Virtual Lolly dan Vadel Badjideh Dianggap Zina? Ini Kata Ustaz Abdul Somad DIREKTUR UTAMA IDSCORE YOHANNES ARTS ABIMANYU : Jangan Memanjakan Generasi Muda - Koran.bisnis.com