scikit learn 6 17283 | Link Alternatif Slot Olympus Gacor Hari Ini rupython

Yuk, Intip Lebih Dalam Situs scikit learn 6 17283 Yang Berkualitas

aplikasilivedrawsdy "I wish to introduce a gentleman to you; Lieutenant Passford, let me make you acquainted with Lieutenant Passford," said the commander as he led the way into the captain's cabin. pàitohk Mr. Camden took off the irons, for he had a key to them, and enclosed the wrist in the new pair. Then the two men were directed to take his right arm, which they did, and drew his hand from his nose. This act roused the ire of Flanger, and he began to struggle; but powerful as he was, the two seamen were too much for him, and he was fairly handcuffed. The second lieutenant was the officer of the deck, and he was sent back to his post of duty. Flanger's face was so covered and daubed with the gore from his wound that the 287 condition of his prominent facial member could not be determined. scikit learn 6 17283 The steamer had been so successful while in command of Captain Blowitt in breaking up the shipping of cotton in a port where a larger vessel could not operate, that Christy promptly concluded that she was to be used in a similar enterprise. The listener was amused rather than impressed by the conversation which was in progress so near him, and especially at the display of dignity and authority on the part of his cousin.

Yuk, Intip Lebih Dalam Situs scikit learn 6 17283 Yang Berkualitas! Bermain tentunya menjadi salah satu kegiatan dari sedikitnya kegiatan menyenangkan yang dapat Anda lakukan. Jelas saja,scikit learn 6 17283 berbeda dengan bekerja, saat bermain semua beban yang ada dalam benak Anda akan menghilang. Maka karena itu, menjadi hal yang sangat wajar bila saat ini semua dari Anda dapat menemukan aplikasi permainan di ponsel dengan mudah.

"I go for de doctor if he's dar," said Job. togelkentuckymid While he was still considering the subject, he heard the call for "All the port watch!" on deck, and Mr. Camden came below to wake the third lieutenant, for the routine was hardly in working order on board of the steamer. The commander went into his stateroom, and soon returned with the sealed envelope in his hand. He was deeply interested in its contents, for he hoped his vessel was ordered to take part in the Mississippi expedition, which was to attack Forts Jackson and St. Philip, and capture the city of New Orleans. Eight bells had been struck, indicating midnight, which was the hour at which he was directed to break the seal. The first lieutenant was quite as much interested in ascertaining the destination of the Bronx as the commander. Christy had invited him to his cabin. "It is all of two months since I had any news in regard to him. He is still a soldier and has not yet been promoted. His company is still at Fort Gaines; but he has been sent away once or twice on detached duty. He is not given to writing many letters; but the last time I was in Mobile I was told that he had again been sent off on some sort of secret service with a naval officer by the name of Galvinne. I do not know whether the report was true or not." "How many men have you on board, Captain Flanger?" demanded the third lieutenant, still standing up in the boat abreast of the person he addressed. tarikanpaitosidney "I thank you for the suggestion, Mr. Passford, and I must say that you seem to be entirely fair," said the commander. scikit learn 6 17283 "Are you sure of this information, Mike?" "I wish to introduce a gentleman to you; Lieutenant Passford, let me make you acquainted with Lieutenant Passford," said the commander as he led the way into the captain's cabin.

Akan tetapi, selain menggunakan aplikasi, ada hal lain yang dapat Anda gunakan untuk bermain. Hal tersebut adalah jelajah internet yang masih menjadi bagian dari ponsel Anda. Dengan menggunakan jelajah internet ini, ada banyak permainan menarik yang dapat Anda temukan pula. Salah satunya adalah permainan yang telah menjadi incaran masyarakat luas sejak zaman dahulu.data warna sgp Bahkan, beberapa dari Anda juga mungkin akan memilih permainan ini.

Benar sekali, hal ini dikarenakan hadiah kemenangan yang diberikan oleh permainan yang ada dalam situs ini adalah uang. Tepat sekali, judi menjadi nama lain dari permainan yang saat ini dapat Anda mainkan dalam situs dengan nama scikit learn 6 17283 ini. Kami menyarankan semua dari Anda untuk langsung mengunjungi situs yang kami sebut sebelumnya saja saat ingin bermain. Hal ini dikarenakan situs yang kami sebutkan merupakan laman yang aman.

"Twenty-eight years." okgooglepengeluaransidney "Make the course south-west, Mr. Flint," said the commander, as soon as the vessel was ready, and her screw was in motion. 338 "South, sir," replied the quartermaster. "You think that method would suit you better than the usual one of delivering orders verbally," said Christy, laughing as much at the coolness as at the impudence of his companion. datapengeluaransydneymingguan CHAPTER VI THE CONFERENCE IN THE CAPTAIN'S CABIN "Wounded, you"— The steamer went ahead slowly; but the steam was hissing, and she seemed to be as impatient as a fiery horse at the slow starting. scikit learn 6 17283 It was some little time before Mr. Galvinne presented himself, for probably he did not feel bound to obey the orders of the bogus captain with especial promptness. However, he came after a quarter of an hour, and seated himself familiarly in an arm-chair at the table. He had the bearing of the superior officer, to which Corny made no objection. "I have been living on a hot gridiron for the last ten days, and in the first moments of freedom I overstepped the limits of propriety. I hope we understand each other now, for we are engaged in an important enterprise, and we cannot afford to be at variance," replied the naval officer. "Our work is yet unfinished, though it has progressed admirably so far. Have I your permission to open this sealed envelope?"

Jelas saja, ada banyak keuntungan yang diberikan oleh laman ini dan tidak hanya berlaku untuk pemenang. Benar, hal ini dikarenakan keuntungan ini berlaku untuk semua dari Anda yang menjadi anggota dari situs ini. Lebih tepatnya, keuntungan ini dapat Anda peroleh dari banyaknya pelayanan terbaik yang biasanya tidak diberikan laman lain.data hk 6 d Mengetahui hal ini tentunya membuat Anda merasa penasaran dengan laman ini, bukan?

paitowatnahk "Looking at you more closely, I see that you are not my patient, and you will excuse me for giving you a headache. But you resemble my patient very closely," added the doctor. datahkpools6d The young officer declared he had nothing there to steal. As he spoke, he took from his coat pocket on the bedpost an envelope containing his commission and other papers. It was safe; so were his purse and watch. scikit learn 6 17283 When he rushed back to the cabin, Flanger had got the better of his foe, and had risen to his feet, with his grasp upon the throat of the steward. Then he hurled him from him with a vigorous movement with his left hand, while he raised the right with the evident intention of shooting him. The commander saw the imminent peril of Dave; he took a hasty aim and fired before the intruder had time to do so. He was a good shot with the navy revolver, for he had taken lessons and practised a good deal with the weapon. "You did not always eat the fish you caught," suggested Christy.

Secara Singkat Situs scikit learn 6 17283 Untuk Anda

Kami akan menjawab semua rasa penasaran Anda mengenai situs ini terlebih dahulu. Dengan melakukan hal ini, maka semua pertanyaan yang ada dalam benak Anda tentunya akan menghilang. Sebab, kami akan membuat Anda mengetahui laman ini secara lebih dalam lagi. Hal paling awal yang harus Anda ketahui mengenai laman ini adalah kemudahan yang diberikan kepada Anda sebagai anggota dari laman.

hongkongspools "I am a non-combatant, Christy," replied Colonel Passford. "I have not served in the Confederate army or navy, or even been a member of a home guard." "Don't you know me, Dave?" asked Christy, speaking out plainly so that the steward might recognize his voice. Quartermaster Vincent was placed in charge of the wheel, with Boxie as helmsman. All that could be done to protect the pilot-house had been done, though it was not yet supposed to be proof against the musket ball that would be fired in that direction. All the men not absolutely needed for 348 duty were sent below, but they were armed with revolvers and cutlasses, ready for service at any instant. The officers retired from the bridge, for it was folly for any one to be unnecessarily exposed to the musketry fire from the loopholes of the fort. sd6d "No, sar; can't spell noffin." scikit learn 6 17283 "Then you can tell me better than any one else in regard to my status on board of the Bronx," added the colonel, who had won this title years before in the militia. "Am I considered a prisoner of war?" "But don't you believe it will be better to appeal to the flag-officer?" asked the second lieutenant.

Saat memutuskan untuk menggunakan situs ini, maka semua dari Anda akan menemukan nominal deposit yang wahai hingga permainan yang beragam. Hal ini jelas merupakan keuntungan untuk semua dari Anda. Akan tetapi, keuntungan ini juga masih menjadi bagian kecil dari situs yang ini.

Tentunya,rekap 2d togel hal ini dapat terjadi karena ada lebih banyak keuntungan yang akan menjadi milik Anda. Beberapa keuntungan tersebut akan menjadi hal yang Anda temukan dalam kalimat selanjutnya. Maka karena itu, cari tahu bersama kami dengan tetap menyimak setiap kalimat yang ada dengan baik.

"I am only sorry that he is fighting on the wrong side," added Christy, as he observed the 347 earnestness of the officer in the discharge of his duty. "Is he an old man?" "I was sick, and I wished to be as near the Vernon as possible. I felt better in the afternoon and attended to my affairs; but I got bad again in the afternoon, and I came on board in the evening, for I was afraid I should not be able to 68 do so in the morning," answered the invalid, becoming as lively as before. He rang the bell, and the sound from it reverberated through the entire mansion. It was some time before a servant came to open the door; but the man who let him in was astonished to see him partially dressed, and wondered if he had not been walking in his sleep. In the lower hall, he was satisfied that the whole house was astir, for the gong which had sounded was the "emergency 21 bell," used only when the ordinary one at the front door was not likely to be heard. The cutter came up at the gangway of the 218 Bronx, and Christy was standing on the rail, anxious to learn what the boat had accomplished. He had heard the report of the volley fired at the cutter, and had been very solicitous for the safety of her crew. He had weighed anchor as soon as he heard the sounds, and proceeded in the direction from which they came. "All right: I will count you first," added Mr. Pennant, as he reached over and seized the leader of the party by the collar with his right hand. paitosgpangkanetharian This was a correct answer, and Christy saw that his cousin had fully armed himself for his daring scheme, whatever it was. scikit learn 6 17283 "It is the name of my father's place," replied Corny; and Christy, who was observing him very closely, saw that he was a little disturbed. There was a silence for a few moments.

Keuntungan Situs Permainan Untuk Anda

Situs permainan scikit learn 6 17283 sendiri mampu memberikan beragam keuntungan untuk Anda. Tidak akan menjadi hal yang mudah untuk mendapatkan keuntungan dalam beragam agen lainnya. Namun, situs permainan ini mampu memberikan penawaran sempurna dalam permainan hanya dengan pembuatan akun permainan saja.angka paito sydney Pastinya, ada beberapa keuntungan berikut ini yang akan Anda dapatkan dalam dunia permainan tanpa perlu kesulitan sama sekali.

paytowarnasdy "You can consult your own inclination as to that, my excellent friend. I shall not force you 285 to be treated by him," added Christy, "But I must suggest that this farce has been carried far enough in my cabin." "What's the trouble here, Captain Passford?" asked Dr. Connelly, presenting himself at the door of the cabin. "Didn't I hear the report of a firearm in this direction just now?" pengeluarandatasydney2020 "Who is Peach?" asked Christy, who had been at home so little that he hardly knew the names of the servants. "In that case, probably Mike was with him, and he may be a useful man to us as a pilot," replied Christy. "The commodore says the Western Gulf squadron had no steamer that was suitable for this service, for there is only nine feet of water on the bar of Barataria at low water. For this reason he had been requested to send the Bronx, not only on account of her light draft, but of her speed." scikit learn 6 17283 "You did not always eat the fish you caught," suggested Christy.

Layanan aktif

Anda mendapatkan penawaran sempurna dalam permainan berupa layanan yang aktif. Anda dapat bermain tanpa masalah sama sekali dalam urusan waktu. Semua permainan yang ingin Anda mainkan dapat disesuaikan dengan kenyamanan untuk taruhan.paoto taiwan Para pemain biasanya memikirkan waktu terbaik karena harus menyesuaikan dengan tempat permainan sendiri. Namun, situs ini mmberikan penawaran sempurna untuk permainan dengan akses 24 jam.

"I believe you; they be mixed if you be the captain when I done seen him on deck just now." "I had not the honor to communicate with you yesterday before the Bronx sailed for her destination; but I believe you were called upon to decide upon the identity of the officer who presented himself to you as the lieutenant appointed to the command of the Bronx, introduced by Captain Battleton of the Vernon." paitowarnacambodia2021 "But the conspirators do not intend that any issue shall be raised until the vessel is under the 139 guns of a Confederate fort. Doubtless Mr. Galvinne, whom I look upon as the actual commander of the steamer, for Corny is no sailor, will run into Pensacola Bay under the American flag. Probably he is a pilot in these waters, and knows what signal to make to the Confederate forts." "Is that you, Pink Mulgrum?" demanded Dave. "I give you the whole State of Alabama, but I thought we done rid of you long ago. Who's there?" keluaranoregono3 "One bell, sir," repeated the petty officer at the wheel. "A prisoner of war!" exclaimed the steward. "The commander of the ship a prisoner!" scikit learn 6 17283

Permainan scikit learn 6 17283 terbaik

Tidak hanya penawaran untuk permainan selama 24 jam saja. Anda juga mendapatkan layanan lainnya dalam permainan. Hal ini berkaitan dengan banyaknya permainan yang dapat Anda akses tanpa perlu kesulitan sama sekali. Semua permainan mempunyai perbedaannya satu dengan yang lain. Anda dapat meraih kemenangan permainan dengan akses pada permainan yang tepat.paito taiwan 2021 Hal ini tidak akan menyulitkan Anda dalam permainan.

paitohk6dangkanetharian "How many men have you on board, Captain Flanger?" demanded the third lieutenant, still standing up in the boat abreast of the person he addressed. paitowarnahongkongangka.net "I have no idea of its strength; but I do not care to have the Bronx knocked to pieces by the big guns of a fort. The bar of Barataria and the shoal water of the entrance to the bay extend out about two miles into the Gulf. At low water, two miles from the fort, we should bury our keel in the mud. It looks just now as though we should have to put the Bronx under the guns of the fort, or simply blockade the entrance to the bay. That makes it look like a quiet time in these waters." scikit learn 6 17283 "Boat alongside, sir," reported a quartermaster. On his arrival in New York he hastened across the ferry to the navy-yard. As he approached the opposite shore, he discovered a steamer getting under way. He had not seen the vessel on board of which he was ordered to report as a passenger, but when he asked a deck hand what the steamer was, he was informed that it was the Vernon. The ferry-boat had just gone into the slip, and Christy was terribly startled to learn that he was late. He was still two hours ahead of the time indicated in his orders, and the Vernon was actually getting under way.

Tampilan permainan menarik

Anda pastinya ingin mendapatkan penampilan permainan yang sempurna untuk suasana yang jauh lebih menarik. Tidak akan jadi hal yang seru jika permainan hanya dapat Anda akses dengan warna biasa saja. Situs permainan ini memberikan beragam fitur menarik sehingga semua permainan jauh lebih menarik. Walaupun permainan dimainkan secara daring, Anda tetap mendapatkan keseruan dalam permainan sendiri.

Suddenly the officer started back, and began to look very sharply at the presumed sailor. But the file pressed behind him, and Christy was too glad to move with it to delay a moment longer. He went below to the familiar quarters of the crew, and saw many of his old seamen still on board, though many of them had been taken to reinforce other vessels. datatogeljepang "I'm the one for your money," returned the oarsman, as he headed his boat into the slip. "You will call all hands, Mr. Flint," said the commander, as soon as the executive officer appeared on the deck; and the call of the boatswain's mate sounded through the vessel. "Don't you know?" keluaranmissourievening scikit learn 6 17283 "We lie about south of what Mike calls the big house, a mile and a half distant from it. Make the boat's course north north-west, and you will strike the shore about half way between the planter's house and the fort. But when you get near enough to see both of them, you can land where you think best," Christy explained.

Dasar Dalam Permainan Daring

Akun permainan

Anda harus mempunyai akun permainan dalam situs scikit learn 6 17283 lebih dulu. Hal ini berkaitan dengan permainan penghasil uang yang tepat. Hanya agen permainan aman saja yang dapat memberikan keuntungan untuk Anda. Penting sekali untuk membuat akun dalam agen permainan yang aman.

"I am sorry that you are dissatisfied with my third lieutenant's mode of operations," replied Christy, laughing, though his mirth was of the graveyard order. "But Mr. Pennant is a new officer, and that was the first active duty he had been called upon to perform. Very likely he will suit you better next time." bolamerahsydney6d It was a living being, or it would not move, and he was certain that he had made a discovery. Then two regrets flashed through his mind as he stepped down from the veranda; the first, that he had not put on his shoes before he left his chamber, and the second, that he had not taken his pistols, for a bullet would travel a great deal faster than a barefooted officer, even of the United States Navy. But he ran with all his speed to the street, to the great detriment of his uncovered feet. "Has she any big guns?" tarikanpaitohkmalamini2022 The course was believed to be correct for the point indicated by the captain, and in less than half an hour the boat grounded; but the shore was bold enough to enable the men to land. Mr. 316 Pennant went to the forward part of the boat and took a careful look all around him. All was as silent as a tomb. Stepping into the fore-sheets, he leaped on shore, directing the Russian to follow him. "I am glad to hear it. Have you informed him that we have another lieutenant on board of the Vernon?" continued the commander. scikit learn 6 17283 The watch below were all around him. Some of them were mending their clothes, others were reading newspapers they had brought with them, but the greater part of them were in squads engaged in talking about the events of the war. 104 The nearest group to Christy were conversing about the two lieutenants who claimed to be the real officer ordered to the command of the Bronx. It seemed rather strange to the listener that they should know anything about the events which had happened in the secrecy of the captain's cabin, and this circumstance led him to believe that at least one of the officers of the ship must be a confederate of Corny.

Modal bermain

Anda perlu hal lainnya dalam permainan berupa modal. Penting sekali halnya untuk taruhan dengan biaya yang cukup.paito warna 6d angkanet Anda harus melakukan langkah yang tepat dalam permainan dengan biaya untuk taruhan sepenuhnya.

"Now, Mr. Pennant, you may remove your bag to the ward room, and the third stateroom on the starboard side, counting from the forward one, is yours for the present," continued Christy. "What are those men doing aft, Mr. Byron?" demanded the first lieutenant, with some excitement in his manner. "They were very nearly on the quarter-deck, and they seemed to be very reluctant to go forward." paitooregon03.00 "That is plain enough; and we only escaped it because you took it into your head to leave the Vernon at the time you left her. I think the Bronx would have gone into Pensacola Bay without 172 the least trouble, for I have no doubt Galvinne knew just what signals to make to Fort McRae, and just as well what ones to make to Fort Pickens. The ship would have been there by midnight, and up to that time I should have been asleep in my stateroom; and they would not have taken the trouble to call the watch below at that hour." "Then the report of the light on the starboard bow places it directly to the eastward of us," added Christy. "That is about where the entrance to St. Andrew's Bay ought to be, if my calculations were correct. We have been running to the eastward since we left the blockaders' station off Pensacola Bay. My ruler on the chart gave me that course, and Mr. Galvinne followed it while he was in charge. We could not have got more than half a mile off the course in coming about twice. The shoaling of the water also indicates that we are all right." "This will never do, Passford," said the tyrannical officer. datapaitooregon9 184 "Is he a prisoner?" asked Corny, as he got out of the berth. "My name is Ralph Pennant; I have a sea-going 119 name, and I suppose that is the reason why I went to sea," replied the seaman, with a good-natured laugh. "I have been the mate of a steamer, but I could not get any better position than that of able seaman, and I wanted to be in this stir-up." The surgeon was satisfied with this evidence. scikit learn 6 17283 "If he had done so, I should not have complained. I have been a prisoner of war, and I had to take my chances. We may be in action for aught I know in a few hours, and I do not mean to have half a dozen rebels at my heels to trip me up if I can help it. The circumstances are entirely different from those on board of the Vernon." "Indeed!" exclaimed Christy, not a little startled at the information thus communicated, for it was plain enough that the intruder meant mischief in spite of his good manners. "I was under the impression that you had taken up your abode on board of the flag-ship with others who were captured in the Magnolia."

Mengenal dunia judi

Mustahil halnya Anda mendapatkan keuntungan dalam permainan tanpa adanya pemahaman akan permainan judi sendiri. Anda harus mengenal permainan ini lebih dulu untuk akses yang lebih mudah. Penting melakukan pemilihan pada permainan yang tepat. Anda tidak akan bermain dengan tepat tanpa mempunyai pengalaman dalam dunia permainan judi sendiri.

CHAPTER XVIII A BATTLE ON A SMALL SCALE pengeluaranbolamerahhk "But Christy would have found plenty of witnesses here: the second lieutenant and the seamen on board of the Bronx, for example." sidneyjaya scikit learn 6 17283

Beberapa hal ini penting dalam dunia permainan scikit learn 6 17283. Menangkan permainan tanpa perlu repot sama sekali. Anda dapat melakukan cara yang sederhana untuk mendapatkan keuntungan besar.keluaran paito hongkong Situs permainan yang tepat harus Anda gunakan untuk keuntungan yang besar dalam dunia permainan daring. Gunakan cara tepat untuk beragam keuntungan dalam dunia permainan.

"If he does that, so much the better, for we shall have more time to prepare for a decided stroke," replied Christy. "I have my plan all ready, though of course it may fail, and to-night we may all be prisoners of war." sgpwarnapaito "Perhaps you builded better than you knew; but if you had not escaped from the Vernon, and managed the whole affair, it would have been a success," added Mr. Flint. datahongkong6dhariini "I was sick, and I wished to be as near the Vernon as possible. I felt better in the afternoon and attended to my affairs; but I got bad again in the afternoon, and I came on board in the evening, for I was afraid I should not be able to 68 do so in the morning," answered the invalid, becoming as lively as before. 366 He was too feeble from the effects of his wounds, for that in the thigh had proved to be more severe than the surgeons had indicated, to tell the exciting story of the escapade of Corny Passford; but when he did relate it, three weeks later, it thrilled the listeners for three whole evenings. 346 "I understand the situation perfectly, Captain Passford, and I will report when we are ready to go ahead in the manner you desire," replied Mr. Sampson, as he saluted the captain and hastened below. scikit learn 6 17283 366 He was too feeble from the effects of his wounds, for that in the thigh had proved to be more severe than the surgeons had indicated, to tell the exciting story of the escapade of Corny Passford; but when he did relate it, three weeks later, it thrilled the listeners for three whole evenings. Lieutenant Fourchon pressed the hand of the doctor, and left the casemate with him.

scikit learn 6 17283 Situs Judi Poker Domino QQ Terpercaya

scikit learn 6 17283 merupakan situs judi slot games online, sportsbook, live casino, poker, tembak ikan, scikit learn 6 17283 online terbaik. Agen789 menyiapkan link login ke dalam menu..

Permainan yang disediakan scikit learn 6 17283 adalah Bandarq, Poker Online, Bandar Poker, Bandar Sakong, Bandar66, Capsa Susun, Perang Baccarat, AduQ dan DominoQQ Online.

tarikanwarnahk warnacambodia scikit learn 6 17283

Keunggulan yang Dimiliki Situs scikit learn 6 17283

Situs scikit learn 6 17283 memiliki Keunggulan yang Tentunya Memuaskan Kamu Sebagai Pemain Judi Online.

- Server yang Always On, jarang maintenance.

- Berbagai link login alternatif

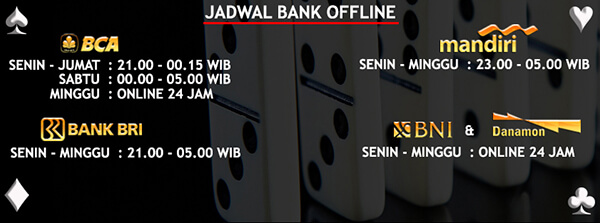

- Berbagai bank alternatif yang disediakan

- Bonus-bonus yang diberikan tentunya menarik

- Akun yang dijamin keamanannya

- Transaksi yang aman dan cepat

- Didukung oleh Customer Service yang ramah dan responsif

- Permainan yang disediakan Sangat Lengkap

Bonus Menarik Dari scikit learn 6 17283

Situs scikit learn 6 17283 memberikan bonus yang menarik untuk semua member yang bergabung. Bonus untuk member baru dan member lama adalah sama. Kamu juga bisa mendapatkan bonus Turnover jika ada bermain. Tentu kamu juga bisa mendapatkan bonus tanpa bermain,paito harian hk warna yaitu caranya dengan mengajak temanmu daftar dan bermain dengan kode referral kamu.

The captain asked Corny a hundred questions in regard to the estate, making memoranda of his answers. Once he suggested to the surgeon that he had better examine the pulse of his patient, for he did not wish to overtask him in the investigation. The subject of the inquiry declared that his headache had almost disappeared, and he needed no indulgence on account of his health. "I am sure I do not know. I called in the coachman, and he has been to his room and looked all over the place without finding him." paitowarnasydneylengkap "Invite the first lieutenant to the captain's cabin," said Dave. "Yes, sir;" and the steward left the cabin. Christy obeyed the order of Captain Battleton when he was directed to report below; but he felt that he was permitting the plot of his cousin to be carried out without any opposition, and without any attempt to check its progress. But he was a prisoner, and he realized that he could do nothing. His case had been tried, and he had been condemned to his present condition. It was useless to appeal to the captain, for he had already passed upon all the facts that had been presented before him. "I thought you were somewhat changed in your looks when I saw you come on board of the Bronx, and then I felt that the greeting you gave me was rather stiff for an old comrade who had 137 passed some time with you in a Confederate prison," added Mr. Flint. "But what are we going to do, Massa Christy?" asked the steward, dazzled by the situation. livecaliforniatogel "Ensign Gordon Fillbrook," replied Corny promptly. "Hardly; both of them claim to be the same officer, and I have invited you to assist me in deciding which is the real Mr. Passford." scikit learn 6 17283 While the crews were making the boats ready, and Mr. Camden was selecting the extra men for them, as he was instructed to do, Christy gave the executive officer a brief account of the capture of the sloop, and an epitome of the information he had obtained from Bornhoff. "I done wish dat Massa Linkum come down here hisself," added the venerable colored person. "We are bound to the westward, and the course looks as though we might be ordered up the Mississippi," suggested Mr. Flint.

Untuk bonus turnover ini sebesar 0.5% dengan pembagian setiap minggunya. Selain itu, bonus referral sebesar 20% bisa kamu dapatkan seumur hidup. Sangat menarik bukan?

scikit learn 6 17283 Kompatibel di Semua Perangkat

Kabar baiknya, Kamu bisa memainkan semua game pilihan kamu di situs scikit learn 6 17283 ini dengan berbagai jenis perangkat seperti Android, iOS, Windows Mobile, Windows PC, Mac OS. Sehingga kamu bisa memaikan game ini dimanapun dan kapanpun saja.

"He said he believed you were bony fido commander of the Bronx, and he is ready to obey your orders. Mr. Flint had a talk with him while the first lieutenant was below; he talked to Boxie, and three more of the men, and he did it mighty sly, too, for the third lieutenant was on the deck all the time. There's eight bells, Massa Christy, and the second lieutenant will have the deck." paitoseoullottery "I suppose they have seen that the course of the ship has been changed, and I thought they might have come aft to ask some questions, 166 though the men ought to be better trained than that," added Mr. Galvinne, as he came quite near the companion-way where the second lieutenant was waiting for him, with Christy behind him, and ready to support him. "That is very odd," mused the officer, wondering whether this sudden disappearance had anything to do with the principal event of the preceding night. "The flag officer has not told me yet what he is about, and I am not good at guessing, though I am a Yankee," replied the man chuckling, as though he believed he had said something funny. statistiksydney "You don't like it!" exclaimed the engineer of the Bellevite. scikit learn 6 17283 Seated on the side of his berth he considered the situation very faithfully. The Bronx lay off St. Rosa's Island; she was on the blockade, evidently ready to trip her anchor, whenever occasion should require. In regard to her officers Christy only knew that Mr. Flint was in temporary command of her, in place of Mr. Blowitt, 115 who had become the executive officer of the Bellevite. The other officers must have been appointed for temporary service. "He could not have been disturbed until you spoke to him; and he might have ransacked the whole of the lower part of the house."