urlib urlretrieve 53376 | Data undian live draw 2025 terlengkap dan tercepat rupython

Yuk, Intip Lebih Dalam Situs urlib urlretrieve 53376 Yang Berkualitas

RI Larang Masuk Warga dari 3 Negara, Investasi Bakal Loyo? Suso: Saya Ingin Kembali Ke Liverpool | Goal.com Indonesia ereksandal Lionel Messi & Deretan Legenda Tanpa Trofi Copa America | Goal.com Covid RI 'Meledak' Lagi: Kasus Baru 1.678, Kasus Aktif 10.000 Berita PSIS Semarang v Borneo, 26/10/19, Liga 1 | Goal.com Borneo FC Resmi Rekrut Eks Bek Liverpool | Goal.com Indonesia totoprize123 Bamsoet Desak Tambah Personel TNI-Polri Amankan Papua Strategi Anti Krisis Dari Menkes Jika Pandemi Datang Lagi Tak Ada Jaminan Tempat Buat Wayne Rooney | Goal.com Indonesia urlib urlretrieve 53376 Ada WNI, Kapal Evakuasi Warga Sipil dari Sudan Tiba di Saudi Respons Pratama Arhan Ditaksir Klub Korea Selatan Daejeon Hana | Goal.com Indonesia RESMI: Wolfgang Pikal Mundur Dari Persebaya Surabaya | Goal.com Indonesia

Yuk, Intip Lebih Dalam Situs urlib urlretrieve 53376 Yang Berkualitas! Bermain tentunya menjadi salah satu kegiatan dari sedikitnya kegiatan menyenangkan yang dapat Anda lakukan. Jelas saja,urlib urlretrieve 53376 berbeda dengan bekerja, saat bermain semua beban yang ada dalam benak Anda akan menghilang. Maka karena itu, menjadi hal yang sangat wajar bila saat ini semua dari Anda dapat menemukan aplikasi permainan di ponsel dengan mudah.

Alas Kaki Indonesia Vs Vietnam, Siapa Lebih Unggul? Federico Dimarco: Tidak Pernah Mudah Menang Di Torino | Goal.com Indonesia tholaalbadruarab PM Malaysia Anwar Ibrahim Atur Skema Subsidi, Bakal Mirip RI? Berita Genoa v Atalanta, 15/05/21, Serie A | Goal.com Ole Gunnar Solskjaer: Marcus Rashford Tetap Jadi Penendang Penalti Manchester United | Goal.com Indonesia APBN KiTa: Hadapi Corona APBN Difokuskan Untuk Kesehatan liriklagujodhaakbar Prancis Vs Argentina Extra Time, Drake Kalah Taruhan Rp15,6 M Ahli Dukung Jumlah Bandara Internasional Dikurangi, Kenapa? Simon Mignolet: Liverpool Sangat Dambakan Gelar | Goal.com Indonesia urlib urlretrieve 53376 Pasien Isoman Covid-19 Terlambat Dapat Obat, Jokowi Bertindak VISA Beres, Alexis Sanchez Segera Susul Skuat Manchester United Ke Amerika Serikat | Goal.com Indonesia REVIEW Eredivisie Belanda: PSV Telan Kekalahan Perdana | Goal.com Indonesia

Akan tetapi, selain menggunakan aplikasi, ada hal lain yang dapat Anda gunakan untuk bermain. Hal tersebut adalah jelajah internet yang masih menjadi bagian dari ponsel Anda. Dengan menggunakan jelajah internet ini, ada banyak permainan menarik yang dapat Anda temukan pula. Salah satunya adalah permainan yang telah menjadi incaran masyarakat luas sejak zaman dahulu.thola al badru alaina lirik arab dan artinya Bahkan, beberapa dari Anda juga mungkin akan memilih permainan ini.

Benar sekali, hal ini dikarenakan hadiah kemenangan yang diberikan oleh permainan yang ada dalam situs ini adalah uang. Tepat sekali, judi menjadi nama lain dari permainan yang saat ini dapat Anda mainkan dalam situs dengan nama urlib urlretrieve 53376 ini. Kami menyarankan semua dari Anda untuk langsung mengunjungi situs yang kami sebut sebelumnya saja saat ingin bermain. Hal ini dikarenakan situs yang kami sebutkan merupakan laman yang aman.

Hasil Thailand Open 2023: Pramudya/Yeremia Susul Fikri/Bagas ke 16 Besar Sudah Move On, Florentino Perez: Jangan Bahas Kylian Mbappe, Hari Ini Pestanya Real Madrid! | Goal.com Indonesia notaiwanhariini PREVIEW La Liga Spanyol: Getafe - Real Madrid | Goal.com Indonesia Kunjungan Ke Pabrik Sepatu Tomkins Gedebage Persija Jakarta Kumpulkan Pemain Pada 13 Januari | Goal.com Indonesia Spanyol Balaskan Dendam Atas Slowakia, Iker Casillas Puas | Goal.com Indonesia kuda2dtogel Sri Mulyani Beberkan Alasan Perpanjang Diskon Pajak Mobil Kedatangan Marc Klok Buat Evan Dimas Makin Percaya Diri | Goal.com Indonesia PREVIEW Piala AFC: Ambisi FC Istiklol Pastikan Kelolosan | Goal.com Indonesia urlib urlretrieve 53376 Mulai Hari Ini, Citilink & Lion Air Sudah Terbang Lagi HUT Koperasi Ke-64 Tingkat Kota Bandung Real Madrid Bidik Nabil Fekir | Goal.com Indonesia

Jelas saja, ada banyak keuntungan yang diberikan oleh laman ini dan tidak hanya berlaku untuk pemenang. Benar, hal ini dikarenakan keuntungan ini berlaku untuk semua dari Anda yang menjadi anggota dari situs ini. Lebih tepatnya, keuntungan ini dapat Anda peroleh dari banyaknya pelayanan terbaik yang biasanya tidak diberikan laman lain.master slot88 Mengetahui hal ini tentunya membuat Anda merasa penasaran dengan laman ini, bukan?

Pasien Sembuh Covid-19 di Depok Jadi 50.780 Orang VIDEO - Tawuran Pecah, TUJUH Kartu Merah Tercipta Di Superclasico Antara Boca Juniors & River Plate | Goal.com Indonesia roykiyoshihasananwar BERITA TIMNAS INDONESIA: Stefano Lilipaly Datang, Adam Alis Dipulangkan | Goal.com Indonesia Jokowi Marah 4 Bulan Tak Kelar, Ini Biang Kerok Awal Migor! Berita Chelsea - Gianfranco Zola Resmi Pulang Ke Chelsea | Goal.com Indonesia Paul Pogba Jawab Tantangan Tutup Botol Dari Zlatan Ibrahimovic | Goal.com Indonesia katakatangopilucu Berita Real Madrid - Luis Figo: Beri Waktu Untuk Zinedine Zidane | Goal.com Indonesia Disdik Depok Tetapkan Empat Isu Strategis di Forum Renja 2023 Casemiro & Pemain Brasil Dengan Biaya Transfer Terbesar Dalam Sejarah Liga Primer Inggris | Goal.com Indonesia urlib urlretrieve 53376 Shola Shoretire! Bocah Yang Bisa Bikin Manchester United Lupakan Jadon Sancho | Goal.com Indonesia Piala Dunia 2022: Ronaldo Disindir Bikin 'Gol Rambut Tuhan' Berita Inter Milan - Beppe Marotta: Antonio Conte Akan Bangun Skuat Kompetitif | Goal.com Indonesia

Secara Singkat Situs urlib urlretrieve 53376 Untuk Anda

Kami akan menjawab semua rasa penasaran Anda mengenai situs ini terlebih dahulu. Dengan melakukan hal ini, maka semua pertanyaan yang ada dalam benak Anda tentunya akan menghilang. Sebab, kami akan membuat Anda mengetahui laman ini secara lebih dalam lagi. Hal paling awal yang harus Anda ketahui mengenai laman ini adalah kemudahan yang diberikan kepada Anda sebagai anggota dari laman.

Persija Jakarta & Arema FC Kantongi Lisensi Klub Profesional AFC | Goal.com Indonesia Jokowi Panen Bendungan, RI Swasembada Beras 3 Tahun Berturut ultramanmodapk Edaran Terbit, Pejabat Dilarang Bukber & Open House Lebaran! Alasan Monchi Tolak Arsenal Demi Sevilla | Goal.com Indonesia Covid China Lagi Menggila, Aturan Ini Malah Dilonggarkan Resmi Bubar, Bye-Bye Merpati dan Kertas Leces bocoranlangithkhariini Paul Pogba Jawab Tantangan Tutup Botol Dari Zlatan Ibrahimovic | Goal.com Indonesia 1.931 Orang Kena Rabies di Kalbar, 11 Meninggal Dunia Berita Tottenham Hotspur - Marcelo Lippi Ungkap Alasan Tolak Tottenham Hotspur | Goal.com Indonesia urlib urlretrieve 53376 Berita Transfer - Bintang Muda Ajax Dillon Hoogewerf Konfirmasi Gabung Manchester United | Goal.com Indonesia Bobby Nasution Ngamuk Gara-gara Ormas Bikin Gaduh di Depan Masjid Starting XI Barito Putera Bisa Didominasi Pemain Usia Belasan Tahun | Goal.com Indonesia

Saat memutuskan untuk menggunakan situs ini, maka semua dari Anda akan menemukan nominal deposit yang wahai hingga permainan yang beragam. Hal ini jelas merupakan keuntungan untuk semua dari Anda. Akan tetapi, keuntungan ini juga masih menjadi bagian kecil dari situs yang ini.

Tentunya,cek go send tracking hal ini dapat terjadi karena ada lebih banyak keuntungan yang akan menjadi milik Anda. Beberapa keuntungan tersebut akan menjadi hal yang Anda temukan dalam kalimat selanjutnya. Maka karena itu, cari tahu bersama kami dengan tetap menyimak setiap kalimat yang ada dengan baik.

Wow! PPATK Sebut Ada Transaksi Mencurigakan Hingga Rp 1,6 T Berita Chelsea - Olivier Giroud Tambah Kontrak Di Stamford Bridge | Goal.com Indonesia Bhayangkara FC Senang Main Sore Lagi | Goal.com Indonesia GOAL50 2022 Pilihan Fans: Bagaimana Cara Kerjanya? | Goal.com Indonesia Puncak Arus Balik Terminal Kampung Rambutan Diprediksi Akhir Pekan Berita Sevilla v Cádiz, 23/01/21, LaLiga | Goal.com nomorpunggungyangbagus FIFA Pertimbangkan Gelar Piala Dunia Dua Tahun Sekali | Goal.com Indonesia Hasil Pertandingan: Southampton 1-1 Crystal Palace | Goal.com Indonesia Chelsea Buka Negosiasi, Shakhtar Ultimatum Arsenal: £88 Juta Untuk Transfer Mudryk! | Goal.com Indonesia urlib urlretrieve 53376 Kemnaker Sebut RUU PPRT Bisa Kurangi Kasus Perdagangan Orang Fabian Delph Absen, Pep Guardiola Makin Pusing | Goal.com Indonesia Chant Inggris: Lirik & Video Lagu Populer The Three Lions | Goal.com Indonesia

Keuntungan Situs Permainan Untuk Anda

Situs permainan urlib urlretrieve 53376 sendiri mampu memberikan beragam keuntungan untuk Anda. Tidak akan menjadi hal yang mudah untuk mendapatkan keuntungan dalam beragam agen lainnya. Namun, situs permainan ini mampu memberikan penawaran sempurna dalam permainan hanya dengan pembuatan akun permainan saja.salah lobow chord Pastinya, ada beberapa keuntungan berikut ini yang akan Anda dapatkan dalam dunia permainan tanpa perlu kesulitan sama sekali.

Stefano Lilipaly Pastikan Bertahan Di Cambuur | Goal.com Indonesia Breaking News: Gempa Goyang Sukabumi Jabar, Magnitudo 4,5 excelsosoloparagon SEA Games 2017: Vietnam Rebut Medali Emas Sepakbola Putri | Goal.com Indonesia Serie A Segera Dimulai, Alexis Sanchez & Miralem Pjanic Kembali Ke Italia | Goal.com Indonesia Goal Of The Day Piala Dunia 2018: Denis Cheryshev | Goal.com Indonesia Mardiono Usulkan Sandiaga Uno Jadi Ketua Badan Pemenangan Pemilu PPP rumahkentangfullmovie Hasil Piala AFF 2022: Thailand Cukur Filipina 4-0 Viral Video Mario Aniaya David, Wamenkeu: Tak Bisa Ditolerir! Geger Dunia Persilatan, Awas Perang Rusia vs AS & NATO urlib urlretrieve 53376 Teruntuk Bobotoh, Kalau Cinta Persib Bandung Jangan Ngotot Ke Stadion | Goal.com Indonesia Gempa Kuat Guncang Filipina, Warga Panik Berhamburan ke Jalan Baru Satu Musim Di Barcelona, Memphis Depay Sudah Mau Didepak | Goal.com Indonesia

Layanan aktif

Anda mendapatkan penawaran sempurna dalam permainan berupa layanan yang aktif. Anda dapat bermain tanpa masalah sama sekali dalam urusan waktu. Semua permainan yang ingin Anda mainkan dapat disesuaikan dengan kenyamanan untuk taruhan.hokiantea lokal Para pemain biasanya memikirkan waktu terbaik karena harus menyesuaikan dengan tempat permainan sendiri. Namun, situs ini mmberikan penawaran sempurna untuk permainan dengan akses 24 jam.

Berita Mancheter United - David De Gea: Fokus Saya Adalah Memenangkan Pertandingan | Goal.com Indonesia Fans Feyenoord Tumpah Ruah Rayakan Gelar Juara | Goal.com Indonesia totobet6d Timnas Indonesia U-16 Tak Pilih-Pilih Lawan Di Semi-Final | Goal.com Indonesia Tingkatkan IPM Tapos, Anggota DPRD Depok : Perlu Sinergi Unsur Pentahelix "Lampard Tahu Cara Juara" - Eks Kiper Manchester United Jagokan Chelsea Di Liga Inggris | Goal.com Indonesia Simak! Ini Aturan Baru Pelaksanaan MotoGP Mandalika rtpslotgacor77 Berita Transfer - RESMI: Arsenal Lepas Takuma Asano Ke Partizan Belgrade | Goal.com Indonesia Sultan Samma Berharap Semua Bisa Beradaptasi Dengan Kondisi Baru | Goal.com Indonesia Hasil Tes Covid-19 Jokowi Hingga Menteri tak akan Diumumkan urlib urlretrieve 53376 PPP dan PAN Kompak Wacanakan KIB Plus Demi Pilpres 2024 Konser Kanye West di Australia Terancam Batal, Ada Apa? Berita Watford FC v Arsenal FC, 06/03/22, Liga Primer | Goal.com

Permainan urlib urlretrieve 53376 terbaik

Tidak hanya penawaran untuk permainan selama 24 jam saja. Anda juga mendapatkan layanan lainnya dalam permainan. Hal ini berkaitan dengan banyaknya permainan yang dapat Anda akses tanpa perlu kesulitan sama sekali. Semua permainan mempunyai perbedaannya satu dengan yang lain. Anda dapat meraih kemenangan permainan dengan akses pada permainan yang tepat.result macau 4d hari ini Hal ini tidak akan menyulitkan Anda dalam permainan.

Kadek Agung Semringah Bantu Bali United Jaga Rekor | Goal.com Indonesia Elon Musk Tawari Bocah Ini Rp 71 M, Ditolak! togelbeijinghariini Berita Manchester United - Paul Pogba: Ole Gunnar Solskjaer Bawa Kebahagiaan & Kegembiraan | Goal.com Indonesia Makin Panas! Tetangga RI Beri Warning ke China, Ada Apa Lagi? PDIP Masih Godok Nama Pendamping Ganjar di Pilpres 2024 Pep Guardiola Terkesan Sekaligus Was-Was Dengan Ilkay Gundogan | Goal.com Indonesia keluarantogel45 Kemenperin 'Senggol' Rencana Impor Darurat KRL, Bilang Ini STY Pelan-pelan Benahi Fisik Timnas Indonesia Jelang Piala AFF 2022 Beri Pemahaman ASN Soal Penilaian Kinerja, BKPSDM Gelar Pelatihan urlib urlretrieve 53376 Jokowi Marah 4 Bulan Tak Kelar, Ini Biang Kerok Awal Migor! Panic Buying China Makin Meluas, Warga 'Serbu' Alibaba Fisik Pemain Timnas Indonesia U-22 Digenjot Dengan Latihan Khusus | Goal.com Indonesia

Tampilan permainan menarik

Anda pastinya ingin mendapatkan penampilan permainan yang sempurna untuk suasana yang jauh lebih menarik. Tidak akan jadi hal yang seru jika permainan hanya dapat Anda akses dengan warna biasa saja. Situs permainan ini memberikan beragam fitur menarik sehingga semua permainan jauh lebih menarik. Walaupun permainan dimainkan secara daring, Anda tetap mendapatkan keseruan dalam permainan sendiri.

Berita Serie A: AC Milan & Inter Milan Resmi Luncurkan Proposal Proyek Stadion Baru | Goal.com Indonesia Berita Madura United v Persipura, 03/10/21, Liga 1 | Goal.com bentukdanukuranlapangansepakbola Prediksi Liga 1 2019: Madura United vs Arema FC | Goal.com Indonesia Manajer Real Madrid Carlo Ancelotti Tak Rela Lihat Toni Kroos Pensiun Dalam Waktu Dekat | Goal.com Indonesia Antonio Rudiger, Andreas Christensen & Upaya Thomas Tuchel Menjaga Pertahanan Kokoh Chelsea | Goal.com Indonesia "Butuh Pengganti Segera" - Pelatih Rennes Konfirmasi Edouard Mendy Menuju Chelsea | Goal.com Indonesia lirikseventeensumpahkumencintaimu Keren! Petani Ini Ekspor Olahan Teh ke Korea Selatan Siapa Pantas Jadi Striker Skuad Garuda di Brunei vs Indonesia? Fix! Proyek Kereta Cepat Molor Operasi Sampai 2023 urlib urlretrieve 53376 Musim Pancaroba, Warga Kalimulya Diimbau Waspadai DBD Rafinha Akui Pernah Tolak Rayuan Carlo Ancelotti | Goal.com Indonesia Kadisrumkim Puas dengan Hasil Bangunan IPAL Komunal di Kelurahan Depok

Dasar Dalam Permainan Daring

Akun permainan

Anda harus mempunyai akun permainan dalam situs urlib urlretrieve 53376 lebih dulu. Hal ini berkaitan dengan permainan penghasil uang yang tepat. Hanya agen permainan aman saja yang dapat memberikan keuntungan untuk Anda. Penting sekali untuk membuat akun dalam agen permainan yang aman.

REVIEW La Liga Spanyol: Real Betis Bangkit Taklukkan Levante | Goal.com Indonesia Dear Mr Kishida, Jokowi Mau Proyek MRT & Blok Masela Dikebut ciricirisekop Alasan Iwan Budianto Minta Namanya Dihapus dari Daftar Cawaketum PSSI Belanja Orang Kaya di Mall Turun Hingga 30%, Khawatir Resesi? Berita Bundesliga - Mats Hummels Anggap Erling Haaland Belum Selevel Robert Lewandowski | Goal.com Indonesia Berita Qatar U19 v Thailand U19, 28/10/18, AFC U19 Championship | Goal.com bolalemparlembing WHO: Deltacron Sudah Menyerang Wilayah AS Dan Eropa Berita Persela v Bali United, , Piala Indonesia | Goal.com Negatif Covid-19, Cristiano Ronaldo Segera Kembali Beraksi Bersama Juventus | Goal.com Indonesia urlib urlretrieve 53376 Laporan Pertandingan: Manchester United 1-1 West Ham | Goal.com Indonesia Timnas Indonesia U-20 Disebut Bakal Lawan Jepang di Spanyol Sedih, Hong Hong Laporkan Korban Meninggal ke-2 Akibat Corona

Modal bermain

Anda perlu hal lainnya dalam permainan berupa modal. Penting sekali halnya untuk taruhan dengan biaya yang cukup.sebutkan macam macam teknik dasar dalam permainan bola basket Anda harus melakukan langkah yang tepat dalam permainan dengan biaya untuk taruhan sepenuhnya.

Berita Tottenham Hotspur FC v Chelsea FC, 19/09/21, Liga Primer | Goal.com Selebrasi Natal Bintang-Bintang Sepakbola Dunia | Goal.com Indonesia agensports Sadio Mane Kembali Berlatih Penuh | Goal.com Indonesia Di Pertamina SMEXPO, UMKM Dibekali Fotografi Produk Ingin Pensiun Di Real Madrid, Toni Kroos: Mungkin Tahun 2025 | Goal.com Indonesia Sudah Berkarier Di Liga Primer Inggris, Tapi Erling Haaland Masih Jadi Pawang Terbaik Bayern Munich | Goal.com Indonesia hariyangterindahketikakujumpa Gak Cuma Bensin, Januari-November 2022 Musim Tarif Tol Naik? Potret Tim INASAR Terjun ke Turki, Cari Korban Gempa M 7,8 Massimiliano Mirabelli: AC Milan Butuh Jawaban Dari Gianluigi Donnarumma | Goal.com Indonesia urlib urlretrieve 53376 Tolak Kasasi, MA Kuatkan Vonis 9 Bulan Penjara Roy Suryo Geger! Banyak Warga Rusia Bangkrut Berita Transfer - RESMI: Godin Gabung Inter Milan | Goal.com Indonesia

Mengenal dunia judi

Mustahil halnya Anda mendapatkan keuntungan dalam permainan tanpa adanya pemahaman akan permainan judi sendiri. Anda harus mengenal permainan ini lebih dulu untuk akses yang lebih mudah. Penting melakukan pemilihan pada permainan yang tepat. Anda tidak akan bermain dengan tepat tanpa mempunyai pengalaman dalam dunia permainan judi sendiri.

Pep Guardiola: Manchester City Tidak Akan Rekrut Pemain Baru Pada Januari | Goal.com Indonesia Jadi Manajer Bayern Munich Berikutnya, Thomas Tuchel Berusaha Ulangi Prestasi Luar Biasa Chelsea | Goal.com Indonesia modelrambuttipiswanitakekinian Menohok! Ini Alasan AS Hengkang dari Proyek Kesayangan Jokowi Berita Juventus - Wayne Rooney Jagokan Juventus Di Liga Champions | Goal.com Indonesia Mendikbud Dukung Grand Design Olahraga Nasional Hola España: Yang Tersisa Dari Kunjungan Ke Spanyol | Goal.com bonekawanitajepang Chelsea vs Valencia: Preview, Kabar Terkini Skuad, Prediksi & Jadwal TV | Goal.com Indonesia Bersama Real Madrid, Carlo Ancelotti Ingin Samai Kesuksean Diego Simeone Di Atletico Madrid | Goal.com Indonesia Kepala Ditabrak dan Ditendang, Spaso Curhat Bawa-bawa Nyawa urlib urlretrieve 53376 Berita Liverpool - Trent Alexander-Arnold Tak Terganggu Penilaian Tinggi Cafu Soal Ballon DOr | Goal.com Indonesia Eks Menkeu Jadi Chairman Samsung Hadapi Corona, Pemerintah: Setop Panic Buying

Beberapa hal ini penting dalam dunia permainan urlib urlretrieve 53376. Menangkan permainan tanpa perlu repot sama sekali. Anda dapat melakukan cara yang sederhana untuk mendapatkan keuntungan besar.angka semar Situs permainan yang tepat harus Anda gunakan untuk keuntungan yang besar dalam dunia permainan daring. Gunakan cara tepat untuk beragam keuntungan dalam dunia permainan.

STQH 2022 Siap Digelar, Tapos Jadi Tuan Rumah Video: Usai Terima Booster Kedua, Jokowi Kembali ke Cianjur lany13 Mantap! Kini Pengaduan Lapor dan PPID Ada di Mal Nih! Pesan Jokowi untuk Gubernur BI Soal Ekonomi Digital Cedera Lutut, Penyerang Liverpool Diogo Jota Absen Dua Bulan | Goal.com Indonesia RESMI: Chelsea Datangkan Enzo Fernandez Dengan Rekor Transfer £106,8 Juta | Goal.com Indonesia durian2d Menjaga Komitmen Konektivitas Pascapandemi Duh! Ternyata Masih Ada Karyawan yang Telat Dapat THR, Kamu? Thomas Tuchel Bikin Kesal Skuad Chelsea, Waktunya Libur Dipaksa Latihan | Goal.com Indonesia urlib urlretrieve 53376 Deal! Manchester United Sepakati Transfer Antony Dengan Harga Fantastis! | Goal.com Indonesia Kemenpora Harap Kejurkab PBSI Sumedang 2022 Jaring Atlet Bulutangkis Unggulan Prancis Chaos! Kondisi Mencekam, Jalanan bak 'Medan Perang'

urlib urlretrieve 53376 Situs Judi Poker Domino QQ Terpercaya

urlib urlretrieve 53376 Merupakan Bandar Judi Togel 4D Paling Besar Yang Menyediakan Hadiah 4D 10 Juta Rupiah Di Indonesia urlib urlretrieve 53376..

Permainan yang disediakan urlib urlretrieve 53376 adalah Bandarq, Poker Online, Bandar Poker, Bandar Sakong, Bandar66, Capsa Susun, Perang Baccarat, AduQ dan DominoQQ Online.

Momen Eks Mendag Lutfi Tiba di Kejagung, Saksi Korupsi Migor PREVIEW & PREDIKSI Asian Games 2018: Indonesia U-23 - Hong Kong U-23 | Goal.com Indonesia juarafacup2022 Gianluigi Buffon Dukung Keputusan Cristiano Ronaldo Tinggalkan Juventus | Goal.com Indonesia Hasil Pertandingan: Mainz 05 1-2 Borussia Dortmund | Goal.com Indonesia Reformasi Penerimaan Peserta Didik Baru (PPDB) 2014 Pemerintah Klaim Bansos BBM Rp24 T Tepat Sasaran lirikdopebts Kiamat PNS Nyata, Jabatan-jabatan 'Terlaris' Ini Akan Hilang Rio Ferdinand: Saya Hampir Tinggalkan Manchester United Untuk Barcelona | Goal.com Indonesia Tianjin Quanjian Bantah Ketertarikan Pada Carlo Ancelotti | Goal.com Indonesia urlib urlretrieve 53376 Harta Karun Hijau RI: Sarang Walet Sampai Vanili Sumringah! Para Taipan Batu Bara Ini Bisa Nikmati Royalti 0% Intensitas Latihan Timnas Indonesia U-16 Lebih Tinggi Dibanding Di PSS Sleman | Goal.com Indonesia

Keunggulan yang Dimiliki Situs urlib urlretrieve 53376

Situs urlib urlretrieve 53376 memiliki Keunggulan yang Tentunya Memuaskan Kamu Sebagai Pemain Judi Online.

- Server yang Always On, jarang maintenance.

- Berbagai link login alternatif

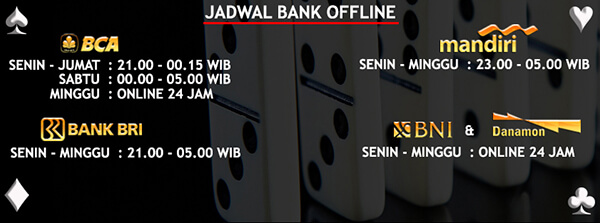

- Berbagai bank alternatif yang disediakan

- Bonus-bonus yang diberikan tentunya menarik

- Akun yang dijamin keamanannya

- Transaksi yang aman dan cepat

- Didukung oleh Customer Service yang ramah dan responsif

- Permainan yang disediakan Sangat Lengkap

Bonus Menarik Dari urlib urlretrieve 53376

Situs urlib urlretrieve 53376 memberikan bonus yang menarik untuk semua member yang bergabung. Bonus untuk member baru dan member lama adalah sama. Kamu juga bisa mendapatkan bonus Turnover jika ada bermain. Tentu kamu juga bisa mendapatkan bonus tanpa bermain,tabel hk 6d yaitu caranya dengan mengajak temanmu daftar dan bermain dengan kode referral kamu.

Patrice Evra: Lionel Messi Bisa Raih 15 Ballon DOr Andai Punya Etos Kerja Kayak Cristiano Ronaldo! | Goal.com Indonesia Salut! Astronot Wanita Pertama Arab Sukses Jalankan Misi karaokejakarta Pesan Cinta 3 Pemain Naturalisasi Timnas Indonesia ke Suporter Berita Serie A - Franck Ribery Jadi Pemain Terbaik Serie A Italia Bulan September | Goal.com Indonesia Jakub Jankto, Berita Terkini & Profil Pemain | Goal.com Alberto Goncalves: Klub Rugi Bayar Gaji Penuh Tapi Kami Tidak Kerja | Goal.com Indonesia totoshanghaipools Marinir Korsel Bergerak, Bersiap Hadapi Serangan Korut Rapor Tim Bundesliga Jerman 2017/18 | Goal.com Indonesia Diminati Manchester United, Andre Silva: Rumor Transfer Hanyalah Rumor | Goal.com Indonesia urlib urlretrieve 53376 Masih Cetak Gol, Hernan Crespo: Zlatan Ibrahimovic Pantas Jadi Obor! | Goal.com Indonesia Gianluigi Donnarumma Puncaki Daftar NxGn | Goal.com Indonesia Apakah THR & Gaji ke-13 PNS Dipotong Lagi Karena Masih Covid?

Untuk bonus turnover ini sebesar 0.5% dengan pembagian setiap minggunya. Selain itu, bonus referral sebesar 20% bisa kamu dapatkan seumur hidup. Sangat menarik bukan?

urlib urlretrieve 53376 Kompatibel di Semua Perangkat

Kabar baiknya, Kamu bisa memainkan semua game pilihan kamu di situs urlib urlretrieve 53376 ini dengan berbagai jenis perangkat seperti Android, iOS, Windows Mobile, Windows PC, Mac OS. Sehingga kamu bisa memaikan game ini dimanapun dan kapanpun saja.

Berita Liverpool - Loris Karius Resmi Berkostum Besiktas | Goal.com Indonesia Berita Barcelona v Valencia, 14/04/18, LaLiga | Goal.com situsbiru Enzo Fernandez Dilibas! Gol Solo-Run Penyerang Borussia Dortmund Karim Adeyemi Bikin Bintang Chelsea Pontang-Panting (+Video) | Goal.com Indonesia Hugo Lloris: Anthony Martial Punya Masa Depan Yang Cerah Untuk Prancis | Goal.com Indonesia DPR Bongkar Saham Vale di Publik Ternyata Milik Dapen Asing! Serangan Jantung Saat Ketemu Suporter PSS Sleman, Kondisi Marco Gracia Paulo Masih Lemah | Goal.com Indonesia gambaruangmainan Jadwal Siaran Langsung SEA Games 2023 Timnas Indonesia Vs Myanmar Jika Latih Manchester United, Ini Daftar Pemain Bidikan Zinedine Zidane | Goal.com Indonesia Penampakan Patung Kristus Penebus Usai Earth Hour urlib urlretrieve 53376 Duh! Keok Lawan MU, Liverpool Samai Catatan Memalukan 2012/13, Bagaimana Nasib The Reds Saat Itu? | Goal.com Indonesia Italia vs Armenia - Suka Cita Nicolo Zaniolo Cetak Gol Perdana Di Timnas | Goal.com Indonesia Manchester City Segera Tingkatkan Gaji Raheem Sterling | Goal.com Indonesia