Простое руководство по реверс-инжинирингу исходного кода Reddit с использованием LangChain, Activeloop и GPT-4

Руководство по реверс-инжинирингу исходного кода Reddit с использованием LangChain, Activeloop и GPT-4' (A simple guide to reverse engineering the source code of Reddit using LangChain, Activeloop, and GPT-4)

Представьте, что вы пишете программное обеспечение, которое может понимать, помогать и даже генерировать код, подобно опытному разработчику.

Ну вот, это возможно с помощью LangChain. Используя передовые модели, такие как VectorStores, Conversational RetrieverChain и LLM (Языковая модель), LangChain переносит нас на новый уровень понимания и генерации кода.

В этом руководстве мы будем проводить обратную разработку общедоступного исходного кода репозитория Reddit для версии 1 сайта, чтобы лучше понять кодовую базу и предоставить понимание ее внутреннего устройства. Я был вдохновлен создать это руководство после прочтения твита Пола Грэма на эту тему (и потому что я ничего не знаю о Lisp, но все же хотел понять, о чем он говорит).

Мы будем использовать технологию встраивания OpenAI и инструмент под названием Activeloop, чтобы сделать код понятным, а LLM (в данном случае GPT-4) – для общения с кодом. Если вас интересует использование другой LLM или другой платформы, ознакомьтесь с моим предыдущим руководством по обратной разработке алгоритма Twitter с использованием DeepInfra и Dolly.

- Необходимые плагины ChatGPT для создателей контента

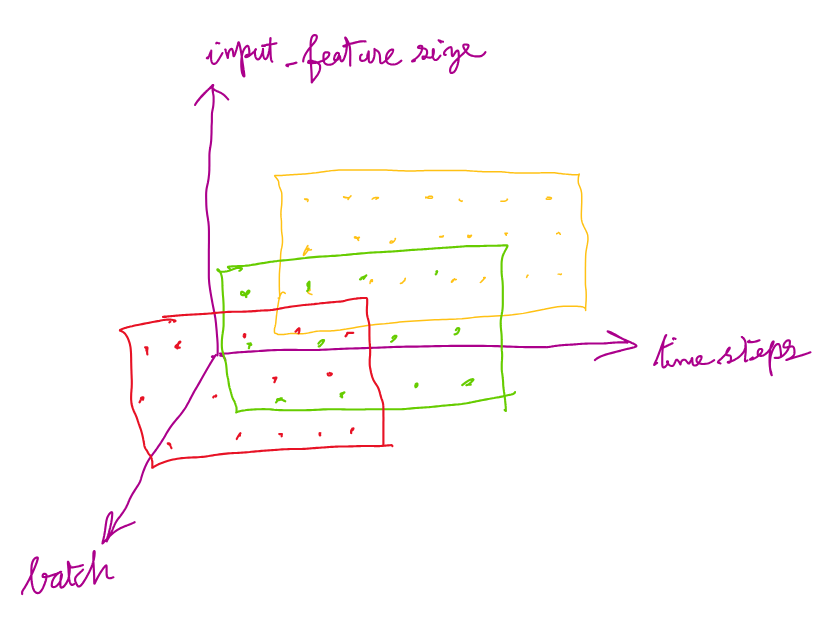

- PyTorch LSTMCell – Формы входного, скрытого состояния, состояния ячейки и выхода

- Анализ настроений, проведенный на твитах о землетрясении в Турции

Когда мы закончим, мы сможем сократить трудоемкую работу по пониманию алгоритма, задавая ИИ вопросы вместо того, чтобы тратить недели на его изучение. Начнем.

Концептуальное описание понимания кода с помощью LangChain

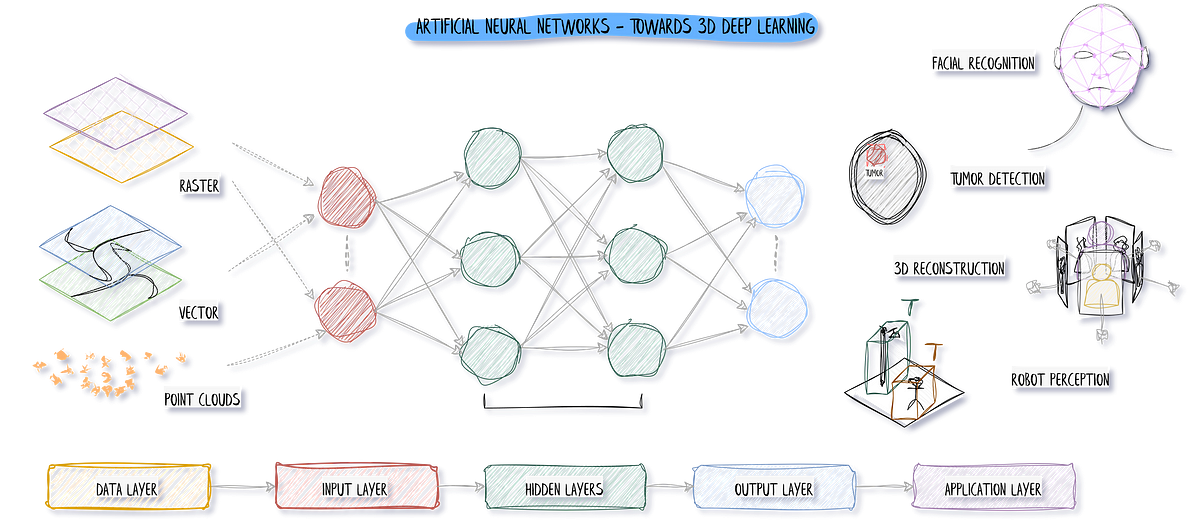

LangChain – это мощный инструмент для анализа репозиториев кода на GitHub. Он объединяет три важные части: VectorStores, Conversational RetrieverChain и LLM (Языковая модель), чтобы помочь вам понять код, отвечать на вопросы о нем в контексте и даже генерировать новый код в репозиториях GitHub.

Conversational RetrieverChain – это система, которая помогает находить и извлекать полезную информацию из VectorStore. Она использует умные техники, такие как контекстосознательная фильтрация и ранжирование, чтобы определить, какие фрагменты кода и информация наиболее релевантны для конкретного вопроса или запроса, который у вас есть. То, что отличает его, заключается в том, что он учитывает историю разговора и контекст, в котором задается вопрос. Это означает, что он может предоставить вам высококачественные и актуальные результаты, которые специально отвечают вашим потребностям. Проще говоря, это похоже на наличие умного помощника, который понимает контекст ваших вопросов и дает вам наилучшие возможные ответы на основе этого контекста.

Теперь давайте рассмотрим рабочий процесс LangChain и посмотрим, как он работает на высоком уровне:

- Индексирование кодовой базы: Первый шаг – клонировать целевой репозиторий, который вы хотите проанализировать. Загрузите все файлы внутри репозитория, разбейте их на более мелкие фрагменты и начните процесс индексации. Если у вас уже есть проиндексированный набор данных, вы можете пропустить этот шаг.

- Встраивание и хранение кода: Чтобы сделать фрагменты кода более понятными, LangChain использует модель встраивания, осознающую код. Эта модель помогает уловить суть кода и сохраняет встроенные фрагменты в VectorStore, делая их легко доступными для будущих запросов.

- Понимание запросов: Здесь вступает в игру ваш LLM. Вы можете использовать модель, например, GPT-4, для обработки ваших запросов. Модель используется для анализа ваших запросов и понимания их смысла, учитывая контекст и извлекая важную информацию. Таким образом, модель помогает LangChain точно интерпретировать ваши запросы и предоставлять вам точные и актуальные результаты.

- Создание поисковика: Как только ваш вопрос или запрос ясен, вступает в действие Conversational RetrieverChain. Он проходит через VectorStore, где хранятся фрагменты кода, и находит наиболее релевантные для вашего запроса фрагменты кода. Этот процесс поиска очень гибкий и может быть настроен под ваши требования. У вас есть возможность настроить параметры и применить фильтры, специфические для ваших потребностей, чтобы гарантировать, что вы получаете наиболее точные и полезные результаты для вашего запроса.

- Построение цепочки разговора: Как только вы настроили поисковик, пришло время построить цепочку разговора. Этот шаг включает настройку параметров поисковика, чтобы лучше соответствовать вашим потребностям, и применение любых дополнительных фильтров, которые могут потребоваться. Таким образом, вы можете сузить поиск и убедиться, что вы получаете наиболее точные, точные и актуальные результаты для ваших запросов. В основном, это позволяет настроить процесс извлечения наиболее полезной информации.

- Задавать вопросы: Теперь наступает захватывающая часть! Вы можете задавать вопросы о кодовой базе с использованием Conversational Retrieval Chain. Он сгенерирует для вас исчерпывающие и контекстно осознанные ответы. Ваш LLM, являясь частью цепочки разговора, учитывает извлеченные фрагменты кода и историю разговора, чтобы предоставить вам подробные и точные ответы.

Следуя этому рабочему процессу, вы сможете эффективно использовать LangChain для глубокого понимания кода, получения ответов, основанных на контексте на ваши вопросы, а также для генерации фрагментов кода в репозиториях GitHub. Теперь давайте посмотрим на это действие, шаг за шагом.

Пошаговое руководство

Давайте перейдем к фактической реализации.

1. Получение ключей

Для начала вам необходимо зарегистрироваться на соответствующих веб-сайтах и получить API-ключи для Activeloop и OpenAI.

2. Настройка файла indexer.py

Создайте файл на языке Python, например, indexer.py, где вы будете индексировать данные. Импортируйте необходимые модули и установите API-ключи в качестве переменных среды.

3. Клонирование и индексирование целевого репозитория

Затем мы клонируем репозиторий алгоритма Reddit, загружаем, разделяем и индексируем документы. Вы можете клонировать алгоритм по этой ссылке.

4. Встраивание фрагментов кода

Затем мы используем встраивание OpenAI для встраивания фрагментов кода. Эти встраивания затем сохраняются в VectorStore, что позволяет нам выполнять эффективный поиск похожих элементов.

5. Использование GPT-4 для обработки и понимания пользовательских запросов

Теперь мы настраиваем другой файл на языке Python, question.py, чтобы использовать GPT-4, языковую модель, доступную в OpenAI, для обработки и понимания пользовательских запросов.

6. Создание получателя

Мы создаем получателя, используя ранее созданный VectorStore.

7. Построение цепочки диалогового взаимодействия

Цепочка диалогового взаимодействия связывает получателя и языковую модель. Это позволяет нашей системе обрабатывать запросы пользователей и генерировать ответы, основанные на контексте.

8. Задавание вопросов

Теперь мы можем задавать вопросы о исходном коде Reddit. Ответы, предоставляемые цепочкой диалогового взаимодействия, учитывают контекст и основаны непосредственно на кодовой базе.

Вот некоторые из полученных ответов:

Что вы будете спрашивать? Что вы узнаете? Дайте мне знать!

Ограничения

После разговора с Шрирамом Кришнамурти на Twitter я понял, что следует отметить, что у этого подхода есть некоторые ограничения для понимания кода.

- Анализ этого кода может быть неполным, и иногда вы можете упустить ключевые детали из-за ошибок в этом анализе, которые могут привести вас в неправильное направление.

- Могут быть некоторые “искажения” результатов, которые могут возникнуть, когда ваш LLM обладает знаниями своих обучающих данных с перекрывающимися терминами. Например, концепция “Reddit Karma” уже, вероятно, хранится в базе знаний GPT-4, поэтому, задавая вопрос о том, как работает Karma, он может извлечь контекст из своих обучающих данных, а не из предоставленного кода.

Вам следует обладать хорошим суждением и применять подход “доверяй, но проверяй” в этом начальном грубом подходе. Или, возможно, вы можете продвинуться дальше и создать более совершенную систему!

Заключение

В этом руководстве мы исследовали обратную разработку общедоступного репозитория исходного кода Reddit версии 1 с использованием LangChain. С помощью возможностей искусственного интеллекта мы экономим время и усилия, заменяя ручной анализ кода автоматическими ответами на запросы.

LangChain – это мощный инструмент, который революционизирует понимание и генерацию кода. С помощью продвинутых моделей, таких как VectorStore, Conversational RetrieverChain и LLM, LangChain позволяет разработчикам эффективно анализировать репозитории кода, предоставлять ответы, основанные на контексте, и генерировать новый код.

Рабочий процесс LangChain включает индексацию кодовой базы, встраивание фрагментов кода, обработку пользовательских запросов с помощью языковых моделей и использование цепочки диалогового взаимодействия для получения соответствующих фрагментов кода. Настраивая получателя и создавая цепочку диалогового взаимодействия, разработчики могут настроить процесс получения результатов для точной работы.

Следуя пошаговому руководству, вы можете использовать LangChain для улучшения понимания вашего кода, получения ответов, основанных на контексте, и даже генерации фрагментов кода в репозиториях GitHub. LangChain открывает новые возможности для повышения продуктивности и понимания. Что вы собираетесь создать с его помощью? Спасибо за чтение!