Шесть шагов к безопасности искусственного интеллекта

6 шагов к безопасности ИИ

Вслед за ChatGPT каждая компания пытается разработать свою стратегию искусственного интеллекта, что немедленно вызывает вопрос: что насчет безопасности?

Некоторые могут чувствовать себя перегруженными при мысли о защите новых технологий. Хорошая новость в том, что существующие политики и практики обеспечивают отличные отправные точки.

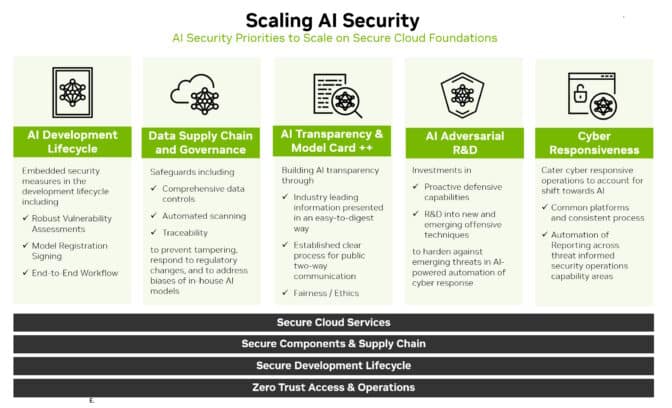

Действительно, путь вперед заключается в расширении существующих основ предприятий и облачной безопасности. Это путешествие можно суммировать в шести шагах:

- Расширение анализа угроз

- Расширение механизмов реагирования

- Обеспечение безопасности цепочки поставки данных

- Использование искусственного интеллекта для масштабирования усилий

- Быть прозрачным

- Создание непрерывных улучшений

Изучение расширенного горизонта

Первый шаг – ознакомиться с новым ландшафтом.

- Синтез программ – позволяет коду писать самостоятельно

- Бум искусственного интеллекта Практическое руководство по генеративному искусственному интеллекту для малого бизнеса

- Построение сверточной нейронной сети с использованием PyTorch

Теперь безопасность должна охватывать жизненный цикл разработки искусственного интеллекта. Это включает новые площадки атак, такие как данные для обучения, модели и люди, а также процессы их использования.

Экстраполируйте известные виды угроз, чтобы выявить и предвидеть возникающие. Например, злоумышленник может попытаться изменить поведение модели искусственного интеллекта, получив доступ к данным во время ее обучения в облачном сервисе.

Исследователи по безопасности и команды для тестирования на проникновение, которые ранее искали уязвимости, снова станут отличными ресурсами. Они будут нуждаться в доступе к системам искусственного интеллекта и данным, чтобы выявлять и реагировать на новые угрозы, а также помогать налаживать крепкие взаимоотношения с сотрудниками по науке о данных.

Расширение защиты

После того, как картина угроз станет ясной, определите способы защиты от них.

Тщательно контролируйте производительность модели искусственного интеллекта. Предполагайте, что она будет изменяться, открывая новые площадки для атак, так же как и традиционные средства защиты безопасности могут быть нарушены.

Также опирайтесь на практики PSIRT (команды реагирования на инциденты безопасности продукта), которые уже должны быть введены в действие.

Например, NVIDIA опубликовала политику безопасности продукта, охватывающую свой портфель искусственного интеллекта. Несколько организаций, включая Open Worldwide Application Security Project, выпустили реализации ключевых элементов безопасности, специально адаптированных для искусственного интеллекта, таких как метод общего учета уязвимостей, используемый для выявления традиционных угроз информационным технологиям.

Адаптируйте и применяйте к искусственному интеллекту и рабочим процессам традиционные защитные меры, такие как:

- Сохранение разделения сетевого контроля и плоскостей данных

- Удаление любых небезопасных или лично идентифицирующих данных

- Использование безопасности нулевого доверия и аутентификации

- Определение соответствующих журналов событий, предупреждений и тестов

- Установка контроля потока данных по мере необходимости

Расширение существующих мер безопасности

Защитите наборы данных, используемые для обучения моделей искусственного интеллекта. Они ценны и уязвимы.

Еще раз, предприятия могут использовать существующие практики. Создайте защищенные цепочки поставки данных, подобные тем, которые создаются для обеспечения безопасности каналов для программного обеспечения. Важно установить контроль доступа для данных обучения, так же как это делается для других внутренних данных.

Некоторые пробелы могут потребовать заполнения. Сегодня специалисты по безопасности знают, как использовать хэш-файлы приложений для обеспечения отсутствия изменений в их коде. Процесс масштабирования этой практики для наборов данных размером в петабайты, используемых для обучения искусственного интеллекта, может быть вызовом.

Хорошая новость в том, что исследователи понимают необходимость и уже работают над инструментами, чтобы справиться с этим.

Масштабирование безопасности с помощью искусственного интеллекта

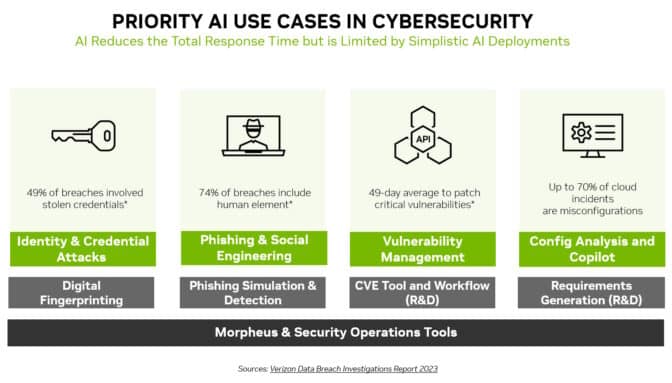

Искусственный интеллект – это не только новая область атаки, которую нужно защищать, но и новый и мощный инструмент безопасности.

Модели машинного обучения могут обнаруживать тонкие изменения, которые человек не заметит среди огромного объема сетевого трафика. Это делает искусственный интеллект идеальной технологией для предотвращения многих наиболее широко используемых атак, таких как кража личности, фишинг, вредоносные программы и вымогательство.

NVIDIA Morpheus, кибербезопасность framework, может создавать приложения искусственного интеллекта, которые создают, читают и обновляют цифровые отпечатки, сканирующие множество видов угроз. Кроме того, генеративный искусственный интеллект и Morpheus могут обеспечить новые способы обнаружения попыток спирального фишинга.

Безопасность любит ясность

Прозрачность является важной составляющей любой стратегии безопасности. Сообщите клиентам о любых новых политиках и практиках безопасности искусственного интеллекта, которые были введены в действие.

Например, NVIDIA публикует подробности о моделях искусственного интеллекта в NGC, своем центре для ускоренного программного обеспечения. Называемые карточками моделей, они действуют как заявления о правде в кредитовании, описывая искусственный интеллект, данные, на которых он был обучен, и любые ограничения его использования.

NVIDIA использует расширенный набор полей в своих модельных картках, чтобы пользователи четко понимали историю и ограничения нейронной сети перед ее внедрением в производство. Это помогает повысить безопасность, установить доверие и обеспечить надежность моделей.

Определяйте пути, а не пункты назначения

Эти шесть шагов – всего лишь начало пути. Процессы и политики, подобные этим, должны развиваться.

Например, практика конфиденциальных вычислений расширяет безопасность в области облачных сервисов, где часто проводятся обучение и запуск AI-моделей в производство.

Отрасль уже начинает видеть базовые версии сканеров кода для AI-моделей. Они являются предвестниками того, что нас ожидает. Командам необходимо следить за горизонтом и внедрять передовые практики и инструменты по мере их появления.

По пути сообщество должно делиться тем, что изучило. Отличным примером этого стал недавний вызов Генеративной Команды Красной.

В конце концов, речь идет о создании коллективной защиты. Мы все совершаем этот путь к безопасности ИИ вместе, по одному шагу за раз.