Атакующие автокодировщики совмещение автокодировщиков и генеративно-состязательных сетей

Атакующие автокодировщики

Введение

В динамичной области машинного обучения синтез двух мощных техник породил универсальную модель, известную как Адверсариальные автоэнкодеры (AAE). Безупречно сочетая в себе возможности автоэнкодеров и генеративно-состязательных сетей (GAN), AAE стали мощным инструментом для генерации данных, обучения представления и т. д. В данной статье рассматриваются суть AAE, их архитектура, процесс обучения и применение, а также предоставляется пример кода на Python для более глубокого понимания.

Эта статья была опубликована в рамках блогонауки по Data Science.

Понимание автоэнкодеров

Автоэнкодеры, являющиеся основой AAE, представляют собой структуры нейронных сетей, предназначенные для сжатия данных, снижения размерности и извлечения признаков. Архитектура включает в себя кодировщик, который отображает входные данные в пространство латентного представления, а затем декодер, который восстанавливает исходные данные из этого сжатого представления. Автоэнкодеры являются важными инструментами в различных областях, включая подавление шума изображений, обнаружение аномалий и визуализацию латентного пространства.

- Кому нужны фото редакторы?! – Масштабный учебник по манипуляции изображениями на Python

- Как сделать односторонний дисперсионный анализ вручную

- Walmart дает возможность своим офисным сотрудникам использовать приложение с генеративным искусственным интеллектом

Автоэнкодеры, являющиеся основным классом нейронных сетей, могут извлекать значимые признаки из данных, обеспечивая эффективное снижение размерности. Состоящие из двух основных компонентов, кодировщик сжимает входные данные в более низкоразмерное латентное представление, а декодер восстанавливает исходный ввод из этой сжатой формы. Автоэнкодеры имеют различные цели, включая подавление шума, обнаружение аномалий и обучение представлению. Их способность захватывать существенные характеристики данных делает их универсальным инструментом для задач в различных областях, таких как обработка изображений, обработка естественного языка и других. Изучая компактные, но информативные представления, автоэнкодеры предоставляют ценные идеи о внутренних структурах сложных наборов данных.

Введение в адверсариальные автоэнкодеры

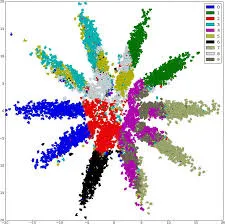

Адверсариальные автоэнкодеры (AAE) – это удивительное сочетание автоэнкодеров и генеративно-состязательных сетей (GAN), инновационно объединяющих их преимущества. Эта гибридная модель представляет собой архитектуру кодировщик-декодировщик, где кодировщик отображает входные данные в латентное пространство, и декодер восстанавливает их. Отличительной особенностью AAE является интеграция адверсариального обучения, где дискриминатор оценивает качество сгенерированных образцов данных. Такое адверсариальное взаимодействие между генератором и дискриминатором улучшает латентное пространство и способствует генерации данных высокого качества.

AAE находят различные применения в синтезе данных, обнаружении аномалий и обучении без учителя, обеспечивая надежные латентные представления. Их универсальность предлагает перспективные возможности в различных областях, таких как синтез изображений, генерация текста и т. д. AAE привлекают внимание своим потенциалом для улучшения генеративных моделей и вклада в развитие искусственного интеллекта.

Адверсариальные автоэнкодеры, результат интеграции GAN с автоэнкодерами, добавляют новую размерность в генеративное моделирование. Сочетая исследование латентного пространства автоэнкодеров с механизмом адверсариального обучения GAN, AAE балансируют преимущества обоих миров. Это сотрудничество приводит к улучшению генерации данных и более значимым представлениям в латентном пространстве.

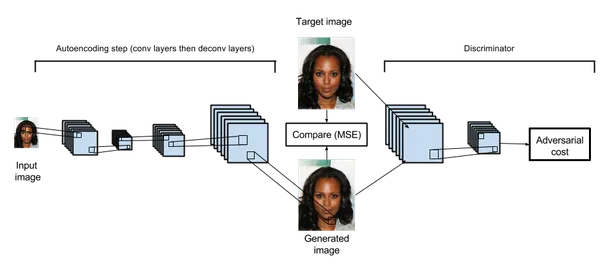

Архитектура AAE

Архитектурный план AAE вращается вокруг трех ключевых компонентов: кодировщика, генератора и дискриминатора. Кодировщик сжимает входные данные в сжатое представление в латентном пространстве, а генератор восстанавливает исходные данные из этих сжатых представлений. Дискриминатор вводит адверсариальный аспект, стремясь различать между реальными и сгенерированными образцами данных.

Обучение AAE

Обучение AAE является итеративным взаимодействием трех игроков: кодировщика, генератора и дискриминатора. Кодировщик и генератор сотрудничают, чтобы минимизировать ошибку реконструкции, обеспечивая соответствие генерируемых данных исходному вводу. Параллельно дискриминатор совершенствует свои навыки в различении между реальными и сгенерированными данными. Это адверсариальное взаимодействие приводит к улучшению латентного пространства и качества генерации данных.

Применение AAE

Универсальность AAE проявляется в широком спектре приложений. AAE блестяще справляются с задачами генерации данных, способными производить реалистичные образцы в областях, таких как изображения, текст и т. д. Их способность обнаружения аномалий находит применение в выявлении необычностей в наборах данных. Кроме того, AAE прекрасно справляются с обучением представлений без учителя, помогая извлекать признаки и обучаться передаче знаний.

Обнаружение аномалий и удаление шума из данных: Регуляризация латентного пространства AAE позволяет фильтровать шум и аномалии в данных, делая их надежным выбором для задач удаления шума и обнаружения аномалий.

Перенос стиля и преобразование данных: Путем манипулирования векторами латентного пространства AAE позволяет осуществлять перенос стиля между входными данными, плавно изменяя изображения и генерируя разнообразные версии одного и того же контента.

Полу-надзорное обучение: AAE могут использовать размеченные и неразмеченные данные для улучшения задач надзорного обучения, сокращая разрыв между надзорными и ненадзорными подходами.

Реализация адверсарного автоэнкодера

Для практического понимания AAE давайте рассмотрим реализацию на Python с использованием TensorFlow. В этом примере мы сосредоточимся на удалении шума из данных и покажем, как AAE могут отлично восстанавливать чистые данные из шумных входных данных.

(Примечание: Убедитесь, что у вас установлен TensorFlow и необходимые зависимости перед запуском кода ниже.)

import tensorflow as tf

from tensorflow.keras.layers import Input, Dense, Flatten, Reshape

from tensorflow.keras.models import Model

from tensorflow.keras.optimizers import Adam

from tensorflow.keras.losses import MeanSquaredError

from tensorflow.keras.datasets import mnist

import numpy as np

# Определение архитектуры адверсарного автоэнкодера

def build_adversarial_autoencoder(input_dim, latent_dim):

input_layer = Input(shape=(input_dim,))

# Энкодер

encoder = Dense(128, activation='relu')(input_layer)

encoder = Dense(latent_dim, activation='relu')(encoder)

# Декодер

decoder = Dense(128, activation='relu')(encoder)

decoder = Dense(input_dim, activation='sigmoid')(decoder)

# Построение и компиляция автоэнкодера

autoencoder = Model(input_layer, decoder)

autoencoder.compile(optimizer=Adam(), loss=MeanSquaredError())

# Построение и компиляция адверсара

adversary = Model(input_layer, encoded)

adversary.compile(optimizer=Adam(), loss='binary_crossentropy')

return autoencoder, adversary

# Загрузка и предобработка набора данных MNIST

(input_train, _), (input_test, _) = mnist.load_data()

input_train = input_train.astype('float32') / 255.0

input_test = input_test.astype('float32') / 255.0

input_train = input_train.reshape((len(input_train), np.prod(input_train.shape[1:])))

input_test = input_test.reshape((len(input_test), np.prod(input_test.shape[1:])))

# Определение параметров AAE

input_dim = 784

latent_dim = 32

# Построение и компиляция AAE

autoencoder, adversary = build_adversarial_autoencoder(input_dim, latent_dim)

# Обучение AAE

autoencoder.fit(input_train, input_train,

epochs=50,

batch_size=256,

shuffle=True,

validation_data=(input_test, input_test))

# Генерация очищенных изображений

denoised_images = autoencoder.predict(input_test)Настройка гиперпараметров

Настройка гиперпараметров является важным аспектом обучения любой модели машинного обучения, включая адверсарные автоэнкодеры (AAE). Гиперпараметры – это настройки, определяющие поведение модели во время обучения. Правильная настройка этих гиперпараметров может значительно повлиять на скорость сходимости, стабильность и качество сгенерированных образцов. Некоторые важные гиперпараметры включают скорость обучения, количество эпох обучения, размер пакета, размерность латентного пространства, сила регуляризации и т. д. Для простоты мы будем настраивать два гиперпараметра: количество эпох обучения и размер пакета.

# Настройка гиперпараметров

epochs = 50

batch_size = 256

# Обучение AAE

autoencoder.fit(input_train, input_train,

epochs=epochs,

batch_size=batch_size,

shuffle=True,

validation_data=(input_test, input_test))

# Генерация очищенных изображений

denoised_images = autoencoder.predict(input_test)Метрики оценки

Оценка качества сгенерированных данных с помощью AAE является важным аспектом, чтобы убедиться, что модель производит осмысленные результаты. Вот несколько распространенных метрик оценки:

- Потеря восстановления: Это показывает, насколько хорошо сгенерированные образцы могут быть восстановлены обратно в исходные данные. Более низкая потеря восстановления указывает на более высокое качество сгенерированных образцов.

- Оценка Inception Score: Оценка Inception Score измеряет качество и разнообразие сгенерированных изображений. Она использует вспомогательный классификатор, обученный на реальных данных, для оценки сгенерированных образцов. Более высокий Inception Score указывает на более высокое разнообразие и качество.

- Расстояние Фреше в пространстве признаков Inception (FID): FID вычисляет расстояние между распределениями признаков реальных и сгенерированных данных в пространстве признаков модели Inception. Более низкие значения FID указывают на то, что сгенерированные образцы ближе к реальным данным в отношении статистики.

- Точность и полнота сгенерированных данных: Метрики из области информационного поиска также могут быть применены к сгенерированным данным. Точность измеряет долю образцов высокого качества, а полнота измеряет долю качественных реальных образцов, успешно сгенерированных.

- Визуальный осмотр: Хотя это не количественная метрика, визуальный осмотр сгенерированных образцов может дать представление о их качестве и разнообразии.

# Метрики оценки

def compute_inception_score(images, inception_model, num_splits=10):

scores = []

splits = np.array_split(images, num_splits)

for split in splits:

split_scores = []

for img in split:

img = img.reshape((1, 28, 28, 1))

img = np.repeat(img, 3, axis=-1)

img = preprocess_input(img)

pred = inception_model.predict(img)

split_scores.append(pred)

split_scores = np.vstack(split_scores)

p_y = np.mean(split_scores, axis=0)

kl_scores = split_scores * (np.log(split_scores) - np.log(p_y))

kl_divergence = np.mean(np.sum(kl_scores, axis=1))

inception_score = np.exp(kl_divergence)

scores.append(inception_score)

return np.mean(scores), np.std(scores)Заключение

По мере того как Генеративное искусственный интеллект продолжает завораживать исследователей и практиков, Адверсариальные автоэнкодеры выступают в качестве отдельных и универсальных членов семьи генеративных моделей. Объединяя способности автоэнкодеров восстановления и адверсариальных динамик ГАН, ААЭ позволяют балансировать процесс генерации данных и регуляризацию латентного пространства. Их способность к удалению шума, трансформации стилей и использованию помеченных и непомеченных данных делает их неотъемлемым инструментом в арсенале творческого искусственного интеллекта. По мере завершения этого путешествия Адверсариальные автоэнкодеры приглашают нас раскрыть новые измерения генеративного искусственного интеллекта и проложить путь к синтезу данных, который гармонично сочетает контроль и инновации.

- Адверсариальные автоэнкодеры (ААЭ) объединяют автоэнкодеры и адверсариальные сети для восстановления данных и регуляризации латентного пространства.

- ААЭ находят применение в обнаружении аномалий, удалении шума из данных, переносе стилей и полу-наблюдаемом обучении.

- Адверсариальный компонент в ААЭ включает критическую сеть, которая обеспечивает соблюдение распределения латентного пространства, достигая баланс между творчеством и контролем.

- Реализация ААЭ требует сочетания концепций глубокого обучения, адверсариального обучения и архитектуры автоэнкодера.

- Исследование ландшафта Адверсариальных автоэнкодеров предоставляет уникальную перспективу на генеративный искусственный интеллект, открывая двери к новым парадигмам преобразования данных и регуляризации.

Часто задаваемые вопросы

Медиа, показанные в этой статье, не являются собственностью Analytics Vidhya и используются по усмотрению автора.