%D0%B8%D1%81%D1%81%D0%BB%D0%B5%D0%B4%D0%BE%D0%B2%D0%B0%D0%BD%D0%B8%D0%B5 %D0%B1%D0%BE%D0%BB%D1%8C%D1%88%D0%B8%D1%85 %D1%8F%D0%B7%D1%8B%D0%BA%D0%BE%D0%B2%D1%8B%D1%85 %D0%BC%D0%BE%D0%B4%D0%B5%D0%BB 2 >> Bandar Agen Togel Online Terpercaya Sogotogel Rtp rupython

Yuk, Intip Lebih Dalam Situs %D0%B8%D1%81%D1%81%D0%BB%D0%B5%D0%B4%D0%BE%D0%B2%D0%B0%D0%BD%D0%B8%D0%B5 %D0%B1%D0%BE%D0%BB%D1%8C%D1%88%D0%B8%D1%85 %D1%8F%D0%B7%D1%8B%D0%BA%D0%BE%D0%B2%D1%8B%D1%85 %D0%BC%D0%BE%D0%B4%D0%B5%D0%BB 2 Yang Berkualitas

North West Doesn't Approve of Mom Kim Kardashian's Jam Session in Car Betty Has a New Female Love Interest in Riverdale Sneak Peek livedrawfloridamid The MixtapE! Presents Taylor Swift, Sam Hunt and More New Music Musts How Josie Totah Became Her True Self and an LGBTQ+ Icon Kelly Rizzo Reflects on Braving World 6 Months After Bob Saget's Death Chrissy Teigen Responds to "Brutal" Critics About Life-Saving Abortion downloadalbumjikustik Meet the Castaways of Survivor’s Most “Extreme” Season Yet Oprah Winfrey's Father Vernon Winfrey Dead at Age 89 Meet the Soccer Stars Representing Team USA at the 2022 World Cup %D0%B8%D1%81%D1%81%D0%BB%D0%B5%D0%B4%D0%BE%D0%B2%D0%B0%D0%BD%D0%B8%D0%B5 %D0%B1%D0%BE%D0%BB%D1%8C%D1%88%D0%B8%D1%85 %D1%8F%D0%B7%D1%8B%D0%BA%D0%BE%D0%B2%D1%8B%D1%85 %D0%BC%D0%BE%D0%B4%D0%B5%D0%BB 2 Country Singer Luke Bell Dead at 32 After Going Missing Florence Pugh Recalls Execs Trying to Change Her Look Early in Career RHOC's Alexis Bellino Introduces Transgender Son Miles

Yuk, Intip Lebih Dalam Situs %D0%B8%D1%81%D1%81%D0%BB%D0%B5%D0%B4%D0%BE%D0%B2%D0%B0%D0%BD%D0%B8%D0%B5 %D0%B1%D0%BE%D0%BB%D1%8C%D1%88%D0%B8%D1%85 %D1%8F%D0%B7%D1%8B%D0%BA%D0%BE%D0%B2%D1%8B%D1%85 %D0%BC%D0%BE%D0%B4%D0%B5%D0%BB 2 Yang Berkualitas! Bermain tentunya menjadi salah satu kegiatan dari sedikitnya kegiatan menyenangkan yang dapat Anda lakukan. Jelas saja,%D0%B8%D1%81%D1%81%D0%BB%D0%B5%D0%B4%D0%BE%D0%B2%D0%B0%D0%BD%D0%B8%D0%B5 %D0%B1%D0%BE%D0%BB%D1%8C%D1%88%D0%B8%D1%85 %D1%8F%D0%B7%D1%8B%D0%BA%D0%BE%D0%B2%D1%8B%D1%85 %D0%BC%D0%BE%D0%B4%D0%B5%D0%BB 2 berbeda dengan bekerja, saat bermain semua beban yang ada dalam benak Anda akan menghilang. Maka karena itu, menjadi hal yang sangat wajar bila saat ini semua dari Anda dapat menemukan aplikasi permainan di ponsel dengan mudah.

Tim Allen Says Jay Leno Looks "Handsome" & "Happy" After Hospital Visit Elizabeth Debicki Portrays Princess Diana With Sons in The Crown popsundamp3 Best 4th of July Sales: J.Crew Deals, Kate Spade Bags & More This Cooling Body Pillow With 15,200+ 5-Star Amazon Reviews is on Sale Andrew Garfield Says Late Mom Will Meet His Future Kids "in Spirit" Jenna Ortega Recalls Performing Autopsies on Dead Animals strongonedirectionlirik How Vampire Diaries Caused a Breakup for Nina Dobrev Under Holiday Decorating Products Amazon Shoppers Swear By 10 Trench Coats to Rock the Winter Trend Under 0 %D0%B8%D1%81%D1%81%D0%BB%D0%B5%D0%B4%D0%BE%D0%B2%D0%B0%D0%BD%D0%B8%D0%B5 %D0%B1%D0%BE%D0%BB%D1%8C%D1%88%D0%B8%D1%85 %D1%8F%D0%B7%D1%8B%D0%BA%D0%BE%D0%B2%D1%8B%D1%85 %D0%BC%D0%BE%D0%B4%D0%B5%D0%BB 2 Sephora 4th of July Deals: 50% Off Pat McGrath, Fenty Beauty & More Adidas Cuts Ties With Kanye West After His Antisemitic Comments Euphoria's Costume Designer Shares the Secrets to Show's Looks

Akan tetapi, selain menggunakan aplikasi, ada hal lain yang dapat Anda gunakan untuk bermain. Hal tersebut adalah jelajah internet yang masih menjadi bagian dari ponsel Anda. Dengan menggunakan jelajah internet ini, ada banyak permainan menarik yang dapat Anda temukan pula. Salah satunya adalah permainan yang telah menjadi incaran masyarakat luas sejak zaman dahulu.gudang boep Bahkan, beberapa dari Anda juga mungkin akan memilih permainan ini.

Benar sekali, hal ini dikarenakan hadiah kemenangan yang diberikan oleh permainan yang ada dalam situs ini adalah uang. Tepat sekali, judi menjadi nama lain dari permainan yang saat ini dapat Anda mainkan dalam situs dengan nama %D0%B8%D1%81%D1%81%D0%BB%D0%B5%D0%B4%D0%BE%D0%B2%D0%B0%D0%BD%D0%B8%D0%B5 %D0%B1%D0%BE%D0%BB%D1%8C%D1%88%D0%B8%D1%85 %D1%8F%D0%B7%D1%8B%D0%BA%D0%BE%D0%B2%D1%8B%D1%85 %D0%BC%D0%BE%D0%B4%D0%B5%D0%BB 2 ini. Kami menyarankan semua dari Anda untuk langsung mengunjungi situs yang kami sebut sebelumnya saja saat ingin bermain. Hal ini dikarenakan situs yang kami sebutkan merupakan laman yang aman.

Walking Dead's Norman Reedus Feared For His Life After Injury Amber Portwood "Devastated & Heartbroken" After Losing Custody of Son malambantuakulirik These Vanderpump Rules Stars Will Be at Scheana Shay's Wedding Steve Harvey on Daughter Lori's Split From Michael B. Jordan See Amal and George Clooney Step Out for Stylish Date Night in NYC Jenna Johnson Gives Update on Val Chmerkovskiy's DWTS Future downloadfilmsusterkeramas1 Shangela Shares Her Motivation To Win DWTS Ahead of Season 31 Premiere Transplant Preview: Bash Reignites Old Feelings for Ex-Fiancée Britney Spears' Ex-Husband Jason Alexander CRASHES Her Wedding %D0%B8%D1%81%D1%81%D0%BB%D0%B5%D0%B4%D0%BE%D0%B2%D0%B0%D0%BD%D0%B8%D0%B5 %D0%B1%D0%BE%D0%BB%D1%8C%D1%88%D0%B8%D1%85 %D1%8F%D0%B7%D1%8B%D0%BA%D0%BE%D0%B2%D1%8B%D1%85 %D0%BC%D0%BE%D0%B4%D0%B5%D0%BB 2 Jason Sudeikis’ Ex Keeley Hazell Posts Same Excerpt as Olivia Wilde Kim Kardashian & Kendall Jenner's Costumes TURN UP the Halloween Heat Britney Spears and Madonna Recreate Iconic VMAs Kiss at Wedding

Jelas saja, ada banyak keuntungan yang diberikan oleh laman ini dan tidak hanya berlaku untuk pemenang. Benar, hal ini dikarenakan keuntungan ini berlaku untuk semua dari Anda yang menjadi anggota dari situs ini. Lebih tepatnya, keuntungan ini dapat Anda peroleh dari banyaknya pelayanan terbaik yang biasanya tidak diberikan laman lain.samurai 188 Mengetahui hal ini tentunya membuat Anda merasa penasaran dengan laman ini, bukan?

Ncuti Gatwa's Fate on Sex Education Season 4 Revealed Jamie Lee Curtis Teases Her Surprise RHOBH Reunion Cameo melodi99 Alyssa Milano Gives an Update on the Who's the Boss Revival Destination Dressing: Italian Vacation-Inspired Styles Melissa Villaseñor Shares the Reason She Decided to Leave SNL Here's How You Can Stay in Sarah Jessica Parker's Home in the Hamptons salamjitu Zoe Kazan and Paul Dano Quietly Welcome Baby No. 2 Joshua Bassett & HSMTMTS Cast Spill Season 4 SECRETS Amazon Prime Day 2022: The Best Deals on TikTok-Famous Products %D0%B8%D1%81%D1%81%D0%BB%D0%B5%D0%B4%D0%BE%D0%B2%D0%B0%D0%BD%D0%B8%D0%B5 %D0%B1%D0%BE%D0%BB%D1%8C%D1%88%D0%B8%D1%85 %D1%8F%D0%B7%D1%8B%D0%BA%D0%BE%D0%B2%D1%8B%D1%85 %D0%BC%D0%BE%D0%B4%D0%B5%D0%BB 2 Shakira and Gerard Piqué Break Up After 11 Years Together Alicia Silverstone & Stacey Dash Have a TikTok Clueless Reunion Olivia Wilde Shuts Down Rumored Feud With Co-Star Florence Pugh

Secara Singkat Situs %D0%B8%D1%81%D1%81%D0%BB%D0%B5%D0%B4%D0%BE%D0%B2%D0%B0%D0%BD%D0%B8%D0%B5 %D0%B1%D0%BE%D0%BB%D1%8C%D1%88%D0%B8%D1%85 %D1%8F%D0%B7%D1%8B%D0%BA%D0%BE%D0%B2%D1%8B%D1%85 %D0%BC%D0%BE%D0%B4%D0%B5%D0%BB 2 Untuk Anda

Kami akan menjawab semua rasa penasaran Anda mengenai situs ini terlebih dahulu. Dengan melakukan hal ini, maka semua pertanyaan yang ada dalam benak Anda tentunya akan menghilang. Sebab, kami akan membuat Anda mengetahui laman ini secara lebih dalam lagi. Hal paling awal yang harus Anda ketahui mengenai laman ini adalah kemudahan yang diberikan kepada Anda sebagai anggota dari laman.

Amandla Stenberg Forgives Jack Quaid for "Hunger Games" Death Tristan Thompson Spotted Holding Hands With Mystery Woman justincompanymp3 Kim Kardashian to Pay .26M Settlement For SEC Charges Halloween 2022: Get In the Spooky Spirit With These Teen Thrillers Melinda Gates Details "Unbelievably Painful" Divorce From Bill Gates Hailey and Justin Bieber's Looks Will Make You Yearn for Fall downloadlaguniwenwoainiteresateng Ewan McGregor & Hayden Christensen on Most Fun Star Wars Scene Everything to Know About the Murder Case Against Kaitlin Armstrong Proof Welcome to Chippendales Is The Next Big True Crime Drama %D0%B8%D1%81%D1%81%D0%BB%D0%B5%D0%B4%D0%BE%D0%B2%D0%B0%D0%BD%D0%B8%D0%B5 %D0%B1%D0%BE%D0%BB%D1%8C%D1%88%D0%B8%D1%85 %D1%8F%D0%B7%D1%8B%D0%BA%D0%BE%D0%B2%D1%8B%D1%85 %D0%BC%D0%BE%D0%B4%D0%B5%D0%BB 2 You'll Find Comfort in Colton Haynes' Advice for LGBTQIA+ Community Jersey Shore's Mike and Lauren Reveal Sex of Their Baby Cardi B Slams Madonna Over Emoji in Sex Book Anniversary Post

Saat memutuskan untuk menggunakan situs ini, maka semua dari Anda akan menemukan nominal deposit yang wahai hingga permainan yang beragam. Hal ini jelas merupakan keuntungan untuk semua dari Anda. Akan tetapi, keuntungan ini juga masih menjadi bagian kecil dari situs yang ini.

Tentunya,erek 35 hal ini dapat terjadi karena ada lebih banyak keuntungan yang akan menjadi milik Anda. Beberapa keuntungan tersebut akan menjadi hal yang Anda temukan dalam kalimat selanjutnya. Maka karena itu, cari tahu bersama kami dengan tetap menyimak setiap kalimat yang ada dengan baik.

Grey's Anatomy Casts Sex Lives of College Girls Star Sharna Burgess Shares First Photo of Baby Zane's Face Fergie Returns to the 2022 MTV VMAs Stage in Surprise Performance Get This 0 Coach Bag for Just Johnny Depp Files Opposition to Amber Heard's Request for a Mistrial Kylie Jenner Brushes Off Breast Milk Leaking Onto Shirt on TikTok royal4dslot Why Jennifer Coolidge Calls Elle Woods' Bend and Snap "Misleading" See Andy Cohen's Epic Response to Taylor Armstrong Joining RHOC Why Sam Jaeger Is Skeptical a Parenthood Reboot Could Work %D0%B8%D1%81%D1%81%D0%BB%D0%B5%D0%B4%D0%BE%D0%B2%D0%B0%D0%BD%D0%B8%D0%B5 %D0%B1%D0%BE%D0%BB%D1%8C%D1%88%D0%B8%D1%85 %D1%8F%D0%B7%D1%8B%D0%BA%D0%BE%D0%B2%D1%8B%D1%85 %D0%BC%D0%BE%D0%B4%D0%B5%D0%BB 2 First Look At The 5 New Grey's Anatomy Cast Members Bachelor Nation's Becca Kufrin & Thomas Jacobs Buy a House Together Hear the Full Version of Taylor Swift's "Haunting" Song "Carolina"

Keuntungan Situs Permainan Untuk Anda

Situs permainan %D0%B8%D1%81%D1%81%D0%BB%D0%B5%D0%B4%D0%BE%D0%B2%D0%B0%D0%BD%D0%B8%D0%B5 %D0%B1%D0%BE%D0%BB%D1%8C%D1%88%D0%B8%D1%85 %D1%8F%D0%B7%D1%8B%D0%BA%D0%BE%D0%B2%D1%8B%D1%85 %D0%BC%D0%BE%D0%B4%D0%B5%D0%BB 2 sendiri mampu memberikan beragam keuntungan untuk Anda. Tidak akan menjadi hal yang mudah untuk mendapatkan keuntungan dalam beragam agen lainnya. Namun, situs permainan ini mampu memberikan penawaran sempurna dalam permainan hanya dengan pembuatan akun permainan saja.novel battle through the heaven Pastinya, ada beberapa keuntungan berikut ini yang akan Anda dapatkan dalam dunia permainan tanpa perlu kesulitan sama sekali.

All the Details on Britney Spears' "Timeless" Dress and Wedding Rings Will Dylan McDermott Return to American Horror Story? He Says… kincir86 Meghan Markle Says Focus on Her Race Shifted After Dating Prince Harry Anne Heche in Stable Condition After Fiery Car Crash in Los Angeles Brad Pitt Credits Gwyneth Paltrow for This Personal Milestone Late Show Staffers Arrested at the Capitol Won't Face Charges downloadandra-lovecansaveitall Check Out All Your Favorite Stars Taking Over Comic-Con 2022 Toast in Style With Champagne Flutes From Love Island Prince William & Kate Middleton Reunite With Prince Harry & Meghan Markle %D0%B8%D1%81%D1%81%D0%BB%D0%B5%D0%B4%D0%BE%D0%B2%D0%B0%D0%BD%D0%B8%D0%B5 %D0%B1%D0%BE%D0%BB%D1%8C%D1%88%D0%B8%D1%85 %D1%8F%D0%B7%D1%8B%D0%BA%D0%BE%D0%B2%D1%8B%D1%85 %D0%BC%D0%BE%D0%B4%D0%B5%D0%BB 2 RHOP's Karen Huger SHUTS DOWN Cheating Rumors Meghan Markle Twinned With Kate Middleton During NYC Outing Heiress Eliza Fletcher Confirmed Dead After Kidnapping

Layanan aktif

Anda mendapatkan penawaran sempurna dalam permainan berupa layanan yang aktif. Anda dapat bermain tanpa masalah sama sekali dalam urusan waktu. Semua permainan yang ingin Anda mainkan dapat disesuaikan dengan kenyamanan untuk taruhan.download narnia 2 sub indo Para pemain biasanya memikirkan waktu terbaik karena harus menyesuaikan dengan tempat permainan sendiri. Namun, situs ini mmberikan penawaran sempurna untuk permainan dengan akses 24 jam.

Below Deck's Gary King Responds to Ashley Marti Concerns Kelly Ripa "Embarrassing" Her Son at College Will Make You LOL lirikontheground Take a Peek at Ashton Kutcher's First Sit-Down Interview With His Twin Dove Cameron, Saucy Santana & More to Perform at 2022 MTV VMA Pre-Show Sophia Grace Brownlee Responds to Lip Filler Speculation RHOBH's Sutton Stracke & Diana Jenkins Face Off in Tense Teaser sgpkeraton Sean Bean Criticized After Intimacy Coordinator Comments Get 5 Worth of Anti-Aging Skincare for : SkinMedica and More Miss Argentina & Miss Puerto Rico MARRY After "Private" Romance %D0%B8%D1%81%D1%81%D0%BB%D0%B5%D0%B4%D0%BE%D0%B2%D0%B0%D0%BD%D0%B8%D0%B5 %D0%B1%D0%BE%D0%BB%D1%8C%D1%88%D0%B8%D1%85 %D1%8F%D0%B7%D1%8B%D0%BA%D0%BE%D0%B2%D1%8B%D1%85 %D0%BC%D0%BE%D0%B4%D0%B5%D0%BB 2 Trevor Noah's Daily Show Exit: Roy Wood Jr. REACTS Keke Palmer's Boyfriend Pays Tribute to Her After Pregnancy Reveal Yasmeen Fletcher Recalls Being In TEARS After Getting "Mrs. Marvel"

Permainan %D0%B8%D1%81%D1%81%D0%BB%D0%B5%D0%B4%D0%BE%D0%B2%D0%B0%D0%BD%D0%B8%D0%B5 %D0%B1%D0%BE%D0%BB%D1%8C%D1%88%D0%B8%D1%85 %D1%8F%D0%B7%D1%8B%D0%BA%D0%BE%D0%B2%D1%8B%D1%85 %D0%BC%D0%BE%D0%B4%D0%B5%D0%BB 2 terbaik

Tidak hanya penawaran untuk permainan selama 24 jam saja. Anda juga mendapatkan layanan lainnya dalam permainan. Hal ini berkaitan dengan banyaknya permainan yang dapat Anda akses tanpa perlu kesulitan sama sekali. Semua permainan mempunyai perbedaannya satu dengan yang lain. Anda dapat meraih kemenangan permainan dengan akses pada permainan yang tepat.hk 15 april 2023 Hal ini tidak akan menyulitkan Anda dalam permainan.

Norman Reedus Reveals How He Proposed to Diane Kruger Shop These Nordstrom Anniversary Sale Restocks Before They Sell Out sumseltotodaftar Harry Styles and Olivia Wilde Enjoy Date Night at Wolf Alice Concert Madewell Early Black Friday Sale: Trendy Winter Looks for as Low as Shia LaBeouf Addresses His "Failings" With FKA twigs Ellen Pompeo Promises Fans She'll Return to Grey's Anatomy masukpremiumpbgarena Hugh Jackman Mourns Death of Beloved Dog Dali High School Musical: The Musical: The Series Adds 2 Major Stars Jason David Frank's Power Rangers Co-Stars Mourn Actor's Death %D0%B8%D1%81%D1%81%D0%BB%D0%B5%D0%B4%D0%BE%D0%B2%D0%B0%D0%BD%D0%B8%D0%B5 %D0%B1%D0%BE%D0%BB%D1%8C%D1%88%D0%B8%D1%85 %D1%8F%D0%B7%D1%8B%D0%BA%D0%BE%D0%B2%D1%8B%D1%85 %D0%BC%D0%BE%D0%B4%D0%B5%D0%BB 2 Dead to Me Season 3 Trailer: Jen and Judy Are On the Run Candace Cameron Bure’s Kid Praises Mom After JoJo Siwa Calls Her Rude Why Jimmy Fallon Is Teaching His Daughters to Speak Spanish

Tampilan permainan menarik

Anda pastinya ingin mendapatkan penampilan permainan yang sempurna untuk suasana yang jauh lebih menarik. Tidak akan jadi hal yang seru jika permainan hanya dapat Anda akses dengan warna biasa saja. Situs permainan ini memberikan beragam fitur menarik sehingga semua permainan jauh lebih menarik. Walaupun permainan dimainkan secara daring, Anda tetap mendapatkan keseruan dalam permainan sendiri.

You Can't Refuse These Style Secrets for The Offer Jason Momoa Calls Out One of His Films for Being a "Big Pile of S--t" downloadavastinternetsecurity2015fullversion Cara Delevingne, Ariana DeBose, Cynthia Erivo Share Coming Out Stories Every Time Zendaya Has Broken the Fashion Internet Kurt Russell Moved to Tears by Kate Hudson's Father's Day Tribute Euphoria’s Hunter Schafer Has Odds In Her Favor With New Role kodealamkelelawar4d Gigi Hadid "Grateful" for Leonardo DiCaprio Amid "Easy" Romance Batgirl Directors "Shocked" After Warner Bros. Shelves Movie How Netflix's The Midnight Club Differs From the Book %D0%B8%D1%81%D1%81%D0%BB%D0%B5%D0%B4%D0%BE%D0%B2%D0%B0%D0%BD%D0%B8%D0%B5 %D0%B1%D0%BE%D0%BB%D1%8C%D1%88%D0%B8%D1%85 %D1%8F%D0%B7%D1%8B%D0%BA%D0%BE%D0%B2%D1%8B%D1%85 %D0%BC%D0%BE%D0%B4%D0%B5%D0%BB 2 Kelsea Ballerini Signals She and Halsey Don't "Talk Anymore" In Song Why Margot Robbie Is Being Tight-Lipped About Barbie Movie Why We're Thankful for Jeffrey and Ina Garten's Delicious Love Story

Dasar Dalam Permainan Daring

Akun permainan

Anda harus mempunyai akun permainan dalam situs %D0%B8%D1%81%D1%81%D0%BB%D0%B5%D0%B4%D0%BE%D0%B2%D0%B0%D0%BD%D0%B8%D0%B5 %D0%B1%D0%BE%D0%BB%D1%8C%D1%88%D0%B8%D1%85 %D1%8F%D0%B7%D1%8B%D0%BA%D0%BE%D0%B2%D1%8B%D1%85 %D0%BC%D0%BE%D0%B4%D0%B5%D0%BB 2 lebih dulu. Hal ini berkaitan dengan permainan penghasil uang yang tepat. Hanya agen permainan aman saja yang dapat memberikan keuntungan untuk Anda. Penting sekali untuk membuat akun dalam agen permainan yang aman.

Britney Spears' Ex Jason Alexander Charged With Trespassing, Vandalism Tarek El Moussa and Pregnant Heather Rae Mark 1st Wedding Anniversary downloadmuammarzamp3gratis Watch Anna Kendrick Escape After Getting Stuck in an Elevator at TIFF Kristin Cavallari Was "Proud" to Post Bikini Pic Despite Mom-Shamers Yara Shahidi Reveals How She Prepared to Play Tinker Bell Inside Gisele Bundchen's Post-Divorce Trip to Costa Rica jamberapasekarangdifilipina George Floyd's Family to Sue Kanye West for 0 Million The Bachelorette Reveals a Major Shift on Jaw-Dropping Episode See Brendan Fraser's Transformation in Trailer for The Whale %D0%B8%D1%81%D1%81%D0%BB%D0%B5%D0%B4%D0%BE%D0%B2%D0%B0%D0%BD%D0%B8%D0%B5 %D0%B1%D0%BE%D0%BB%D1%8C%D1%88%D0%B8%D1%85 %D1%8F%D0%B7%D1%8B%D0%BA%D0%BE%D0%B2%D1%8B%D1%85 %D0%BC%D0%BE%D0%B4%D0%B5%D0%BB 2 An Unexpected Killer Will Keep True Crime Fans on Their Toes Sarah Hyland Reveals the "Wildest" Part of Her Bachelorette Party Pete Davidson Makes His Debut on The Kardashians at Long Last

Modal bermain

Anda perlu hal lainnya dalam permainan berupa modal. Penting sekali halnya untuk taruhan dengan biaya yang cukup.bioskop4d Anda harus melakukan langkah yang tepat dalam permainan dengan biaya untuk taruhan sepenuhnya.

Paris Hilton Says Her Eggs Are "All Ready" for 2023 Pregnancy Your Favorite Love Is Blind Season 2 Couples Are Back beo4d Does Kristin Cavallari Want More Kids? She Says… Steve Martin & Martin Short's Emmys Rivalry Will Make You Laugh 50+ Thoughtful Holiday Gift Ideas for Every Type of Dad Starting at Below Deck Med’s Natasha Tells All on Her Talk With Capt. Sandy videosingaterbesardidunia Relive the Risky Fashion Moments That Defined the MTV VMAs The 12 Best Lip Care Products to Get Hydrated Lips All Winter Long Prince Harry's "Unflinching" Memoir Has a Release Date and Title %D0%B8%D1%81%D1%81%D0%BB%D0%B5%D0%B4%D0%BE%D0%B2%D0%B0%D0%BD%D0%B8%D0%B5 %D0%B1%D0%BE%D0%BB%D1%8C%D1%88%D0%B8%D1%85 %D1%8F%D0%B7%D1%8B%D0%BA%D0%BE%D0%B2%D1%8B%D1%85 %D0%BC%D0%BE%D0%B4%D0%B5%D0%BB 2 Jo Koy Says There's Still Love Between Him, Chelsea Handler Post-Split Queen Elizabeth II Celebrated Across the World as Mourners Pay Tribute Emma Watson & Tom Felton Address ROMANCE Rumors

Mengenal dunia judi

Mustahil halnya Anda mendapatkan keuntungan dalam permainan tanpa adanya pemahaman akan permainan judi sendiri. Anda harus mengenal permainan ini lebih dulu untuk akses yang lebih mudah. Penting melakukan pemilihan pada permainan yang tepat. Anda tidak akan bermain dengan tepat tanpa mempunyai pengalaman dalam dunia permainan judi sendiri.

JoJo Siwa Sounds Off on Candace Cameron Bure's Marriage Comment Hilaria Baldwin Admits She Used to Judge Couples With Big Age Gaps apaitufriendlydalambahasagaul Scarlett Johansson Shares the Story Behind Naming Her Son Cosmo Tori Spelling & Dean McDermott Step Out in Rare Outing in Los Angeles H&M Jaw-Dropping Discounts: Get Clothes and Home Decor Starting at See Kylie Jenner’s Sweet Response to When She Feels Most Confident jadwallaligaspanyol Ryan Reynolds Hilariously Reacts to Nick Cannon's Baby No. 11 News Why Drew Barrymore Hasn’t Had an “Intimate Relationship” Since 2016 Will Smith & Jada Pinkett Smith Make First Appearance Post Oscars Slap %D0%B8%D1%81%D1%81%D0%BB%D0%B5%D0%B4%D0%BE%D0%B2%D0%B0%D0%BD%D0%B8%D0%B5 %D0%B1%D0%BE%D0%BB%D1%8C%D1%88%D0%B8%D1%85 %D1%8F%D0%B7%D1%8B%D0%BA%D0%BE%D0%B2%D1%8B%D1%85 %D0%BC%D0%BE%D0%B4%D0%B5%D0%BB 2 Chloë Bailey Reveals Her Relationship Dealbreakers Prime Day Deal: Score This Top-Rated Hair Finishing Stick Billy Ray Cyrus Confirms Engagement to Firerose

Beberapa hal ini penting dalam dunia permainan %D0%B8%D1%81%D1%81%D0%BB%D0%B5%D0%B4%D0%BE%D0%B2%D0%B0%D0%BD%D0%B8%D0%B5 %D0%B1%D0%BE%D0%BB%D1%8C%D1%88%D0%B8%D1%85 %D1%8F%D0%B7%D1%8B%D0%BA%D0%BE%D0%B2%D1%8B%D1%85 %D0%BC%D0%BE%D0%B4%D0%B5%D0%BB 2. Menangkan permainan tanpa perlu repot sama sekali. Anda dapat melakukan cara yang sederhana untuk mendapatkan keuntungan besar.resident evil 4 dolphin emulator Situs permainan yang tepat harus Anda gunakan untuk keuntungan yang besar dalam dunia permainan daring. Gunakan cara tepat untuk beragam keuntungan dalam dunia permainan.

Deepti Vempati Reveals Her Thoughts on Kyle Abrams’ New Girlfriend This Hair Mask Totally Transformed My Curls rtpslothariinicnn Judge Greg Mathis' Most Epic Courtroom Moments Love Island USA Alum Spills Behind-the-Scenes Secrets Succession Teases Season 4 Premiere Date in New Teaser 50 Cent Reunites With Lala Kent & Calls Out Her Ex Randall Emmett doraemonmovie2015subindo Why Gwyneth Paltrow Says She Doesn't Miss Acting "At All" Madison LeCroy Sounds Off on Austen Kroll's Reaction to Her Engagement Harry Potter Stars Pay Tribute to Robbie Coltrane %D0%B8%D1%81%D1%81%D0%BB%D0%B5%D0%B4%D0%BE%D0%B2%D0%B0%D0%BD%D0%B8%D0%B5 %D0%B1%D0%BE%D0%BB%D1%8C%D1%88%D0%B8%D1%85 %D1%8F%D0%B7%D1%8B%D0%BA%D0%BE%D0%B2%D1%8B%D1%85 %D0%BC%D0%BE%D0%B4%D0%B5%D0%BB 2 Holiday Gifts for Grandparents: Binoculars, Google Chromecast & More See Trevante Rhodes' Incredible Transformation Into Mike Tyson Duff Goldman’s Holiday Gift Picks Are Fun for the Whole Family

%D0%B8%D1%81%D1%81%D0%BB%D0%B5%D0%B4%D0%BE%D0%B2%D0%B0%D0%BD%D0%B8%D0%B5 %D0%B1%D0%BE%D0%BB%D1%8C%D1%88%D0%B8%D1%85 %D1%8F%D0%B7%D1%8B%D0%BA%D0%BE%D0%B2%D1%8B%D1%85 %D0%BC%D0%BE%D0%B4%D0%B5%D0%BB 2 Situs Judi Poker Domino QQ Terpercaya

%D0%B8%D1%81%D1%81%D0%BB%D0%B5%D0%B4%D0%BE%D0%B2%D0%B0%D0%BD%D0%B8%D0%B5 %D0%B1%D0%BE%D0%BB%D1%8C%D1%88%D0%B8%D1%85 %D1%8F%D0%B7%D1%8B%D0%BA%D0%BE%D0%B2%D1%8B%D1%85 %D0%BC%D0%BE%D0%B4%D0%B5%D0%BB 2 adalah situs judi slot online terbaik no 1 di indonesia yang menghadirkan beragam permainan %D0%B8%D1%81%D1%81%D0%BB%D0%B5%D0%B4%D0%BE%D0%B2%D0%B0%D0%BD%D0%B8%D0%B5 %D0%B1%D0%BE%D0%BB%D1%8C%D1%88%D0%B8%D1%85 %D1%8F%D0%B7%D1%8B%D0%BA%D0%BE%D0%B2%D1%8B%D1%85 %D0%BC%D0%BE%D0%B4%D0%B5%D0%BB 2 gacor terlengkap dengan bonus new member 100%..

Permainan yang disediakan %D0%B8%D1%81%D1%81%D0%BB%D0%B5%D0%B4%D0%BE%D0%B2%D0%B0%D0%BD%D0%B8%D0%B5 %D0%B1%D0%BE%D0%BB%D1%8C%D1%88%D0%B8%D1%85 %D1%8F%D0%B7%D1%8B%D0%BA%D0%BE%D0%B2%D1%8B%D1%85 %D0%BC%D0%BE%D0%B4%D0%B5%D0%BB 2 adalah Bandarq, Poker Online, Bandar Poker, Bandar Sakong, Bandar66, Capsa Susun, Perang Baccarat, AduQ dan DominoQQ Online.

20 Popular Nordstrom Anniversary Deals to Shop Before the Sale Ends Love Island U.K. Host Announces She's Exiting the Series topgaming77 12 Things We're Shopping From Nicole Richie's Etsy Holiday Gift Guide Kylie Jenner & Stormi REACT to Viral TikTok Sound Ashley Judd Shares Wish for Mom Naomi 3 Months After Her Death TV Scoop Awards 2022: Vote For Your TV Favorites Now angkacicak2d How Manifest Was Saved by Netflix for a 4th and Final Season Jessica Biel & Son Silas Attend Justin Timberlake’s Golf Tournament Kendall Jenner's Beau Devin Booker Drops Flirty Emoji on Pic %D0%B8%D1%81%D1%81%D0%BB%D0%B5%D0%B4%D0%BE%D0%B2%D0%B0%D0%BD%D0%B8%D0%B5 %D0%B1%D0%BE%D0%BB%D1%8C%D1%88%D0%B8%D1%85 %D1%8F%D0%B7%D1%8B%D0%BA%D0%BE%D0%B2%D1%8B%D1%85 %D0%BC%D0%BE%D0%B4%D0%B5%D0%BB 2 Grey's Anatomy's Interns Will Breathe "New Life" Into Show Emily Ratajkowski Subtly Reacts to Divorce From Sebastian Bear-McClard North West & Friends Dress Up as TLC for Halloween

Keunggulan yang Dimiliki Situs %D0%B8%D1%81%D1%81%D0%BB%D0%B5%D0%B4%D0%BE%D0%B2%D0%B0%D0%BD%D0%B8%D0%B5 %D0%B1%D0%BE%D0%BB%D1%8C%D1%88%D0%B8%D1%85 %D1%8F%D0%B7%D1%8B%D0%BA%D0%BE%D0%B2%D1%8B%D1%85 %D0%BC%D0%BE%D0%B4%D0%B5%D0%BB 2

Situs %D0%B8%D1%81%D1%81%D0%BB%D0%B5%D0%B4%D0%BE%D0%B2%D0%B0%D0%BD%D0%B8%D0%B5 %D0%B1%D0%BE%D0%BB%D1%8C%D1%88%D0%B8%D1%85 %D1%8F%D0%B7%D1%8B%D0%BA%D0%BE%D0%B2%D1%8B%D1%85 %D0%BC%D0%BE%D0%B4%D0%B5%D0%BB 2 memiliki Keunggulan yang Tentunya Memuaskan Kamu Sebagai Pemain Judi Online.

- Server yang Always On, jarang maintenance.

- Berbagai link login alternatif

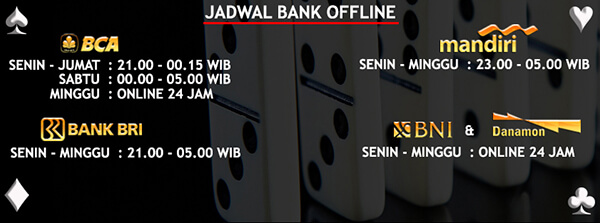

- Berbagai bank alternatif yang disediakan

- Bonus-bonus yang diberikan tentunya menarik

- Akun yang dijamin keamanannya

- Transaksi yang aman dan cepat

- Didukung oleh Customer Service yang ramah dan responsif

- Permainan yang disediakan Sangat Lengkap

Bonus Menarik Dari %D0%B8%D1%81%D1%81%D0%BB%D0%B5%D0%B4%D0%BE%D0%B2%D0%B0%D0%BD%D0%B8%D0%B5 %D0%B1%D0%BE%D0%BB%D1%8C%D1%88%D0%B8%D1%85 %D1%8F%D0%B7%D1%8B%D0%BA%D0%BE%D0%B2%D1%8B%D1%85 %D0%BC%D0%BE%D0%B4%D0%B5%D0%BB 2

Situs %D0%B8%D1%81%D1%81%D0%BB%D0%B5%D0%B4%D0%BE%D0%B2%D0%B0%D0%BD%D0%B8%D0%B5 %D0%B1%D0%BE%D0%BB%D1%8C%D1%88%D0%B8%D1%85 %D1%8F%D0%B7%D1%8B%D0%BA%D0%BE%D0%B2%D1%8B%D1%85 %D0%BC%D0%BE%D0%B4%D0%B5%D0%BB 2 memberikan bonus yang menarik untuk semua member yang bergabung. Bonus untuk member baru dan member lama adalah sama. Kamu juga bisa mendapatkan bonus Turnover jika ada bermain. Tentu kamu juga bisa mendapatkan bonus tanpa bermain,link alternatif sumobola yaitu caranya dengan mengajak temanmu daftar dan bermain dengan kode referral kamu.

Interview With the Vampire Star Teases Season 2 Details Shop The 5 Surprising Must-Haves The Rockettes Can't Live Without rtpgas138 You'll Find Comfort in Colton Haynes' Advice for LGBTQIA+ Community Todd Chrisley and Wife Julie Break Silence After Fraud Conviction Team USA Swimmer Rescued By Coach After Fainting in Pool The MixtapE! Presents Becky G, Charlie Puth and More New Music Musts flexi88k Peter Thomas Roth Deal: Get 2 Eye Tighteners For the Price of 1 Taylor Lautner's Fiancée Taylor Dome Makes Twilight Confession Pretty Little Liars: Original Sin Is Changing Its Name %D0%B8%D1%81%D1%81%D0%BB%D0%B5%D0%B4%D0%BE%D0%B2%D0%B0%D0%BD%D0%B8%D0%B5 %D0%B1%D0%BE%D0%BB%D1%8C%D1%88%D0%B8%D1%85 %D1%8F%D0%B7%D1%8B%D0%BA%D0%BE%D0%B2%D1%8B%D1%85 %D0%BC%D0%BE%D0%B4%D0%B5%D0%BB 2 Demi Lovato Forced to Reschedule Concert After Losing Voice Selena Gomez's Contour Trick Is So Effective Yet Simple Beauty and the Beast Will Be ABC's Next Live Musical Event

Untuk bonus turnover ini sebesar 0.5% dengan pembagian setiap minggunya. Selain itu, bonus referral sebesar 20% bisa kamu dapatkan seumur hidup. Sangat menarik bukan?

%D0%B8%D1%81%D1%81%D0%BB%D0%B5%D0%B4%D0%BE%D0%B2%D0%B0%D0%BD%D0%B8%D0%B5 %D0%B1%D0%BE%D0%BB%D1%8C%D1%88%D0%B8%D1%85 %D1%8F%D0%B7%D1%8B%D0%BA%D0%BE%D0%B2%D1%8B%D1%85 %D0%BC%D0%BE%D0%B4%D0%B5%D0%BB 2 Kompatibel di Semua Perangkat

Kabar baiknya, Kamu bisa memainkan semua game pilihan kamu di situs %D0%B8%D1%81%D1%81%D0%BB%D0%B5%D0%B4%D0%BE%D0%B2%D0%B0%D0%BD%D0%B8%D0%B5 %D0%B1%D0%BE%D0%BB%D1%8C%D1%88%D0%B8%D1%85 %D1%8F%D0%B7%D1%8B%D0%BA%D0%BE%D0%B2%D1%8B%D1%85 %D0%BC%D0%BE%D0%B4%D0%B5%D0%BB 2 ini dengan berbagai jenis perangkat seperti Android, iOS, Windows Mobile, Windows PC, Mac OS. Sehingga kamu bisa memaikan game ini dimanapun dan kapanpun saja.

Teddi Mellencamp Undergoes Surgery After Stage 2 Melanoma Diagnosis Jennifer Lawrence Wishes She Took Adele's Advice About This Film lyricblackbird Watch Borat Wish Kim Kardashian a Happy Birthday as She Celebrates 42 Dwayne Johnson Surprises Mom With DREAM Home How Jenna Dewan Feels About Being Part of JoJo Siwa's "Gay Awakening" TikTok Star Cooper Noriega Dead at 19 gamesdokterhamil Kathy Hilton Breaks Silence After Calling Lizzo "Precious" Maren Morris Pokes Fun at Brittany Aldean Feud With Halloween Costume Watch Ozzy Osbourne Ditch His Cane for Slow Dance With Wife Sharon %D0%B8%D1%81%D1%81%D0%BB%D0%B5%D0%B4%D0%BE%D0%B2%D0%B0%D0%BD%D0%B8%D0%B5 %D0%B1%D0%BE%D0%BB%D1%8C%D1%88%D0%B8%D1%85 %D1%8F%D0%B7%D1%8B%D0%BA%D0%BE%D0%B2%D1%8B%D1%85 %D0%BC%D0%BE%D0%B4%D0%B5%D0%BB 2 Lori Harvey Shares Sexy Selfies After Michael B. Jordan Breakup Lindsay Lohan Sings "Jingle Bell Rock" Years After Mean Girls NFL Star J.J. Watt Welcomes First Baby With Wife Kealia Ohai Watt