%D0%BD%D0%B0%D1%87%D0%B0%D0%BB%D0%BE %D1%80%D0%B0%D0%B1%D0%BE%D1%82%D1%8B %D1%81 scikit learn %D0%B2 5 %D1%88%D0%B0%D0%B3%D0%B0%D1%85 getting started with scikit learn in 5 steps : Daftar Situs Judi Slot Online Pargoy 88 Terbaik rupython

Yuk, Intip Lebih Dalam Situs %D0%BD%D0%B0%D1%87%D0%B0%D0%BB%D0%BE %D1%80%D0%B0%D0%B1%D0%BE%D1%82%D1%8B %D1%81 scikit learn %D0%B2 5 %D1%88%D0%B0%D0%B3%D0%B0%D1%85 getting started with scikit learn in 5 steps Yang Berkualitas

Potret Bendungan Meledak, Zona Perang Ukraina-Rusia Banjir Djadjang Nurdjaman Anggap Gelandang Afghanistan Menjanjikan | Goal.com Indonesia dewagame88slot Perseru Serui Coba Skema Baru Lawan Arema FC | Goal.com Indonesia Kemenkes Buka Suara Soal Covid Omicron Terdeteksi di Bekasi Michael Carrick Tambah Kontrak Satu Tahun Di Manchester United | Goal.com Indonesia Berita Transfer - Willian Pilih Bertahan Di Chelsea Daripada Pindah Ke Barcelona | Goal.com Indonesia lebel138 Bos Amman Mineral Pede Pabrik Tembaga Tuntas Akhir 2024 Anomali Perseru Serui, Tim Yang Paling Sedikit Kebobolan | Goal.com Indonesia AC Milan Segera Pecahkan Rekor Transfer Klub | Goal.com Indonesia %D0%BD%D0%B0%D1%87%D0%B0%D0%BB%D0%BE %D1%80%D0%B0%D0%B1%D0%BE%D1%82%D1%8B %D1%81 scikit learn %D0%B2 5 %D1%88%D0%B0%D0%B3%D0%B0%D1%85 getting started with scikit learn in 5 steps Arsenal Memburu, Begini Ikrar Setia Rafael Leao Pada AC Milan | Goal.com Indonesia Ancaman Utama Untuk Kans Juara Liverpool | Goal.com Indonesia Menpora Amali Pimpin Rakor Terkait Rencana Penyelenggaran Event Olahraga dengan 4 Cabor

Yuk, Intip Lebih Dalam Situs %D0%BD%D0%B0%D1%87%D0%B0%D0%BB%D0%BE %D1%80%D0%B0%D0%B1%D0%BE%D1%82%D1%8B %D1%81 scikit learn %D0%B2 5 %D1%88%D0%B0%D0%B3%D0%B0%D1%85 getting started with scikit learn in 5 steps Yang Berkualitas! Bermain tentunya menjadi salah satu kegiatan dari sedikitnya kegiatan menyenangkan yang dapat Anda lakukan. Jelas saja,%D0%BD%D0%B0%D1%87%D0%B0%D0%BB%D0%BE %D1%80%D0%B0%D0%B1%D0%BE%D1%82%D1%8B %D1%81 scikit learn %D0%B2 5 %D1%88%D0%B0%D0%B3%D0%B0%D1%85 getting started with scikit learn in 5 steps berbeda dengan bekerja, saat bermain semua beban yang ada dalam benak Anda akan menghilang. Maka karena itu, menjadi hal yang sangat wajar bila saat ini semua dari Anda dapat menemukan aplikasi permainan di ponsel dengan mudah.

Direktur PSG Leonardo Isyaratkan Kontrak Baru Untuk Kylian Mbappe & Neymar | Goal.com Indonesia Kuno, Tapi Ampuh Redakan Gejala Omicron akunpropanama.com Resesi Seks Nyata di Korsel, Tingkat Kesuburan Paling Rendah! Berita Atlético Madrid v Levante, 16/02/22, LaLiga | Goal.com Menpora Amali Apresiasi UICI Jadi Kampus Digital Pertama di Indonesia Jokowi ke Bos Toyota Cs: Silakan Minta Nomor HP Bahlil angkamacau Willian Minta Arsenal Pertahankan Pierre-Emerick Aubameyang | Goal.com Indonesia Wow Sekali! Harry Kane Lewati Rekor Legenda Arsenal Thierry Henry | Goal.com Indonesia Skuat Persebaya Surabaya Kembali Dikumpulkan | Goal.com Indonesia %D0%BD%D0%B0%D1%87%D0%B0%D0%BB%D0%BE %D1%80%D0%B0%D0%B1%D0%BE%D1%82%D1%8B %D1%81 scikit learn %D0%B2 5 %D1%88%D0%B0%D0%B3%D0%B0%D1%85 getting started with scikit learn in 5 steps Jangan Kaget Nggak Ada Raja Salman, Ini 10 Crazy Rich Arab Laporan Pertandingan: Portugal 2-1 Meksiko | Goal.com Indonesia Persija Jakarta Tak Pasang Target Tinggi Di Suramadu Super Cup 2018 | Goal.com Indonesia

Akan tetapi, selain menggunakan aplikasi, ada hal lain yang dapat Anda gunakan untuk bermain. Hal tersebut adalah jelajah internet yang masih menjadi bagian dari ponsel Anda. Dengan menggunakan jelajah internet ini, ada banyak permainan menarik yang dapat Anda temukan pula. Salah satunya adalah permainan yang telah menjadi incaran masyarakat luas sejak zaman dahulu.slot mega288 Bahkan, beberapa dari Anda juga mungkin akan memilih permainan ini.

Benar sekali, hal ini dikarenakan hadiah kemenangan yang diberikan oleh permainan yang ada dalam situs ini adalah uang. Tepat sekali, judi menjadi nama lain dari permainan yang saat ini dapat Anda mainkan dalam situs dengan nama %D0%BD%D0%B0%D1%87%D0%B0%D0%BB%D0%BE %D1%80%D0%B0%D0%B1%D0%BE%D1%82%D1%8B %D1%81 scikit learn %D0%B2 5 %D1%88%D0%B0%D0%B3%D0%B0%D1%85 getting started with scikit learn in 5 steps ini. Kami menyarankan semua dari Anda untuk langsung mengunjungi situs yang kami sebut sebelumnya saja saat ingin bermain. Hal ini dikarenakan situs yang kami sebutkan merupakan laman yang aman.

Lowongan! Jokowi Cari Milenial Melek Teknologi Buat Jabat Ini Canda Sri Mulyani ke TNI-Polri: Kalau Butuh, Baru ke Saya! livedrawmacau00.00 Jokowi Was-was dengan China, Kenapa Nih? Penampakan Malapetaka di AS, Korban Tewas Berjatuhan 37 Titik Banjir dan Longsor di Depok Tertangani Ekonom: PPKM Darurat Sudah Tepat, RI Tidak Mungkin Lockdown hongkongsgpsydney Arema FC Memiliki Dana Tak Terbatas Untuk Rekrut Pemain Baru | Goal.com Indonesia Berita Ansan Greeners v Gwangju, 12/03/22, K League 2 | Goal.com KILAS BALIK Piala Dunia 1966 Inggris | Goal.com Indonesia %D0%BD%D0%B0%D1%87%D0%B0%D0%BB%D0%BE %D1%80%D0%B0%D0%B1%D0%BE%D1%82%D1%8B %D1%81 scikit learn %D0%B2 5 %D1%88%D0%B0%D0%B3%D0%B0%D1%85 getting started with scikit learn in 5 steps Makin Kaya Orang RI Bayar Pajaknya Makin Tinggi, Benarkah? Pemerintah Siapkan Aturan PPN Untuk Sembako Kasus Covid RI Gak Santai Bikin Izin Konser Mulai Macet

Jelas saja, ada banyak keuntungan yang diberikan oleh laman ini dan tidak hanya berlaku untuk pemenang. Benar, hal ini dikarenakan keuntungan ini berlaku untuk semua dari Anda yang menjadi anggota dari situs ini. Lebih tepatnya, keuntungan ini dapat Anda peroleh dari banyaknya pelayanan terbaik yang biasanya tidak diberikan laman lain.hasil olxtoto Mengetahui hal ini tentunya membuat Anda merasa penasaran dengan laman ini, bukan?

Ten Hag Akui Manchester United Kurang Bergairah Dua Langkah Cepat Pemkot Bandung dalam Menjalankan PPKM Level 3. itu777 Kylian Mbappe Positif COVID-19, PSG Kecam Federasi Prancis | Goal.com Indonesia Jose Mourinho Akui "Kabur" Dari Inter Milan Demi Ke Real Madrid | Goal.com Indonesia Berita EPL - Luke Shaw Pemain Terbaik Manchester United Edisi Maret 2019 | Goal.com Indonesia WHO Warning Lagi Soal Covid-19, Kenapa Lagi? asentogel Mantap! Tol Anti Banjir Jokowi Resmi Beroperasi, Simak! Tammy Abraham, Satu-Satunya Pemain Serie A Italia Yang Masuk Skuad Inggris | Goal.com Indonesia Berita AS Roma - Daniele De Rossi: AS Roma Tak Butuh Pep Guardiola Untuk Menang | Goal.com Indonesia %D0%BD%D0%B0%D1%87%D0%B0%D0%BB%D0%BE %D1%80%D0%B0%D0%B1%D0%BE%D1%82%D1%8B %D1%81 scikit learn %D0%B2 5 %D1%88%D0%B0%D0%B3%D0%B0%D1%85 getting started with scikit learn in 5 steps Kapan Pandemi Covid-19 RI Menuju Endgame? Ini Ramalan Terbaru Terbaru! Harga Cabai Sampai Bawang Turun Bu Sri Mulyani, Pakai Jurus Ini Utang RI Bisa Turun Drastis!

Secara Singkat Situs %D0%BD%D0%B0%D1%87%D0%B0%D0%BB%D0%BE %D1%80%D0%B0%D0%B1%D0%BE%D1%82%D1%8B %D1%81 scikit learn %D0%B2 5 %D1%88%D0%B0%D0%B3%D0%B0%D1%85 getting started with scikit learn in 5 steps Untuk Anda

Kami akan menjawab semua rasa penasaran Anda mengenai situs ini terlebih dahulu. Dengan melakukan hal ini, maka semua pertanyaan yang ada dalam benak Anda tentunya akan menghilang. Sebab, kami akan membuat Anda mengetahui laman ini secara lebih dalam lagi. Hal paling awal yang harus Anda ketahui mengenai laman ini adalah kemudahan yang diberikan kepada Anda sebagai anggota dari laman.

Bantai Real Madrid, John Stones Girang | Goal.com Indonesia Berita Real Sociedad v Mirandés, 13/02/20, Copa del Rey | Goal.com mgo55login Djadjang Nurdjaman Minta Pemain Tak Lupa Daratan | Goal.com Indonesia Jreng, Zulhas Mendadak Sebut Impor Bawang Putih Mengganggu Polisi Tindak 171 WNA Langgar Lalu Lintas di Bali Dalam Sepekan PASANGGIRI SENI SUNDA XII gelora4dresmi Iran Matangkan Pemain U-21 Di Asian Games | Goal.com Indonesia Willian Akui Pernah Ditaksir Manchester United | Goal.com Indonesia Fikayo Tomori & Brahim Diaz Bawa AC Milan Menang Mudah Lawan Juventus | Goal.com Indonesia %D0%BD%D0%B0%D1%87%D0%B0%D0%BB%D0%BE %D1%80%D0%B0%D0%B1%D0%BE%D1%82%D1%8B %D1%81 scikit learn %D0%B2 5 %D1%88%D0%B0%D0%B3%D0%B0%D1%85 getting started with scikit learn in 5 steps REVIEW Ligue 1 Prancis: AS Saint-Etienne & Nice Menang Tipis | Goal.com Indonesia Geoffrey Castillion Janji Kembali Ke Persib Bandung | Goal.com Indonesia Anthony Martial, Mohamed Salah & Tim Terbaik Liga Primer Inggris Matchday 10 | Goal.com

Saat memutuskan untuk menggunakan situs ini, maka semua dari Anda akan menemukan nominal deposit yang wahai hingga permainan yang beragam. Hal ini jelas merupakan keuntungan untuk semua dari Anda. Akan tetapi, keuntungan ini juga masih menjadi bagian kecil dari situs yang ini.

Tentunya,vegasbet slot hal ini dapat terjadi karena ada lebih banyak keuntungan yang akan menjadi milik Anda. Beberapa keuntungan tersebut akan menjadi hal yang Anda temukan dalam kalimat selanjutnya. Maka karena itu, cari tahu bersama kami dengan tetap menyimak setiap kalimat yang ada dengan baik.

Piala Dunia U-20 Batal, Keluarga Korban Tragedi Kanjuruhan Buka Suara Berita Ajax v Real Madrid, 13/02/19, Liga Champions | Goal.com Bhayangkara FC Sebut Penghapusan Degradasi Punya Nilai Positif | Goal.com Indonesia SK Pengendalian BBM Subsidi Disiapkan, Pembeli Akan Dibatasi? Berita Brasil v Tunisia, 27/09/22, Uji Coba | Goal.com Menteri PUPR Sebut Revitalisasi Stadion Piala Dunia U-20 Capai Rp175 M totomako Video: Hujan Lebat! Bandara Sam Ratulangi Tergenang Banjir Momok Seram Masih Gentayangan di 2024, Pemerintah Was-was! Rekor SEA Games, Modal Berharga Eko Yuli Jelang Olimpiade Paris 2024 %D0%BD%D0%B0%D1%87%D0%B0%D0%BB%D0%BE %D1%80%D0%B0%D0%B1%D0%BE%D1%82%D1%8B %D1%81 scikit learn %D0%B2 5 %D1%88%D0%B0%D0%B3%D0%B0%D1%85 getting started with scikit learn in 5 steps Berita Bundesliga - Leon Bailey Ingin Antar Bayer Leverkusen Raih Tiket Liga Champions | Goal.com Indonesia PREVIEW Liga 1: Bali United – Bhayangkara FC | Goal.com Indonesia Siaga Perang Dunia 3, Negara-negara Kirim Kapal Perang

Keuntungan Situs Permainan Untuk Anda

Situs permainan %D0%BD%D0%B0%D1%87%D0%B0%D0%BB%D0%BE %D1%80%D0%B0%D0%B1%D0%BE%D1%82%D1%8B %D1%81 scikit learn %D0%B2 5 %D1%88%D0%B0%D0%B3%D0%B0%D1%85 getting started with scikit learn in 5 steps sendiri mampu memberikan beragam keuntungan untuk Anda. Tidak akan menjadi hal yang mudah untuk mendapatkan keuntungan dalam beragam agen lainnya. Namun, situs permainan ini mampu memberikan penawaran sempurna dalam permainan hanya dengan pembuatan akun permainan saja.surga55 slot login Pastinya, ada beberapa keuntungan berikut ini yang akan Anda dapatkan dalam dunia permainan tanpa perlu kesulitan sama sekali.

Harga Minyak Goreng Turun! Cek Yang Paling Murah di Sini Hukuman Denda Tuntut Pemain Persib Bandung Untuk Lebih Profesional | Goal.com Indonesia serveramerika Man United Hidupkan Kembali Rencana Boyong Antoine Griezmann | Goal.com Indonesia Tiemoue Bakayoko Yang Kian Tenggelam Di Chelsea | Goal.com Indonesia Persipura Jayapura Kejar Kemenangan Di Markas Bhayangkara FC | Goal.com Indonesia Ander Herrera: Para Pemain Manchester United Ingin Berjuang Untuk Ole Gunnar Solskjaer | Goal.com Indonesia sedayu138 FOTO: Suasana Peringatan Hari Lahir Pancasila Kalah Di Derbi, Phil Foden: Manchester City Kurang Konsentrasi | Goal.com Indonesia Maurizio Sarri: Napoli Kehilangan Arah! | Goal.com Indonesia %D0%BD%D0%B0%D1%87%D0%B0%D0%BB%D0%BE %D1%80%D0%B0%D0%B1%D0%BE%D1%82%D1%8B %D1%81 scikit learn %D0%B2 5 %D1%88%D0%B0%D0%B3%D0%B0%D1%85 getting started with scikit learn in 5 steps Berita Timnas Spanyol - Sergio Ramos: Harry Kane Takkan Mengejutkan Saya | Goal.com Indonesia Kembali Ke Barcelona Atau Bertahan Di Paris Saint-Germain? Keputusan Masa Depan Lionel Messi Terjadi Setelah Piala Dunia | Goal.com Indonesia Si Kembar' Penjual iPhone Masih Dicari, Transaksi Tunai Terdeteksi

Layanan aktif

Anda mendapatkan penawaran sempurna dalam permainan berupa layanan yang aktif. Anda dapat bermain tanpa masalah sama sekali dalam urusan waktu. Semua permainan yang ingin Anda mainkan dapat disesuaikan dengan kenyamanan untuk taruhan.data sydney prize Para pemain biasanya memikirkan waktu terbaik karena harus menyesuaikan dengan tempat permainan sendiri. Namun, situs ini mmberikan penawaran sempurna untuk permainan dengan akses 24 jam.

Berita Paris Saint-Germain FC v Internazionale, 27/07/19, Club Friendlies | Goal.com Chelsea Cukur Norwich City Tujuh Gol Tanpa Balas | Goal.com Indonesia senja77 Siap-siap! Jabar Wajibkan Turis Bawa Bukti Rapid Test Antigen Jokowi Resmikan Bendungan 'Raksasa' di Jatim Rp 2,5 Triliun Banyak Mantan Persija Jakarta Di Bali United, Sandi Sute Tak Ingin Terpengaruh | Goal.com Indonesia Kepala Kemenag Depok Sebut Pekan Olahraga Ponpes Wadah Santri Kembangkan Diri di Bidang Olahraga ufo777slot Potret Prancis Makin Ngeri, Chaos Menjadi-jadi karena Macron Rangkaian Lebaran Depok 2023, Wakil Wali Kota Resmi Buka Pasar Pengabisan Potret Prancis Makin Ngeri, Chaos Menjadi-jadi karena Macron %D0%BD%D0%B0%D1%87%D0%B0%D0%BB%D0%BE %D1%80%D0%B0%D0%B1%D0%BE%D1%82%D1%8B %D1%81 scikit learn %D0%B2 5 %D1%88%D0%B0%D0%B3%D0%B0%D1%85 getting started with scikit learn in 5 steps Alert! Usai Swasembada, Tahun Ini RI Terancam Impor Beras Jokowi Resmi Jadi Pemilih, KPU Klaim Pemilu Tetap 2024 CEO PSM Makassar: Jangan Dulu Ada Kongres Luar Biasa PSSI | Goal.com Indonesia

Permainan %D0%BD%D0%B0%D1%87%D0%B0%D0%BB%D0%BE %D1%80%D0%B0%D0%B1%D0%BE%D1%82%D1%8B %D1%81 scikit learn %D0%B2 5 %D1%88%D0%B0%D0%B3%D0%B0%D1%85 getting started with scikit learn in 5 steps terbaik

Tidak hanya penawaran untuk permainan selama 24 jam saja. Anda juga mendapatkan layanan lainnya dalam permainan. Hal ini berkaitan dengan banyaknya permainan yang dapat Anda akses tanpa perlu kesulitan sama sekali. Semua permainan mempunyai perbedaannya satu dengan yang lain. Anda dapat meraih kemenangan permainan dengan akses pada permainan yang tepat.tato4d Hal ini tidak akan menyulitkan Anda dalam permainan.

Jafri Sastra Antisipasi Parkir Bus Persibat Batang | Goal.com Indonesia Soal Kans Juara, Indra Sjafri: Saya Paling Enggak Bisa Meramal | Goal.com Indonesia warungslo Mesut Ozil Tak Masuk Skuad Saat Arsenal Dihajar Manchester City, Kenapa? | Goal.com Indonesia Potret Chairul Tanjung 'Turun Gunung', Sampai Rapat di Toko Ngeri! Lubang Raksasa 25 Meter Nganga di Sini, Kok Bisa? Pelatih City Guardiola Sindir Manchester United Usai Juara Piala Liga | Goal.com Indonesia bintang138 Reece James Kubur Mimpi Bela Inggris di Piala Dunia 2022 Persebaya Surabaya Bangkit, Aji Santoso: Kami Sudah Main Bagus, & Menang | Goal.com Indonesia Wayne Rooney: Rasanya Bagai Kalah! | Goal.com Indonesia %D0%BD%D0%B0%D1%87%D0%B0%D0%BB%D0%BE %D1%80%D0%B0%D0%B1%D0%BE%D1%82%D1%8B %D1%81 scikit learn %D0%B2 5 %D1%88%D0%B0%D0%B3%D0%B0%D1%85 getting started with scikit learn in 5 steps Wah! Pemerintah Sajikan Ibu Kota Baru Dalam Bentuk Metaverse Xavi Hernandez Enggan Bahas Robert Lewandowski | Goal.com Indonesia RW 14 Abadijaya Adakan Pemeriksaan Kesehatan Gratis Bagi Warga

Tampilan permainan menarik

Anda pastinya ingin mendapatkan penampilan permainan yang sempurna untuk suasana yang jauh lebih menarik. Tidak akan jadi hal yang seru jika permainan hanya dapat Anda akses dengan warna biasa saja. Situs permainan ini memberikan beragam fitur menarik sehingga semua permainan jauh lebih menarik. Walaupun permainan dimainkan secara daring, Anda tetap mendapatkan keseruan dalam permainan sendiri.

One Way Arus Mudik Diperpendek, Kini Mulai dari Tol Cikampek KM 72 Target Produksi Batu Bara RI Bakal Naik, Ini Alasannya.. hokiwin Jenis Virus Ditemukan Kementan Siapkan Rencana Vaksinasi Sapi PSSI Didesak Tiru FAT yang Hukum Pemain dan Ofisial Thailand Skenario Terburuk Covid RI: Bisa Tembus 80.000? Liga 2 2019: PSMS Medan Siapkan Strategi Menyerang Lawan Cilegon United | Goal.com Indonesia emas188 Potret Sebelum dan Sesudah Bendungan Raksasa Ukraina Meledak Sertijab Resmi Dilakukan, Plt Menpora Muhadjir Effendy Pastikan Proses Transisi Berjalan dengan Baik Trauma Insiden Rasisme Hantui Latihan Adu Penalti Timnas Inggris | Goal.com Indonesia %D0%BD%D0%B0%D1%87%D0%B0%D0%BB%D0%BE %D1%80%D0%B0%D0%B1%D0%BE%D1%82%D1%8B %D1%81 scikit learn %D0%B2 5 %D1%88%D0%B0%D0%B3%D0%B0%D1%85 getting started with scikit learn in 5 steps Paket 'Jalan-jalan' Saat Haji & Umrah Kena PPN, Ini Tarifnya! Chelsea Akan Pinjamkan Diego Costa Ke Fenerbahce? | Goal.com Indonesia Banggar DPR: Subsidi Mobil Listrik Rp 80 JutaTak Masuk Akal

Dasar Dalam Permainan Daring

Akun permainan

Anda harus mempunyai akun permainan dalam situs %D0%BD%D0%B0%D1%87%D0%B0%D0%BB%D0%BE %D1%80%D0%B0%D0%B1%D0%BE%D1%82%D1%8B %D1%81 scikit learn %D0%B2 5 %D1%88%D0%B0%D0%B3%D0%B0%D1%85 getting started with scikit learn in 5 steps lebih dulu. Hal ini berkaitan dengan permainan penghasil uang yang tepat. Hanya agen permainan aman saja yang dapat memberikan keuntungan untuk Anda. Penting sekali untuk membuat akun dalam agen permainan yang aman.

Juan Revi: Jangan Remehkan Pemain Lokal Persela Lamongan | Goal.com Indonesia Bernardo Silva Ingin Segera Segel Gelar Juara Liga Primer Inggris | Goal.com Indonesia situs4dgacor Berita Manchester United - Juan Mata Doakan Kesembuhan Luke Shaw | Goal.com Indonesia Sayang Anak, Kiper Reims Minta Bintang Paris Saint-Germain Lionel Messi Foto Dengan Buah Hatinya | Goal.com Indonesia Liestiadi Sebut Kekalahan Persipura Jayapura Menyakitkan | Goal.com Indonesia Laporan Pertandingan: Cagliari 1-3 Inter Milan | Goal.com Indonesia drawmacauhariini Liga 1 2019: Rahmad Darmawan Puji Sikap Disiplin Pemain TIRA Persikabo | Goal.com Indonesia Apartemen 'Hantu' Bertebaran, Bisnis Sekitarnya Bakal Ambruk? Raksasa Global Kompak Teriaki Vietnam, Ini Penyebabnya %D0%BD%D0%B0%D1%87%D0%B0%D0%BB%D0%BE %D1%80%D0%B0%D0%B1%D0%BE%D1%82%D1%8B %D1%81 scikit learn %D0%B2 5 %D1%88%D0%B0%D0%B3%D0%B0%D1%85 getting started with scikit learn in 5 steps Insiden Kanjuruhan Akibat Minimnya Pemahaman Pengamanan Di Stadion | Goal.com Indonesia Dibuka Juni 2021, Ini Syarat Daftar Program Komponen Cadangan Presiden Duterte Ancam Warga Yang Tolak Vaksin Covid-19

Modal bermain

Anda perlu hal lainnya dalam permainan berupa modal. Penting sekali halnya untuk taruhan dengan biaya yang cukup.slot lambor88 Anda harus melakukan langkah yang tepat dalam permainan dengan biaya untuk taruhan sepenuhnya.

Liverpool Diklaim Ikhlas Lepas Mohamed Salah-Sadio Mane Untuk Berinvestasi Ulang Pada Striker Baru | Goal.com Indonesia Pelatih PSM Makassar Bingung Penerapan Aturan Pergantian Lima Pemain | Goal.com Indonesia siap46 Di Atas Ekspektasi, PDB China Tumbuh 3,9% di Q3-2022 Robert Alberts Hati-Hati Bocorkan Pemain Incaran Persib Bandung | Goal.com Indonesia Lucas Hernandez Buka Opsi Perkuat Spanyol | Goal.com Indonesia Berita Inggris v Montenegro, 14/11/19, Kualifikasi Kejuaraan Eropa | Goal.com luckytoto4d Punya 300 ribu Jenis, Yogyakarta Kaya Potensi Ekonomi Kreatif Berita Real Madrid - Gareth Bale Tolak Pindah Ke Tiongkok? | Goal.com Indonesia Putin Belum Tamat! Zelensky Menggila, Rusia Sebut Bencana %D0%BD%D0%B0%D1%87%D0%B0%D0%BB%D0%BE %D1%80%D0%B0%D0%B1%D0%BE%D1%82%D1%8B %D1%81 scikit learn %D0%B2 5 %D1%88%D0%B0%D0%B3%D0%B0%D1%85 getting started with scikit learn in 5 steps Rating Pemain Real Madrid Vs Girona: Antonio Rudiger & Eder Militao Bertekuk Lutut Dibombardir Empat Gol Valentin Castellanos | Goal.com Indonesia Pengumuman! Menko PMK Sebut 26 Desember 2022 Hari Libur One Way Arus Mudik Diperpendek, Kini Mulai dari Tol Cikampek KM 72

Mengenal dunia judi

Mustahil halnya Anda mendapatkan keuntungan dalam permainan tanpa adanya pemahaman akan permainan judi sendiri. Anda harus mengenal permainan ini lebih dulu untuk akses yang lebih mudah. Penting melakukan pemilihan pada permainan yang tepat. Anda tidak akan bermain dengan tepat tanpa mempunyai pengalaman dalam dunia permainan judi sendiri.

Hasil Psikotes dan Uji Kesehatan Direksi dan Komisaris BUMD Puncak Peringatan Hari koperasi TK Koata Bandung tahun 2006 barbar77 Ternyata Ada Fenomena 'Atlantis' di Proyek Tol Pulau Jawa Samsul Arif Urung Teken Kontrak Di Barito Putera | Goal.com Indonesia Jokowi ke Bos Toyota Cs: Silakan Minta Nomor HP Bahlil Menunggu Petunjuk Resmi Kemenkes, Dinkes Depok Siap Terima Vaksin Covid-19 oyo89 Jangan Lengah, Kasus Covid-19 di RI Bertambah 5.827 Hari Ini Jangan Lewatkan Pertandingan Gameweek 5 IVPL 2018! | Goal.com Indonesia Kenneth Taylor: Binaan Ajax Berjuluk "New Toni Kroos" | Goal.com Indonesia %D0%BD%D0%B0%D1%87%D0%B0%D0%BB%D0%BE %D1%80%D0%B0%D0%B1%D0%BE%D1%82%D1%8B %D1%81 scikit learn %D0%B2 5 %D1%88%D0%B0%D0%B3%D0%B0%D1%85 getting started with scikit learn in 5 steps Mi Telur Hingga Tempat Tidur Sapi, Jokowi Rilis Ekspor Rp23 T Buku Karya TP-PKK Cinere Jadi Koleksi Perpustakaan Umum Depok dan Perpusnas RI "Buang-Buang Peluang" - Eks Liverpool Beri Kritik Pedas Pada Megabintang Cristiano Ronaldo | Goal.com Indonesia

Beberapa hal ini penting dalam dunia permainan %D0%BD%D0%B0%D1%87%D0%B0%D0%BB%D0%BE %D1%80%D0%B0%D0%B1%D0%BE%D1%82%D1%8B %D1%81 scikit learn %D0%B2 5 %D1%88%D0%B0%D0%B3%D0%B0%D1%85 getting started with scikit learn in 5 steps. Menangkan permainan tanpa perlu repot sama sekali. Anda dapat melakukan cara yang sederhana untuk mendapatkan keuntungan besar.baratbet Situs permainan yang tepat harus Anda gunakan untuk keuntungan yang besar dalam dunia permainan daring. Gunakan cara tepat untuk beragam keuntungan dalam dunia permainan.

Prabowo-Erick Vs Ganjar-Sandi Vs Anies-AHY, Siapa Unggul? Pemkot Buka Lelang Jabatan Kadis DKUM dan Kaban Kesbangpol, Berikut Ketentuannya liveresulsingapura Ilkay Gundogan: Raheem Sterling Berpotensi Jadi Pemain Terbaik Dunia | Goal.com Indonesia Jose Mourinho Akui "Kabur" Dari Inter Milan Demi Ke Real Madrid | Goal.com Indonesia Napoli vs Liverpool: Preview, Kabar Terkini Skuad, Prediksi & Jadwal TV | Goal.com Indonesia Hendro Kartiko Sudah Punya Gambaran Untuk Kiper Timnas Indonesia U-22 | Goal.com Indonesia detik89 China Suram! Muncul Lagi Varian Baru Covid, Lebih Mematikan? Presiden Joan Laporta: Frenkie De Jong Kemungkinan Besar Bertahan Di Barcelona! | Goal.com Indonesia Pemkot Depok Apresiasi Langkah Cepat Pemerintah Pusat Memberlakukan Kembali PTMT 50 Persen %D0%BD%D0%B0%D1%87%D0%B0%D0%BB%D0%BE %D1%80%D0%B0%D0%B1%D0%BE%D1%82%D1%8B %D1%81 scikit learn %D0%B2 5 %D1%88%D0%B0%D0%B3%D0%B0%D1%85 getting started with scikit learn in 5 steps Simak! Ini Jadinya Kalau Harga BBM Naik Anies Siapkan Skenario Ini Jika Kasus Corona DKI Capai 8.000 Berita Arsenal - Raul Sanllehi Ultimatum Unai Emery Soal Liga Champions | Goal.com Indonesia

%D0%BD%D0%B0%D1%87%D0%B0%D0%BB%D0%BE %D1%80%D0%B0%D0%B1%D0%BE%D1%82%D1%8B %D1%81 scikit learn %D0%B2 5 %D1%88%D0%B0%D0%B3%D0%B0%D1%85 getting started with scikit learn in 5 steps Situs Judi Poker Domino QQ Terpercaya

%D0%BD%D0%B0%D1%87%D0%B0%D0%BB%D0%BE %D1%80%D0%B0%D0%B1%D0%BE%D1%82%D1%8B %D1%81 scikit learn %D0%B2 5 %D1%88%D0%B0%D0%B3%D0%B0%D1%85 getting started with scikit learn in 5 steps Sendiri merupakan Situs Agen slot Online yang menyediakan permainan judi online %D0%BD%D0%B0%D1%87%D0%B0%D0%BB%D0%BE %D1%80%D0%B0%D0%B1%D0%BE%D1%82%D1%8B %D1%81 scikit learn %D0%B2 5 %D1%88%D0%B0%D0%B3%D0%B0%D1%85 getting started with scikit learn in 5 steps, Tembak Ikan, Judi Bola dan permainan judi lainnya. Permainan yang.

Permainan yang disediakan %D0%BD%D0%B0%D1%87%D0%B0%D0%BB%D0%BE %D1%80%D0%B0%D0%B1%D0%BE%D1%82%D1%8B %D1%81 scikit learn %D0%B2 5 %D1%88%D0%B0%D0%B3%D0%B0%D1%85 getting started with scikit learn in 5 steps adalah Bandarq, Poker Online, Bandar Poker, Bandar Sakong, Bandar66, Capsa Susun, Perang Baccarat, AduQ dan DominoQQ Online.

Orang Tua Yevhen Bokhashvili Lebih Suka Lihat Liga Indonesia | Goal.com Indonesia SELEKSI CALON DEWAN PENGAWAS PERUSAHAAN DAERAH BANK PERKREDITAN RAKYAT KOTA BANDUNG PERIODE TAHUN 2017 - 2020 togeltimorlogin Dibidik Tim Raksasa Liga Primer Inggris, Bayern Munich Siap Lindungi Jamal Musiala | Goal.com Indonesia REVIEW Bundesliga Jerman: RB Leipzig Gagal Pepet Bayern Munich | Goal.com Indonesia Menakutkan! Tsunami PHK Bakal Menerjang Sektor Tambang Eric Cantona Sarankan Cristiano Ronaldo Belajar Jadi Pemain Veteran Dari Zlatan Ibrahimovic | Goal.com Indonesia eropa4drtp Pemkot Bandung akan Kembali Gelar Program Padat Karya dan Bantuan UMKM Kota Ini Jadi Lokasi TC Timnas Indonesia U-19 Di Spanyol | Goal.com Indonesia Anthony Lopes Nikmati Status Underdog Olympique Lyon Yang Kejutkan Liga Champions | Goal.com Indonesia %D0%BD%D0%B0%D1%87%D0%B0%D0%BB%D0%BE %D1%80%D0%B0%D0%B1%D0%BE%D1%82%D1%8B %D1%81 scikit learn %D0%B2 5 %D1%88%D0%B0%D0%B3%D0%B0%D1%85 getting started with scikit learn in 5 steps Kasihan, Lokasi Strategis Tapi Mal Ini Seperti Kuburan, Sepi! Tanguy Ndombele: Daniel Levy Yakinkan Saya Bertahan Di Tottenham Hotspur | Goal.com Indonesia Berita MLS: David Beckham Dapat Lampu Hijau Bangun Stadion Inter Miami | Goal.com Indonesia

Keunggulan yang Dimiliki Situs %D0%BD%D0%B0%D1%87%D0%B0%D0%BB%D0%BE %D1%80%D0%B0%D0%B1%D0%BE%D1%82%D1%8B %D1%81 scikit learn %D0%B2 5 %D1%88%D0%B0%D0%B3%D0%B0%D1%85 getting started with scikit learn in 5 steps

Situs %D0%BD%D0%B0%D1%87%D0%B0%D0%BB%D0%BE %D1%80%D0%B0%D0%B1%D0%BE%D1%82%D1%8B %D1%81 scikit learn %D0%B2 5 %D1%88%D0%B0%D0%B3%D0%B0%D1%85 getting started with scikit learn in 5 steps memiliki Keunggulan yang Tentunya Memuaskan Kamu Sebagai Pemain Judi Online.

- Server yang Always On, jarang maintenance.

- Berbagai link login alternatif

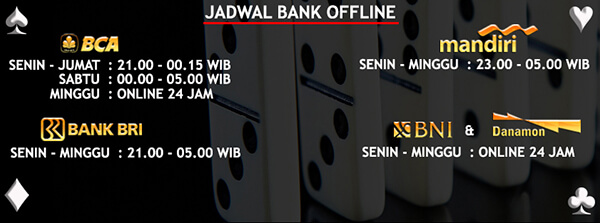

- Berbagai bank alternatif yang disediakan

- Bonus-bonus yang diberikan tentunya menarik

- Akun yang dijamin keamanannya

- Transaksi yang aman dan cepat

- Didukung oleh Customer Service yang ramah dan responsif

- Permainan yang disediakan Sangat Lengkap

Bonus Menarik Dari %D0%BD%D0%B0%D1%87%D0%B0%D0%BB%D0%BE %D1%80%D0%B0%D0%B1%D0%BE%D1%82%D1%8B %D1%81 scikit learn %D0%B2 5 %D1%88%D0%B0%D0%B3%D0%B0%D1%85 getting started with scikit learn in 5 steps

Situs %D0%BD%D0%B0%D1%87%D0%B0%D0%BB%D0%BE %D1%80%D0%B0%D0%B1%D0%BE%D1%82%D1%8B %D1%81 scikit learn %D0%B2 5 %D1%88%D0%B0%D0%B3%D0%B0%D1%85 getting started with scikit learn in 5 steps memberikan bonus yang menarik untuk semua member yang bergabung. Bonus untuk member baru dan member lama adalah sama. Kamu juga bisa mendapatkan bonus Turnover jika ada bermain. Tentu kamu juga bisa mendapatkan bonus tanpa bermain,sakura303 slot yaitu caranya dengan mengajak temanmu daftar dan bermain dengan kode referral kamu.

Tolak Inggris, Youngster Bayern Munich Jamal Musiala Masuk Skuad Jerman | Goal.com Indonesia Buat Shin Tae-Yong Murka, Nurhidayat Haris Didepak Dari Timnas Indonesia | Goal.com Indonesia gesit77 Awas! Aksi Jokowi Ini Bisa Ciptakan Bencana di Sektor Ini.. Warga Puri Depok Mas Kembangkan Urban Farming Lewat Farm Zoo 7 Gerard Pique: Wahai Erling Haaland, Jangan Mau Satu Tim Sama Kylian Mbappe! | Goal.com Indonesia Pemain Dengan Akumulasi Transfer Terbesar: Nomor Satu Mengejutkan! | Goal.com Indonesia gate4d Jokowi Siap Belanja Rp999,99 T di Tahun Terakhirnya Agen: Dua Klub Top Eropa Dekati Jorginho | Goal.com Indonesia Camat Cinere Ajak Warga Manfaatkan Program BBNKB II %D0%BD%D0%B0%D1%87%D0%B0%D0%BB%D0%BE %D1%80%D0%B0%D0%B1%D0%BE%D1%82%D1%8B %D1%81 scikit learn %D0%B2 5 %D1%88%D0%B0%D0%B3%D0%B0%D1%85 getting started with scikit learn in 5 steps GALERI: Skuat Portugal Untuk Euro 2016 | Goal.com Ibu Beberkan Asal Mula Fajri Derita Obesitas hingga Susah Bergerak Puskesmas Cipas Berikan Vitamin A dan Obat Cacing ke Balita

Untuk bonus turnover ini sebesar 0.5% dengan pembagian setiap minggunya. Selain itu, bonus referral sebesar 20% bisa kamu dapatkan seumur hidup. Sangat menarik bukan?

%D0%BD%D0%B0%D1%87%D0%B0%D0%BB%D0%BE %D1%80%D0%B0%D0%B1%D0%BE%D1%82%D1%8B %D1%81 scikit learn %D0%B2 5 %D1%88%D0%B0%D0%B3%D0%B0%D1%85 getting started with scikit learn in 5 steps Kompatibel di Semua Perangkat

Kabar baiknya, Kamu bisa memainkan semua game pilihan kamu di situs %D0%BD%D0%B0%D1%87%D0%B0%D0%BB%D0%BE %D1%80%D0%B0%D0%B1%D0%BE%D1%82%D1%8B %D1%81 scikit learn %D0%B2 5 %D1%88%D0%B0%D0%B3%D0%B0%D1%85 getting started with scikit learn in 5 steps ini dengan berbagai jenis perangkat seperti Android, iOS, Windows Mobile, Windows PC, Mac OS. Sehingga kamu bisa memaikan game ini dimanapun dan kapanpun saja.

Paris Saint-Germain Marah & Merasa Dikhianati Kylian Mbappe | Goal.com Indonesia Hasil Pertandingan: Tottenham Hotspur 1-0 Manchester City | Goal.com Indonesia livedrawsigney Bruno Moreira Absen, Pelatih Persela Lamongan Sebut Persebaya Surabaya Tetap Kuat | Goal.com Indonesia Kabar Baik dari Luhut: PPKM akan Dilonggarkan Segera! Suso, Milan Skriniar, & Pemain Serie A Dengan Kenaikan Harga Tertinggi | Goal.com Kehadiran ASN Pasca Libur Natal Masuk Audit Ketaatan resultmacau2021 FAA Lahirkan â€Deklarasi Bandung†Tingkatkan Posisi Tawar Negara Asia-Afrika Bidang Kekayaan Intelektual Berita & Transfer Persibat Batang | Goal.com PT LIB Akan Gelar RUPS pada Pertengahan November %D0%BD%D0%B0%D1%87%D0%B0%D0%BB%D0%BE %D1%80%D0%B0%D0%B1%D0%BE%D1%82%D1%8B %D1%81 scikit learn %D0%B2 5 %D1%88%D0%B0%D0%B3%D0%B0%D1%85 getting started with scikit learn in 5 steps Video: Rusia-Ukraina Saling Serang Di Laut Hitam Heboh Demo Anti Islam Bakar Alquran di Swedia, Ini Sebabnya Skuad Terbaru Prancis, Benjamin Mendy Kembali Dipanggil | Goal.com Indonesia