Познакомьтесь с TinyLlama небольшой моделью искусственного интеллекта, которая стремится предварительно обучить модель ламы с 1,1 миллиарда параметров на 3 трлн. токенов.

Познакомьтесь с TinyLlama - небольшой моделью ИИ, которая предварительно обучает модель ламы с 1,1 млрд параметров на 3 трлн. токенов.

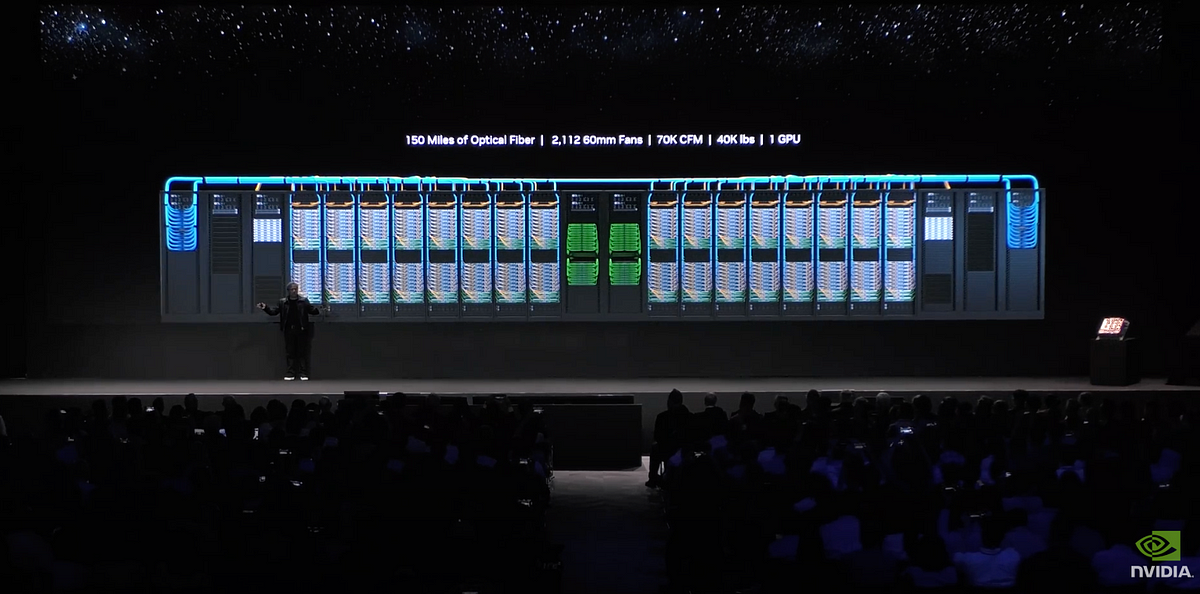

В постоянно меняющейся области исследования языковых моделей стремление к эффективности и масштабируемости привело к революционному проекту – TinyLlama. Этот смелый проект, возглавляемый научным сотрудником Сингапурского университета, нацелен на предварительное обучение модели с 1,1 миллиардом параметров на ошеломляющих 3 трлн. токенов всего за 90 дней, используя скромную настройку из 16 GPU A100-40G. Потенциальные последствия этого предприятия огромны, поскольку оно обещает переопределить границы того, что раньше было считаемым возможным в области компактных языковых моделей.

В то время как существующие модели, такие как LLaMA и Llama 2 от Meta, уже продемонстрировали впечатляющие возможности при меньших размерах, TinyLlama идет еще дальше. Модель с 1,1 миллиардом параметров занимает всего 550 МБ оперативной памяти, что делает ее потенциальным игроком-изменяющим-правила-игры для приложений с ограниченными вычислительными ресурсами.

Критики сомневаются в выполнимости такого амбициозного предприятия, особенно в свете закона масштабирования морской свинки. Этот закон утверждает, что для оптимальной вычислительной мощности количество параметров и обучающих токенов должно масштабироваться пропорционально. Однако проект TinyLlama бросает вызов этой идее, нацеливаясь на демонстрацию того, что небольшая модель может процветать на огромном наборе данных для обучения.

- Alibaba представляет две открытые модели обработки больших объемов данных на основе зрительного языка (LVLM) Qwen-VL и Qwen-VL-Chat

- Переосмысление академической честности в эпоху искусственного интеллекта Сравнительный анализ ChatGPT и студентов университетов в 32 курсах

- Побудить инженерию использовать контекстное обучение в больших языковых моделях

Статья Llama 2 от Meta показала, что даже после предварительного обучения на 2 трлн. токенов модели не проявляли признаков насыщения. Это наблюдение, возможно, побудило ученых идти дальше, направляясь к предварительному обучению на 3 трлн. токенов для TinyLlama. Дебаты о необходимости все более крупных моделей продолжаются, при этом усилия Meta по опровержению закона масштабирования морской свинки находятся в центре этой дискуссии.

Если проект TinyLlama будет успешным, он может наступить на новую эру для приложений искусственного интеллекта, позволяя мощным моделям работать на отдельных устройствах. Однако, если проект не сможет достичь поставленных целей, закон масштабирования морской свинки может подтвердить свою актуальность. Исследователи сохраняют прагматическую точку зрения, подчеркивая, что это предприятие является открытым испытанием без обещаний или заранее определенных целей, за исключением амбициозной цели «1,1 млрд на 3 трлн».

По мере продвижения проекта TinyLlama в фазе обучения, сообщество искусственного интеллекта следит с задержкой дыхания. Если проект будет успешным, он сможет не только вызвать сомнения в существующих законах масштабирования, но и революционизировать доступность и эффективность передовых языковых моделей. Время покажет, сможет ли TinyLlama одержать победу или закон масштабирования морской свинки устоит перед этим смелым экспериментом.