ai cataclysm data poisoning and model collapse >> Daftar Slot Gacor Situs Judi Slot Online RTP rupython

Yuk, Intip Lebih Dalam Situs ai cataclysm data poisoning and model collapse Yang Berkualitas

Daftar Mobil Baru Murah Mulai Rp 100 Jutaan Juni 2021, Cek! Tak Mau Vaksin, Hidup Warga Prancis Akan Dipersulit catkayumowilexwarnacoklat Berita Transfer - Manchester United, Real Madrid & Klub-Klub Top Eropa Buru Boubakary Soumare | Goal.com Indonesia Berita PSM v Borneo, 02/12/19, Liga 1 | Goal.com Jokowi Rombak Penanganan Covid, Luhut & Airlangga Komandan! Chelsea Alihkan Bidikan Ke Moussa Dembele | Goal.com Indonesia apakahhpxiaomicepatrusak Mengintip Etihad Campus-nya Manchester City: Bagaimana Filosofi Tiki-Taka Pep Guardiola Diterapkan Sejak Dini | Goal.com Indonesia Polisi Tangkap Gangster Pemuda Acungkan Pedang di Wonoayu Sidoarjo Vietnam Siapkan Timnas U-22 Untuk Piala AFF 2020 | Goal.com Indonesia ai cataclysm data poisoning and model collapse Ole Gunnar Solskjaer: David De Gea Kiper Terbaik Dunia | Goal.com Indonesia Berita Singapore U22 v Philippines U22, 07/06/19, Merlion Cup U22 | Goal.com PPKM Jawa-Bali Diperpanjang (Lagi) 2 Pekan!

Yuk, Intip Lebih Dalam Situs ai cataclysm data poisoning and model collapse Yang Berkualitas! Bermain tentunya menjadi salah satu kegiatan dari sedikitnya kegiatan menyenangkan yang dapat Anda lakukan. Jelas saja,ai cataclysm data poisoning and model collapse berbeda dengan bekerja, saat bermain semua beban yang ada dalam benak Anda akan menghilang. Maka karena itu, menjadi hal yang sangat wajar bila saat ini semua dari Anda dapat menemukan aplikasi permainan di ponsel dengan mudah.

PREVIEW Liga Primer Inggris: Crystal Palace - Liverpool | Goal.com Indonesia Berita UEFA Nations League - Gareth Southgate: Inggris Ingin Raih Trofi | Goal.com Indonesia frekuensitelkom4mpeg2terbaru2022 30 Tahun Jualan, Pedagang Baju Bekas Mendadak Susah Makan Perbesar Kans Juara, Pelatih Persija Jakarta Mau Skuatnya Kerja Keras | Goal.com Indonesia Warga Sukmajaya Diimbau Pastikan Gas dan Listrik Rumah Aman Sebelum Mudik Dunia Gempar! IMF, Bank Dunia & Sri Mulyani Bawa Kabar Buruk perumtas7 Tanpa Persib Bandung, Enam Klub Liga 1 Lolos Lisensi Liga Champions Asia | Goal.com Indonesia Rekayasa Baru Jalan Supratman dan Seputar Monpera Hasil Final Bulu Tangkis SEA Games 2023: Jadi Pemenang Derbi Merah-Putih, Ana/Tiwi Sabet Emas ai cataclysm data poisoning and model collapse BERITA ITALIA - Roberto Mancini Bidik Final UEFA Nations League | Goal.com Indonesia ASBWI Umumkan Sesuatu Yang Baru | Goal.com Indonesia Klub Kaget Ratu Tisha Mundur Dari PSSI | Goal.com Indonesia

Akan tetapi, selain menggunakan aplikasi, ada hal lain yang dapat Anda gunakan untuk bermain. Hal tersebut adalah jelajah internet yang masih menjadi bagian dari ponsel Anda. Dengan menggunakan jelajah internet ini, ada banyak permainan menarik yang dapat Anda temukan pula. Salah satunya adalah permainan yang telah menjadi incaran masyarakat luas sejak zaman dahulu.cara flash evercross a7s Bahkan, beberapa dari Anda juga mungkin akan memilih permainan ini.

Benar sekali, hal ini dikarenakan hadiah kemenangan yang diberikan oleh permainan yang ada dalam situs ini adalah uang. Tepat sekali, judi menjadi nama lain dari permainan yang saat ini dapat Anda mainkan dalam situs dengan nama ai cataclysm data poisoning and model collapse ini. Kami menyarankan semua dari Anda untuk langsung mengunjungi situs yang kami sebut sebelumnya saja saat ingin bermain. Hal ini dikarenakan situs yang kami sebutkan merupakan laman yang aman.

Ada Tanda 'Resesi Seks', Politisi Eropa Ini Salahkan Alkohol Kebun Sawit hingga Besi Tua Paling Diincar Orang di Lelang gantiolishockdepanbeat Indra Sjafri Blak-blakan Soal STY Nonton Indonesia vs Vietnam Polisi Periksa CCTV dan Saksi Dalami Mutilasi Surabaya Rusia Beri Tanggapan Dingin Proposal Keamanan AS Luis Suarez Buka Peluang Hijrah Ke MLS | Goal.com Indonesia hargaolympusomdem10 Ukraina Diserang Rusia, Ini Langkah Balasan NATO Jesse Lingard Terancam Absen Lawan Chelsea | Goal.com Indonesia Delapan Tim Ikuti Nasional Senior Ramadan League | Goal.com Indonesia ai cataclysm data poisoning and model collapse PSIS Semarang Kirim PSS Sleman Ke Zona Merah, RANS Nusantara Bekap Bhayangkara FC | Goal.com Indonesia Nikmat Banget PNS Ini! Dapat Bonus dari Jokowi, Mau Naik Gaji Berita Serie A: Presiden Fiorentina Muak Dengan Kegagalan Juventus Di Eropa | Goal.com Indonesia

Jelas saja, ada banyak keuntungan yang diberikan oleh laman ini dan tidak hanya berlaku untuk pemenang. Benar, hal ini dikarenakan keuntungan ini berlaku untuk semua dari Anda yang menjadi anggota dari situs ini. Lebih tepatnya, keuntungan ini dapat Anda peroleh dari banyaknya pelayanan terbaik yang biasanya tidak diberikan laman lain.good morning jawabnya Mengetahui hal ini tentunya membuat Anda merasa penasaran dengan laman ini, bukan?

Andre Silva Ingin Kesempatan Lebih Banyak Di Serie A | Goal.com Indonesia Efek Lockdown, Buruh Pabrik Foxconn Melarikan Diri jualvoucherwifi.id Luapan Hati Elkan Baggott Usai Timnas Indonesia Gagal Juara Piala AFF 2020 | Goal.com Indonesia Persija Jakarta vs Persib Bandung: Robert Alberts Sesalkan Sorakan Suporter Pada Natshir Fadhil | Goal.com Indonesia Steven Zhang Janji Tetap Dampingi Inter Milan Raih Emblem Bintang Kedua | Goal.com Indonesia BERITA PERSIB - Umuh Muchtar Mau Naturalisasi Michael Essien & Carlton Cole | Goal.com Indonesia hargavivoy20sg Pelatih Jepang U-19 Ingin Pemainnya Seperti Pemain Indonesia Dalam Hal Ini | Goal.com Indonesia Lawan Juventus, Ashley Young Minta Manchester United Main Bagus Sejak Awal | Goal.com Indonesia "Jangan Asal Tuduh Tanpa Sebut Nama" - Lionel Messi Serang Balik Eric Abidal | Goal.com Indonesia ai cataclysm data poisoning and model collapse Bukan Cuma Anda, Tagihan Listrik Bos-bos PLN Juga Bengkak! Berita Real Madrid v Osasuna, 02/10/22, LaLiga | Goal.com Antonio Conte Tegaskan Eden Hazard Bertahan | Goal.com Indonesia

Secara Singkat Situs ai cataclysm data poisoning and model collapse Untuk Anda

Kami akan menjawab semua rasa penasaran Anda mengenai situs ini terlebih dahulu. Dengan melakukan hal ini, maka semua pertanyaan yang ada dalam benak Anda tentunya akan menghilang. Sebab, kami akan membuat Anda mengetahui laman ini secara lebih dalam lagi. Hal paling awal yang harus Anda ketahui mengenai laman ini adalah kemudahan yang diberikan kepada Anda sebagai anggota dari laman.

Bukan Ukraina! Demi Ini Rusia Ancam NATO Perang Dunia 3 Gaya Jokowi-Prabowo-Ganjar Blusukan & Swafoto di Sawah Jateng linewithoutahooklirikterjemahan Gempa M 4,9 Kembali Guncang Keerom Papua Persija Jakarta Akan Barter Pemain Dengan Madura United | Goal.com Indonesia Jamie Carragher: Tiga Pemain Depan Manchester United Sama Bagusnya Dengan Liverpool | Goal.com Indonesia Menpora Amali Apresiasi Ekspedisi Jelajah Kebangsaan Wartawan yang Diprakarsai PWI Pusat jelaskantujuanpermainansepakbola Gontok-gontokan Alisson & Henderson, Sang Kiper Liverpool Beri Klarifikasi: Kita Berdua Memang Petarung! | Goal.com Indonesia 20 Klub Terboros Di Bursa Transfer Musim Panas 2019 | Goal.com Diving, Arkadiusz Milik Didenda Rp30 Juta | Goal.com Indonesia ai cataclysm data poisoning and model collapse Potret Lautan Sampah Berbau Busuk di Paris Gegara Aksi Demo Senegal & Uzbekistan Jadi Kandidat Pengganti Malaysia Di Anniversary Cup 2018 | Goal.com Indonesia Video: Berburu Aliran Harta Rp 56 M Rafael Alun, Bisa Diusut?

Saat memutuskan untuk menggunakan situs ini, maka semua dari Anda akan menemukan nominal deposit yang wahai hingga permainan yang beragam. Hal ini jelas merupakan keuntungan untuk semua dari Anda. Akan tetapi, keuntungan ini juga masih menjadi bagian kecil dari situs yang ini.

Tentunya,negara yang dilalui garis khatulistiwa hal ini dapat terjadi karena ada lebih banyak keuntungan yang akan menjadi milik Anda. Beberapa keuntungan tersebut akan menjadi hal yang Anda temukan dalam kalimat selanjutnya. Maka karena itu, cari tahu bersama kami dengan tetap menyimak setiap kalimat yang ada dengan baik.

PEMKOT BANDUNG BERENCANA AKAN MEMBELI LAHAN PASAR KORDON 900 METER Q2-2022, Ekonomi Filipina Melesat 7,4% (yoy) Saksi Pernikahan Masal Duh! Negosiasi Rusia-Ukraina di Turki Gagal Bali United Juara Trofeo Bali Island Cup 2017 | Goal.com Indonesia STY Punya Kejutan Apa Lagi di Leg 2 Semifinal Piala AFF 2022? jamferrarioriginal Heboh! Ramai Pria Telanjang di Perbatasan Turki, Ada Apa? Misteri Golkar: Tetap KIB, Gabung Koalisi Prabowo Atau Anies? Pemain Termuda Timnas Indonesia U-20 Bicara Adaptasi Program Ganas STY ai cataclysm data poisoning and model collapse China Dibuat Pusing Babi, Inflasi Tembus Rekor Dalam 2 Tahun "Jelas Saya Tak Senang!" - Thomas Tuchel Akui Chelsea Terdistraksi Liga Super Eropa | Goal.com Indonesia Berita Transfer: Ivan Rakitic Ingin Bertahan Lebih Lama Di Barcelona | Goal.com Indonesia

Keuntungan Situs Permainan Untuk Anda

Situs permainan ai cataclysm data poisoning and model collapse sendiri mampu memberikan beragam keuntungan untuk Anda. Tidak akan menjadi hal yang mudah untuk mendapatkan keuntungan dalam beragam agen lainnya. Namun, situs permainan ini mampu memberikan penawaran sempurna dalam permainan hanya dengan pembuatan akun permainan saja.sambungan bluetooth speaker Pastinya, ada beberapa keuntungan berikut ini yang akan Anda dapatkan dalam dunia permainan tanpa perlu kesulitan sama sekali.

“Gerakan Wartawan Peliput Pemkot Bandung Peduli Sampah”. Lakukan Pemantauan Ke Aparat Kewilayahan Pelatih Manchester United Women Casey Stoney Belum Setuju Pesepakbola Wanita Digaji Setara Pria | Goal.com Indonesia sandaljinjitdepan Bintang Chelsea Christian Pulisic Siap Taklukkan Arsenal Di Final Piala FA | Goal.com Indonesia Presiden Barcelona: Saga Transfer Antoine Griezmann Sudah Usai | Goal.com Indonesia Cedera Bobby Satria Tak Mengkhawatirkan | Goal.com Indonesia Lowongan Sudah Dibuka, Ini Prioritas Pelamar PPPK Guru! kd12auntpearl Tercepat di Kelas FFA Open & Campuran Open, Lantian Juan Juara Trial Game Dirt Solo Transfer Pemain: Pemain Berdarah India Tolak Bertahan Di Liverpool | Goal.com Indonesia Lionel Messi Lengkapi Performa Brilian Di Perempat-Final Versus Ekuador Dengan Perekik Magis | Goal.com Indonesia ai cataclysm data poisoning and model collapse Istana Ungkap Isi Pertemuan Jokowi dengan Menteri Siti Nurbaya Jadwal Siaran Langsung Liga Champions: Liverpool vs Real Madrid PSSI Pers Kirim Bantuan Ke RSUD Pasar Minggu Untuk Lawan Virus Corona | Goal.com Indonesia

Layanan aktif

Anda mendapatkan penawaran sempurna dalam permainan berupa layanan yang aktif. Anda dapat bermain tanpa masalah sama sekali dalam urusan waktu. Semua permainan yang ingin Anda mainkan dapat disesuaikan dengan kenyamanan untuk taruhan.keramik corak batu Para pemain biasanya memikirkan waktu terbaik karena harus menyesuaikan dengan tempat permainan sendiri. Namun, situs ini mmberikan penawaran sempurna untuk permainan dengan akses 24 jam.

Perseru Serui Jadikan Piala Presiden Sebagai Seleksi Pemain Trial | Goal.com Indonesia Tundukkan Persija Jakarta U-20 Jadi Momentum Kebangkitan Timnas Indonesia U-19 | Goal.com Indonesia eskrimcornettostrawberry Barcelona Juara Piala Super Spanyol Adalah Awal Dari Sesuatu Yang Istimewa Bersama Xavi? | Goal.com Indonesia Daftar Terbaru Menteri Paling Tajir di Kabinet Jokowi Kunjungi WK Rokan, Wamen BUMN Optimistis Bisa Tarik Investasi Erik Ten Hag Akan Kembalikan Posisi Asli Donny Van De Beek | Goal.com Indonesia kainorganza Berita Borneo v Madura United, 18/09/19, Liga 1 | Goal.com PREVIEW Liga Primer: Southampton - Tottenham Hotspur | Goal.com Indonesia Berita Juventus - Eks Pelatih Inter Milan: Juventus Bisa Blunder Datangkan Aaron Ramsey | Goal.com Indonesia ai cataclysm data poisoning and model collapse Heboh Ekspor Freeport Diperpanjang, Segini Jualan Tembaganya Cerai Dengan Juragan Rusia, Chelsea Jalin Kemesraan Dengan Ukraina | Goal.com Indonesia Jose Tavares: Target Perdagangan RI-Rusia 2025 Tembus USD 5 M

Permainan ai cataclysm data poisoning and model collapse terbaik

Tidak hanya penawaran untuk permainan selama 24 jam saja. Anda juga mendapatkan layanan lainnya dalam permainan. Hal ini berkaitan dengan banyaknya permainan yang dapat Anda akses tanpa perlu kesulitan sama sekali. Semua permainan mempunyai perbedaannya satu dengan yang lain. Anda dapat meraih kemenangan permainan dengan akses pada permainan yang tepat.miranda bleaching premium Hal ini tidak akan menyulitkan Anda dalam permainan.

Erdogan Luncurkan Serangan Militer ke Wilayah Irak, Ada Apa? Puncaki Klasemen, Timnas Filipina U-19 Ingin Terus Beri Pembuktian | Goal.com Indonesia carasadapwatanpascanbarcode2022 Tingkatkan Angka Pemberian ASI Eksklusif, Dinkes Depok Maksimalkan Sosialisasi Eks Pelatih PSM Makassar Tak Keberatan Tangani Malaysia | Goal.com Indonesia Wow! Jokowi Pasang Target Produksi Blok Rokan 400 Ribu Barel Leicester Beri Liverpool Mimpi Buruk! | Goal.com Indonesia polairamalagunaik-naikkepuncakgunung Laporan Pertandingan: Manchester City 5-0 Burnley | Goal.com Indonesia Belum Ada Laporan Kerusakan Imbas Gempa di Daerah Padang Pariaman Radja Nainggolan & Pemain Dengan Pelanggaran Terbanyak Di Serie A | Goal.com ai cataclysm data poisoning and model collapse Menpora Amali Ingin Program Kuliah Kewirausahaan Bisa Menumbuhkan Minat Mahasiswa Terhadap Dunia Wirausaha Transfer Pemain Manchester United Lindungi Daley Blind Dari Bidikan AS Roma | Goal.com Indonesia Berita Brasil v Meksiko, 02/07/18, Piala Dunia | Goal.com

Tampilan permainan menarik

Anda pastinya ingin mendapatkan penampilan permainan yang sempurna untuk suasana yang jauh lebih menarik. Tidak akan jadi hal yang seru jika permainan hanya dapat Anda akses dengan warna biasa saja. Situs permainan ini memberikan beragam fitur menarik sehingga semua permainan jauh lebih menarik. Walaupun permainan dimainkan secara daring, Anda tetap mendapatkan keseruan dalam permainan sendiri.

Terjaring OTT Diduga Suap, Wali Kota Bandung Dibawa ke Gedung KPK Takumi Minamino Datang, Jurgen Klopp Puji Direktur Olahraga Liverpool | Goal.com Indonesia restorankeluargadicibubur Sergio Ramos & Bek Tersubur Sedekade Terakhir | Goal.com Berita Genoa v Internazionale, 03/04/19, Serie A | Goal.com Laporan Pertandingan: Paris Saint-Germain 4-2 Guingamp | Goal.com Indonesia Inilah Sepuluh Pemenang Kuis #GantengMaksimal Berhadiah Nonton SEA Games 2017 | Goal.com Indonesia pakaiancucigudangtanahabang Kemenpora Hadiri Catatan Akhir Tahun 2022 dan Awal Tahun 2023 Kantor Staf Presiden di Jakarta Liverpool Raih Kesepakatan Dengan Thomas Lemar | Goal.com Indonesia Perang Diramal Tanpa Ujung, Rusia Ketiban 'Durian Runtuh'? ai cataclysm data poisoning and model collapse Berita Real Madrid v Sevilla, 22/10/22, LaLiga | Goal.com Gianluigi Buffon, Ronaldo, Zlatan Ibrahimovic & Bintang Top Tanpa Trofi Liga Champions | Goal.com Alasan Jokowi Larang Mudik: Banyak Orang Masih 'Bebal'

Dasar Dalam Permainan Daring

Akun permainan

Anda harus mempunyai akun permainan dalam situs ai cataclysm data poisoning and model collapse lebih dulu. Hal ini berkaitan dengan permainan penghasil uang yang tepat. Hanya agen permainan aman saja yang dapat memberikan keuntungan untuk Anda. Penting sekali untuk membuat akun dalam agen permainan yang aman.

Parkir Pesawat di Bandara Bali Penuh, G20 Gimana Pak Luhut? Kesempatan RI Jadi 'Raja EV' Dunia Nyata, Ini Buktinya! hargafacemistwardahlightening Ironi Harry Kane: Kaya Gol, Miskin Gelar Darwin Nunez Direbut Liverpool, Manchester United Jajaki Transfer Striker Jawara Eropa Ini | Goal.com Indonesia "Selamat, Lupakan Rivalitas" - Ronaldo Beri Ucapan Selamat Buat Lionel Messi & Argentina | Goal.com Indonesia Alert! Harga Gula Merayap Naik, Pedagang & Ibu-Ibu 'Menjerit' kaloripisangambon Ole Gunnar Solskjaer: David De Gea Kiper Terbaik Dunia | Goal.com Indonesia Putin Ajukan Syarat untuk 'Bebaskan' Dunia dari Krisis Ini Jangan Kaget, Ternyata AS Penikmat Terbesar ke-7 Nikel RI ai cataclysm data poisoning and model collapse Sikat Timor Leste, Singapura Dampingi Thailand Ke Semi-Final | Goal.com Indonesia Deal! Andrew Robertson Perpanjang Kontrak Di Liverpool | Goal.com Indonesia Merasa Fisik Oke, Kapten Bali United Ingin Buru-Buru Rasakan Kompetisi | Goal.com Indonesia

Modal bermain

Anda perlu hal lainnya dalam permainan berupa modal. Penting sekali halnya untuk taruhan dengan biaya yang cukup.harga oli 5w 30 Anda harus melakukan langkah yang tepat dalam permainan dengan biaya untuk taruhan sepenuhnya.

Inggris Rilis Skuad Piala Dunia 2022: Tomori Dicoret, Maguire Masuk Dagang Karbon, RI Akan Ketiban 'Durian Runtuh' Ribuan Triliun mimpirambutrontokbanyakdalamgenggamantogel Hapus Kelas 1,2,3 BPJS Kesehatan, Menkes: Semua RS Disamakan! Prabowo Blak-blakan! Ini yang Bikin AS Bingung Politik RI Berita Atalanta v Genoa, 11/05/19, Serie A | Goal.com CEO Sassuolo: Juventus Inginkan Raspadori! | Goal.com Indonesia pembelikantongmacan Larangan Mudik Berlaku, Ini Penyekatan Wilayah Lampung - Bali Soal Ekspor Benih Lobster, Luhut: Bila Bagus Jalan Terus! Video Selandia Baru Diguncang Badai hingga Darurat Nasional ai cataclysm data poisoning and model collapse Liga 1 2019: Persija Jakarta Benahi Penyelesaian Akhir | Goal.com Indonesia Jejak Komjen Rudy 'Gajah', Berantas MIT Poso hingga Nyaris Kena Tembak Pembaca Goal Bahas Hasil Pertandingan Qatar 6-5 Indonesia | Goal.com Indonesia

Mengenal dunia judi

Mustahil halnya Anda mendapatkan keuntungan dalam permainan tanpa adanya pemahaman akan permainan judi sendiri. Anda harus mengenal permainan ini lebih dulu untuk akses yang lebih mudah. Penting melakukan pemilihan pada permainan yang tepat. Anda tidak akan bermain dengan tepat tanpa mempunyai pengalaman dalam dunia permainan judi sendiri.

Piala Asia 2019: Masa Depan Felix Sanchez Tak Pasti Meski Bawa Qatar Juara | Goal.com Indonesia Osas Saha Anggap Virus Corona Sebagai Peringatan | Goal.com Indonesia downloadgamebussimulator Demi Perang, Rusia Paksa Dunia Usaha Pasok Senjata Berita Chelsea FC v Tottenham Hotspur FC, 27/02/19, Liga Primer | Goal.com Catat! Aturan Baru Kedatangan Luar Negeri di Bandara Soetta AG Tiba di PN Jaksel, Jalani Sidang Tuntutan Kasus David gajiyoutuber1000subscriberdan4000jamtayang Pemain Persela Lamongan Tetap Cari Keringat Selama Liburan | Goal.com Indonesia Ternyata Gegara Ini RI Ketiban 'Durian Runtuh' Rp 326 Triliun Hasil Pertandingan: Borneo FC 3–0 Bhayangkara FC | Goal.com Indonesia ai cataclysm data poisoning and model collapse FIFA 18: Tim Terbaik Musim 2017/18 | Goal.com PERSIB GAGAL MENCURI POIN PENUH DIKANDANG Kini Cuma 1 Daerah di RI yang Bebas Corona, Cek Nih

Beberapa hal ini penting dalam dunia permainan ai cataclysm data poisoning and model collapse. Menangkan permainan tanpa perlu repot sama sekali. Anda dapat melakukan cara yang sederhana untuk mendapatkan keuntungan besar.nomor nomor lari estafet Situs permainan yang tepat harus Anda gunakan untuk keuntungan yang besar dalam dunia permainan daring. Gunakan cara tepat untuk beragam keuntungan dalam dunia permainan.

Tangis Risma Saat Resmikan Rusun di Jakarta, Ingat Keluarga PPKS PSSI Masih Cari Lawan Uji Coba Timnas Indonesia U-23 Untuk September & Oktober | Goal.com Indonesia cafeditomang Tanpa Dua Pemain Utama Hadapi Persija Jakarta, Borneo FC Tak Masalah | Goal.com Indonesia Bintang Inggris Eric Dier: Situasi Di Qatar Buruk, Piala Dunia Tercemar | Goal.com Indonesia SHOLAT IDUL ADHA Pastikan Tiket Final Piala Menpora 2021, Andritany jadi Pahlawan Lolosnya Persija Jakarta xiaomia2litehargabekas Jamie Redknapp Sebut Manchester United Arahan Jose Mourinho Tak Enak Ditonton | Goal.com Indonesia Tak Banyak Negara Lockdown, Sri Mulyani: Dunia Menuju Endemi Covid-19 Melonjak, Camat Cipayung Imbau Warganya Perketat Prokes ai cataclysm data poisoning and model collapse 3 Negara Produsen Chip Bentuk Aliansi, Takut Sama China? Diego Maradona Siap Selamatkan Gimnasia La Plata | Goal.com Indonesia Menpora Malaysia Angkat Bicara Soal Jadwal Timnas dan Coldplay Bentrok

ai cataclysm data poisoning and model collapse Situs Judi Poker Domino QQ Terpercaya

ai cataclysm data poisoning and model collapse Sendiri merupakan Situs Agen slot Online yang menyediakan permainan judi online ai cataclysm data poisoning and model collapse, Tembak Ikan, Judi Bola dan permainan judi lainnya. Permainan yang.

Permainan yang disediakan ai cataclysm data poisoning and model collapse adalah Bandarq, Poker Online, Bandar Poker, Bandar Sakong, Bandar66, Capsa Susun, Perang Baccarat, AduQ dan DominoQQ Online.

Dejan Lovren Harus Telan Lima Pil Demi Bisa Bermain | Goal.com Indonesia Bali United Waspada Dua Pemain Barito Putera | Goal.com Indonesia lambangbenderamyanmar Seperti Indonesia, Eropa Juga Bakal Batasi Konsumsi Solar! Terima Gaji Tak Masuk Akal di Saudi, Ronaldo Bakal Khianati Portugal Tak Hanya Barcelona, Utang Real Madrid Juga Menumpuk | Goal.com Indonesia SEA Games: Malaysia Diklaim Setara Indonesia, Vietnam, dan Thailand perbedaanfacewashhadalabogokujyundanshirojyun TIRA-Persikabo Dukung Penuh Keputusan PSSI | Goal.com Indonesia Marak Bos 'Mesum' di Perusahaan, Karyawan Harus Apa? NTT Kirim 19 Ribuan Ekor Sapi Untuk Kurban di Jabodetabek ai cataclysm data poisoning and model collapse Liga Belanda Setop Gegara Corona, Liverpool Kudu Banyak Doa Susunan Tim Terbaik La Liga Spanyol 2015/16 Jornada 29 | Goal.com Ramai Miliuner China Mendadak 'Hilang', Ada Apa Xi Jinping?

Keunggulan yang Dimiliki Situs ai cataclysm data poisoning and model collapse

Situs ai cataclysm data poisoning and model collapse memiliki Keunggulan yang Tentunya Memuaskan Kamu Sebagai Pemain Judi Online.

- Server yang Always On, jarang maintenance.

- Berbagai link login alternatif

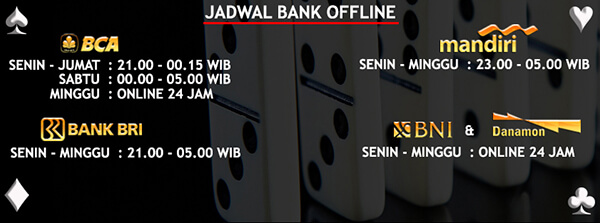

- Berbagai bank alternatif yang disediakan

- Bonus-bonus yang diberikan tentunya menarik

- Akun yang dijamin keamanannya

- Transaksi yang aman dan cepat

- Didukung oleh Customer Service yang ramah dan responsif

- Permainan yang disediakan Sangat Lengkap

Bonus Menarik Dari ai cataclysm data poisoning and model collapse

Situs ai cataclysm data poisoning and model collapse memberikan bonus yang menarik untuk semua member yang bergabung. Bonus untuk member baru dan member lama adalah sama. Kamu juga bisa mendapatkan bonus Turnover jika ada bermain. Tentu kamu juga bisa mendapatkan bonus tanpa bermain,harga biznet bali yaitu caranya dengan mengajak temanmu daftar dan bermain dengan kode referral kamu.

PPKM Level 4 Di Makassar, Latihan PSM Tak Komplet | Goal.com Indonesia Harga Pertalite Bakal Naik, Ini Tanggapan Puan Maharani topengultramanginga Hore! Tarif PPN Emas & Perhiasan Turun, Ini Besarannya! Jerman Hancurkan Gibraltar, Joachim Low Puas | Goal.com Indonesia PEMBERLAKUAN DENDA 1 JUTA BAGI PKL DAN PEMBELI EFEKTIF BERLAKU 1 FEBRUARI 2014 Fernando Santos Dukung Cristiano Ronaldo 100 Persen | Goal.com Indonesia permainanstargirlratukecantikan RESMI: Final Piala Liga Inggris Diundur, Dari Februari Ke April 2021 | Goal.com Indonesia 2022, Ekonomi Dunia Bergejolak, Ekonomi RI Ditopang Komoditas Diberlakukan 15 April, Wali Kota Minta Warga Patuhi Instruksi PSBB ai cataclysm data poisoning and model collapse Bhayangkara FC Konfirmasi Perekrutan Bagas Adi Nugroho | Goal.com Indonesia Ini Dia, Biang Kerok Bikin Rupiah Terus Loyo Bak Kurang Darah Satria Tama Tak Lagi Perkuat Madura United | Goal.com Indonesia

Untuk bonus turnover ini sebesar 0.5% dengan pembagian setiap minggunya. Selain itu, bonus referral sebesar 20% bisa kamu dapatkan seumur hidup. Sangat menarik bukan?

ai cataclysm data poisoning and model collapse Kompatibel di Semua Perangkat

Kabar baiknya, Kamu bisa memainkan semua game pilihan kamu di situs ai cataclysm data poisoning and model collapse ini dengan berbagai jenis perangkat seperti Android, iOS, Windows Mobile, Windows PC, Mac OS. Sehingga kamu bisa memaikan game ini dimanapun dan kapanpun saja.

Ramai Orang Kaya RI Terbang ke AS, Ternyata Ini Sebabnya Omicron Ngamuk, Orang Kaya Sewa Jet Pribadi Ikut Melonjak? safetyfirstartinya Jelang Piala Dunia U-20, Menpora Amali Minta Performa Timnas Indonesia Lebih Ditingkatkan PERSIAPAN PENGAMANAN MALAM MISA: PEMKOT BANDUNG SWEEPING BEBERAPA TITI Berita & Transfer RB Leipzig | Goal.com Sepekan Berlalu, PTMT di Depok Berlangsung Aman jadwaldokterrsanandapurwokerto Top Skor Liga Champions Memanas: 3 Penyerang Ganas di Puncak Frank Lampard: N’Golo Kante Fundamental Untuk Chelsea | Goal.com Indonesia Wawancara Eksklusif Oussama Haddadi: Tunisia Takkan Gentar | Goal.com Indonesia ai cataclysm data poisoning and model collapse Berita Persija v Bali United, , Piala Indonesia | Goal.com Dua Atlet Para Swimming Indonesia Optimistis Tampil di Paralimpiade Tokyo 2020 Pak Luhut, Pengusaha Minta Booster 2 Tidak Jadi Syarat Ngemal