berts attention mechanism revealed | Agen Slot Online Gampang Maxwin x500 Tahun 2025 rupython

Yuk, Intip Lebih Dalam Situs berts attention mechanism revealed Yang Berkualitas

Jokowi Minta Ekspor Bauksit Disetop di 2022, Kapan Tepatnya? Diberi Motivasi Di Ruang Ganti Jadi Sebab Bhayangkara FC Menang | Goal.com Indonesia ispitonyourgrave Dirut BNI Raih Penghargaan The Best CEO with Distinction 2022 - Berita | BNI Jreng! Jepang Buat Marah China-Korsel, Bawa Perang Dunia GALERI: Prancis Runtuhkan Keperkasaan Jerman | Goal.com Sengkarut Nasib Trent! Alexander-Arnold Masih Jadi Pilar Liverpool Meski Dicoret Timnas Inggris | Goal.com Indonesia persamaankatakerabat GOAL 25 2018: #13 Hamka Hamzah | Goal.com Indonesia Jurgen Klopp: Komitmen Pemain Afrika Tak Seperti Orang Eropa | Goal.com Indonesia Ekspor Mau Disetop, Pengusaha Timah Curhat Begini berts attention mechanism revealed RESMI: Manchester United Datangkan Lisandro Martinez Dari Ajax, Arsenal Gigit Jari | Goal.com Indonesia Berita PSG: Kylian Mbappe Kaget Dengan Perputaran Uang Industri Sepakbola | Goal.com Indonesia Berita EPL - Rio Ferdinand Dukung Tammy Abraham Cetak Banyak Gol Untuk Chelsea | Goal.com Indonesia

Yuk, Intip Lebih Dalam Situs berts attention mechanism revealed Yang Berkualitas! Bermain tentunya menjadi salah satu kegiatan dari sedikitnya kegiatan menyenangkan yang dapat Anda lakukan. Jelas saja,berts attention mechanism revealed berbeda dengan bekerja, saat bermain semua beban yang ada dalam benak Anda akan menghilang. Maka karena itu, menjadi hal yang sangat wajar bila saat ini semua dari Anda dapat menemukan aplikasi permainan di ponsel dengan mudah.

Berita Juventus - Manchester United Segera Dapatkan Mario Mandzukic? | Goal.com Indonesia Yaya Toure Ogah Ke Tiongkok Demi Uang | Goal.com Indonesia megapenyimpanan FC Porto 0-2 Chelsea: Satu Kaki The Blues Di Semi-Final | Goal.com Indonesia Ada Jakarta, Ini 5 Provinsi dengan Kasus Covid-19 Terbanyak Bupati Purwakarta Segel Bangunan Ilegal Jadi Tempat Ibadah GKPS Pencucian Uang! Afiliator Investasi Bodong Bakal Dimiskinkan pengeluaranhongkongharijumat Kemenkes Prediksi Tak Ada Lonjakan Covid Usai Lebaran Tahun Ini Kunker ke Depok, Pemkab Batang Pelajari Empat Hal Prabowo Temui JK di Rumah Brawijaya Jaksel, Ada Iwan Bule berts attention mechanism revealed Bhayangkara FC Waspadai Topskor Liga 1 2019 | Goal.com Indonesia "Pertahanan Aneh!" - James Milner & Virgil Van Dijk Kelahi Usai Gol Pertama Manchester United Ke Gawang Liverpool, Ada Apa? | Goal.com Indonesia Leonardo Bonucci Senang Tim Nasional Italia Mulai Tunjukkan Hasil Regenerasi | Goal.com Indonesia

Akan tetapi, selain menggunakan aplikasi, ada hal lain yang dapat Anda gunakan untuk bermain. Hal tersebut adalah jelajah internet yang masih menjadi bagian dari ponsel Anda. Dengan menggunakan jelajah internet ini, ada banyak permainan menarik yang dapat Anda temukan pula. Salah satunya adalah permainan yang telah menjadi incaran masyarakat luas sejak zaman dahulu.dangdut terbaru 2022 Bahkan, beberapa dari Anda juga mungkin akan memilih permainan ini.

Benar sekali, hal ini dikarenakan hadiah kemenangan yang diberikan oleh permainan yang ada dalam situs ini adalah uang. Tepat sekali, judi menjadi nama lain dari permainan yang saat ini dapat Anda mainkan dalam situs dengan nama berts attention mechanism revealed ini. Kami menyarankan semua dari Anda untuk langsung mengunjungi situs yang kami sebut sebelumnya saja saat ingin bermain. Hal ini dikarenakan situs yang kami sebutkan merupakan laman yang aman.

Jose Mourinho: Kami Kembali Ke Liga Champions! | Goal.com Indonesia Wuzz.. Jet-jet Tempur NATO Bakal Wara-Wiri Dekat RI, Ada Apa? hasilzenit Kalah Dipertandingan Pertama, Pelatih Para Tenis Meja Apresiasi Permainan Komet dan Adyos KOTA BANDUNG AKSELERASI GELAR PTM, EMA MINTA VAKSIN UNTUK SISWA Ranking FIFA Indonesia Kini Sama Dengan Kamboja | Goal.com Indonesia PSM Makassar Imbang, Borneo FC Gagal Ke Puncak | Goal.com Indonesia lirikbigboy Berita Manchester United FC v Everton FC, 17/09/17, Liga Primer | Goal.com Bukan Pemerintah, Siapa yang Paling Banyak Ngutang ke China? Antonio Rudiger: Dari Kalah 6-0 Ke Adu Penalti, Chelsea Makin Baik | Goal.com Indonesia berts attention mechanism revealed Konsisten Pertahankan WTP, Ini yang Dilakukan BKD Kapan Real Madrid Bisa Klaim Gelar Juara La Liga Musim 2021/22? | Goal.com Indonesia Duo Clasico Real Madrid-Barcelona Terpesona Dengan Marcelo Brozovic | Goal.com Indonesia

Jelas saja, ada banyak keuntungan yang diberikan oleh laman ini dan tidak hanya berlaku untuk pemenang. Benar, hal ini dikarenakan keuntungan ini berlaku untuk semua dari Anda yang menjadi anggota dari situs ini. Lebih tepatnya, keuntungan ini dapat Anda peroleh dari banyaknya pelayanan terbaik yang biasanya tidak diberikan laman lain.ug dewa Mengetahui hal ini tentunya membuat Anda merasa penasaran dengan laman ini, bukan?

Beberapa Asprov PSSI Belum Mampu Bertugas Dengan Baik | Goal.com Indonesia Zah Rahan Krangar Patok Target Tiga Besar Bersama Madura United | Goal.com Indonesia qq66slot Berita & Transfer Mainz 05 | Goal.com Setelah Drama Deadline Day, Julian Araujo Akhirnya Gabung Barcelona! | Goal.com Indonesia Video: Krisis Energi Eropa Makin Serius, Warga Borong Obor Warga Cipas Diajak Kerja Bakti Antisipasi Musim Penghujan slotwajik777 Mahal Gila! Lukisan Picasso Terjual Seharga Rp 1,5 T W20 UMKM Expo: Strategi Pemulihan Ekonomi Perempuan dan UMKM Penggerak Organda Depok Ciptakan Prototipe Angkot AC Berbasis Online berts attention mechanism revealed Berita Transfer Liverpool, Samuel Etoo Minta Mohamed Salah Gabung Barcelona | Goal.com Indonesia Ini Rangkaian HUT PMI Kota Depok Pendataan Awal Regsosek, BPS Depok Terjunkan 3000 Petugas Survei

Secara Singkat Situs berts attention mechanism revealed Untuk Anda

Kami akan menjawab semua rasa penasaran Anda mengenai situs ini terlebih dahulu. Dengan melakukan hal ini, maka semua pertanyaan yang ada dalam benak Anda tentunya akan menghilang. Sebab, kami akan membuat Anda mengetahui laman ini secara lebih dalam lagi. Hal paling awal yang harus Anda ketahui mengenai laman ini adalah kemudahan yang diberikan kepada Anda sebagai anggota dari laman.

Ada Bocoran Jokowi Mau Ketemu Investor Kakap AS di Dubai Sekutu Putin Sebut AS Pewaris Nazi dan Tukang Tipu nada4d Timnas Indonesia Banyak Buang Peluang, Pemain Juga Kesal PDIP soal Gibran Bertemu Prabowo: Yang Penting Dia Tunduk ke Partai Tiga Pemain Asing Borneo FC Tiba Pekan Ini | Goal.com Indonesia Video: Penjualan Moncer, Mobil Asing Ngiler Serbu Indonesia natsumeyuujinchou Tata Martino, Eks Pelatih Argentina Berpotensi Singkirkan Messi Dkk Siapa Lawan Barcelona Di Babak Gugur Liga Europa? Ini Kandidatnya | Goal.com Indonesia Dinkes Gelar Pertemuan Evaluasi Kampung Peduli Tuberkulosis berts attention mechanism revealed Kena Kasus di Taiwan, Ternyata Indomie Lokal vs Ekspor Beda Bintang Denmark Christian Eriksen: Saya Ingin Tampil Di Piala Dunia 2022! | Goal.com Indonesia Eropa Terpecah, 11 Negara Sepakat Perkuat Kerja Sama Nuklir

Saat memutuskan untuk menggunakan situs ini, maka semua dari Anda akan menemukan nominal deposit yang wahai hingga permainan yang beragam. Hal ini jelas merupakan keuntungan untuk semua dari Anda. Akan tetapi, keuntungan ini juga masih menjadi bagian kecil dari situs yang ini.

Tentunya,erek erek 056 hal ini dapat terjadi karena ada lebih banyak keuntungan yang akan menjadi milik Anda. Beberapa keuntungan tersebut akan menjadi hal yang Anda temukan dalam kalimat selanjutnya. Maka karena itu, cari tahu bersama kami dengan tetap menyimak setiap kalimat yang ada dengan baik.

Antonio Conte Tantang Komitmen David Luiz? | Goal.com Indonesia Berita EPL - Jesse Lingard Disebut Bakal Pakai No. 7 Manchester United, Louis Saha Tak Setuju | Goal.com Indonesia Tahun Depan, Kelurahan Pangkalan Jati Prioritaskan Pembuatan Turap dan Perbaikan Jalan Jelang G20, Luhut Resmikan PLTS Terapung Milik PLN di Bali Jokowi Makin Ngebut, Proyek-Proyek Ini Wajib Kelar 2024 Heboh Virus Misterius di Nigeria, 104 Terinfeksi & 15 Tewas agentembakikan Piala Dunia 2018: Jesse Lingard Yakin Inggris Juara | Goal.com Indonesia Berita Inter Milan: Luciano Spalletti Yakin Pemain Barcelona Profesional | Goal.com Indonesia Tahun Ajaran Baru, Insan Pendidikan Diminta Patuhi Pembelajaran Jarak Jauh berts attention mechanism revealed Sansan Fauzi Berharap Dapat Menit Bermain Lebih Banyak | Goal.com Indonesia Berita UCL - Toni Kroos: Ajax Tim Yang Lebih Baik Selama Dua Pertemuan | Goal.com Indonesia Pertamina Dorong Pertumbuhan UMKM di Bali Lewat Rumah BUMN

Keuntungan Situs Permainan Untuk Anda

Situs permainan berts attention mechanism revealed sendiri mampu memberikan beragam keuntungan untuk Anda. Tidak akan menjadi hal yang mudah untuk mendapatkan keuntungan dalam beragam agen lainnya. Namun, situs permainan ini mampu memberikan penawaran sempurna dalam permainan hanya dengan pembuatan akun permainan saja.latto latto kayu Pastinya, ada beberapa keuntungan berikut ini yang akan Anda dapatkan dalam dunia permainan tanpa perlu kesulitan sama sekali.

Israel Superior di Piala Dunia U-20 Usai Ditolak di Indonesia Bali United Vs Kedah Darul Aman: Live Streaming & TV, Prediksi, Susunan Pemain Dan Kabar Terkini | Goal.com Indonesia instagramdownloadpicture Inilah Sejarah Arsenal: Definisi Tim Yang Hobi Bikin Fansnya SAKIT TAPI TAK BERDARAH! | Goal.com Indonesia Mauro Icardi Banyak Belajar Dari Akademi Barcelona | Goal.com Indonesia Berita Bayern Munich: Niko Kovac Balas Kritik Rafinha | Goal.com Indonesia Tottenham Hotspur Hampir Rampungkan Transfer Gelandang Southampton Pierre-Emile Hojbjerg | Goal.com Indonesia daftarlagurosa Berita Serie A: Fiorentina Ikhlas Tiket Liga Europa Kembali Diambil AC Milan | Goal.com Indonesia Berita Maccabi Haifa v Maccabi Tel Aviv, 03/01/22, Ligat Ha'al | Goal.com BERITA TIMNAS INDONESIA U-19 - Setelah Rivaldo Ferre, Indra Sjafri Sebut Pemain Lain Siap Bikin Kejutan | Goal.com Indonesia berts attention mechanism revealed Pimpin Sertijab, Kapolri Wanti-wanti soal Gaya Hidup Mewah Pejabat Seri Lawan Elche, Carlo Ancelotti Masih Pede Real Madrid Juara LaLiga | Goal.com Indonesia Eka Ramdani Prioritaskan Persela Lamongan | Goal.com Indonesia

Layanan aktif

Anda mendapatkan penawaran sempurna dalam permainan berupa layanan yang aktif. Anda dapat bermain tanpa masalah sama sekali dalam urusan waktu. Semua permainan yang ingin Anda mainkan dapat disesuaikan dengan kenyamanan untuk taruhan.erek erek beras Para pemain biasanya memikirkan waktu terbaik karena harus menyesuaikan dengan tempat permainan sendiri. Namun, situs ini mmberikan penawaran sempurna untuk permainan dengan akses 24 jam.

Berita Transfer - Demi Progres Karier, Jadon Sancho Diminta Bertahan Di Borussia Dortmund | Goal.com Indonesia Rafa Benitez Tak Sabar Hadapi Liverpool Musim Depan | Goal.com Indonesia liriklastchilddiarydepresiku Rating Pemain Real Madrid: Thibaut Courtois Menunjukkan Kelasnya, Tapi Karim Benzema Buntu Lagi | Goal.com Indonesia Laporan Pertandingan: Barito Putera 1-0 Persiba Balikpapan | Goal.com Indonesia Claude Puel Tak Tahu Klausul Pelepasan Harry Maguire | Goal.com Indonesia Ada Pembangunan JPO, Lalin di Jalan Margonda Raya Akan Direkayasa pantattembem RESMI: Bek Timnas Indonesia Elkan Baggott Gabung Gillingham FC | Goal.com Indonesia Kejadian Nyata Di Bundesliga 2, Jadi Cadangan Di Luar Lapangan Bisa Rugikan Tim | Goal.com Indonesia Pandemi Covid-19 di DKI Kian Mengganas, Luhut Telepon Anies berts attention mechanism revealed Bukan 'Penghancur' Avanza, Ini LCGC yang Paling Laku Keras Ricky Nelson Akui Masih Butuh Waktu Untuk Perbaiki Borneo FC | Goal.com Indonesia Persipura Jayapura Jamu Arema FC Di Stadion Aji Imbut | Goal.com Indonesia

Permainan berts attention mechanism revealed terbaik

Tidak hanya penawaran untuk permainan selama 24 jam saja. Anda juga mendapatkan layanan lainnya dalam permainan. Hal ini berkaitan dengan banyaknya permainan yang dapat Anda akses tanpa perlu kesulitan sama sekali. Semua permainan mempunyai perbedaannya satu dengan yang lain. Anda dapat meraih kemenangan permainan dengan akses pada permainan yang tepat.arti kids bahasa gaul Hal ini tidak akan menyulitkan Anda dalam permainan.

Pesepakbola Lebih Sering Dites Covid-19 Ketimbang Dokter? Menggelikan! | Goal.com Indonesia Ngeri! Efek Perang Ukraina RI Susah Impor Makanan idxbig Dua Perempuan Muda Indonesia Pimpin Tim U16 Berlaga di Barcelona Serangan Belum Reda, Roket Rusia Hantam Menara TV Ukraina Berita Transfer - Leicester City Rekrut Ayoze Perez dari Newcastle United | Goal.com Indonesia Liga 1 2019: Kalteng Putra Merasa Diuntungkan Dengan Absennya Tiga Pemain Andalan Persib Bandung | Goal.com Indonesia dandelionmakna Marko Šimić, Berita Terkini & Profil Pemain | Goal.com Reaksi Netizen Usai Harga Tiket Indonesia vs Argentina Diumumkan Ditawar Arsenal, Jamie Vardy Fokus Ke Euro 2016 | Goal.com Indonesia berts attention mechanism revealed Jejak Moncer Elektabilitas Ganjar yang Sempat Terusik Isu Tolak Israel BPS Gelar Sensus Penduduk Online 2020, Begini Tahapannya Dua Kandidat Pelatih Timnas Indonesia Akan Saksikan Langsung Laga Kontra Malaysia | Goal.com Indonesia

Tampilan permainan menarik

Anda pastinya ingin mendapatkan penampilan permainan yang sempurna untuk suasana yang jauh lebih menarik. Tidak akan jadi hal yang seru jika permainan hanya dapat Anda akses dengan warna biasa saja. Situs permainan ini memberikan beragam fitur menarik sehingga semua permainan jauh lebih menarik. Walaupun permainan dimainkan secara daring, Anda tetap mendapatkan keseruan dalam permainan sendiri.

Polisi Sebut Bahar bin Smith Baru Lapor Sehari usai Dugaan Penembakan Jokowi Tetapkan CPP, Petani Tagih Janji 9 Juta Hektar Lahan biayasekolahbiarawati Ngeri! Puluhan Mayat Terdampar di Pantai Italia, Ada Apa? Tangis Kecewa Pembeli Meikarta, Minta Refund Dikasih Surat "Fun Football Pada Serius, Giliran Laga Resmi Mainnya Lawak!" - Banyak Yang Kecewa Ronaldinho Tak Dikasih Bola Di Laga Trofeo | Goal.com Indonesia Heboh! Antusias Warga di Penukaran Tiket Allo Bank Festival liriksignofthetime 1 Juta Honorer Sudah Diangkat Jadi PNS, Sisanya Dipecat? Tekan Emisi, Pertamina Kembangkan Inisiatif Bisnis Hijau Nambah Lagi, Korban Tragedi Kanjuruhan Jadi 130 Orang berts attention mechanism revealed Tukin PNS Mau Dirombak, DPR: Naikkan Gaji Dulu! PNM Sabet Penghargaan Program Pemberdayaan UMKM Berita Tottenham Hotspur - Mauricio Pochettino Berharap Bisa Gunakan New White Hart Lane Pada Awal 2019 | Goal.com Indonesia

Dasar Dalam Permainan Daring

Akun permainan

Anda harus mempunyai akun permainan dalam situs berts attention mechanism revealed lebih dulu. Hal ini berkaitan dengan permainan penghasil uang yang tepat. Hanya agen permainan aman saja yang dapat memberikan keuntungan untuk Anda. Penting sekali untuk membuat akun dalam agen permainan yang aman.

Dibuka Wapres KH Ma’ruf Amin, Menpora Amali Pastikan Upacara Pembukaan Asean Para Games Solo 2022 Penuh Kejutan Pemain PSIS Semarang Tunjukkan Semangat Level Liga 1 | Goal.com Indonesia rtpharmonibethariini Inter Milan Rebut Tiket 16 Besar Liga Champions & Tendang Barcelona Ke Liga Europa Usai Bantai Viktoria Plzen | Goal.com Indonesia Petr Cech Anggap Ryan Mason Sebagai Inspirasi | Goal.com Indonesia Rating Pemain Manchester United Vs Newcastle: Casemiro Sang Big-Game Player! Pimpin Setan Merah Juara Piala Liga | Goal.com Indonesia Satu Suporter Meninggal Dunia Saat Tonton Persebaya vs Bali United gameterbaikdiroblox2022 Alert! Ada Omicron, Kasus Covid-19 Harian DKI Bisa 19.000 15 Tahun Berkiprah, CT ARSA Foundation Gelar Perayaan Virtual Indonesia Raih Sertifikasi Profesi Skema APO-GPS 201 berts attention mechanism revealed Hulk, Berita Terkini & Profil Pemain | Goal.com Jokowi Tetapkan CPP, Petani Tagih Janji 9 Juta Hektar Lahan Sedih! RI Ranking 85 dari 98 Negara dalam penanganan Pandemi

Modal bermain

Anda perlu hal lainnya dalam permainan berupa modal. Penting sekali halnya untuk taruhan dengan biaya yang cukup.lirik biar kerjaku begini Anda harus melakukan langkah yang tepat dalam permainan dengan biaya untuk taruhan sepenuhnya.

Jokowi Geram Rp 170 T Duit RI 'Menguap' Tiap Tahun, kok bisa? Seto Nurdiyantoro Anggap PSS Sleman Tidak Beruntung | Goal.com Indonesia jumlahtrofineymar Bukan Tesla! Mobil Listrik China Incar RI, Mini 'Alphard' Gawat Raja Salman, Amerika Diminta Hukum Arab Saudi! Kenapa? Hati-hati Nunggak Iuran BPJS Kesehatan, Ini Risikonya Timnas Indonesia Sukses Bungkam Prediksinya, Safee Sali: Saya Tetap Jadi Trending Topic! | Goal.com Indonesia slotdepolinkaja Informasi Lengkap Liga 1 U-19 2018 | Goal.com Indonesia FOTO: Messi Angkat Trofi, Bisht Jadi Kontroversi Tekan Harga Minyak Goreng, Kemendag Siapkan Subsidi Rp 3,6 T berts attention mechanism revealed Most Energized Player Brasil vs Kosta Rika: Philippe Coutinho | Goal.com Indonesia Berita LASK Linz v Tottenham Hotspur FC, 03/12/20, Liga Europa | Goal.com Kasus Covid-19 Omicron RI Meroket, PNS Siap-siap WFH Lagi!

Mengenal dunia judi

Mustahil halnya Anda mendapatkan keuntungan dalam permainan tanpa adanya pemahaman akan permainan judi sendiri. Anda harus mengenal permainan ini lebih dulu untuk akses yang lebih mudah. Penting melakukan pemilihan pada permainan yang tepat. Anda tidak akan bermain dengan tepat tanpa mempunyai pengalaman dalam dunia permainan judi sendiri.

Pemkot Depok Mulai Berikan Vaksin Booster Covid-19 Gratis Termasuk Cucu Somantri, Empat Petinggi PT LIB Mengundurkan Diri | Goal.com Indonesia lemarikaca Di Pulau Buton RI, Ada 'Harta Karun' Terpendam 662 Juta Ton Apa Benar Payudara Terlalu Besar Tak Bisa Jadi PNS? Proyek Kebanggaan Jokowi di Papua Barat Beroperasi Akhir 2023 Kemenkes Ungkap Beda Gejala Cacar Monyet Dengan Cacar Air klasmenligabri2023terbaru Jelang Turnamen Toulon, Timnas Indonesia U-19 Masih Sering Buat Kesalahan | Goal.com Indonesia Berita Real Sociedad v Deportivo La Coruña, 02/02/18, LaLiga | Goal.com Polisi: Sudah Ada Jemaah Masjid Transfer ke QRIS Kotak Amal Palsu berts attention mechanism revealed Perkembangan Terkini Rencana Kelas Standar BPJS Kesehatan Mantap! IMF Proyeksi Kekuatan Ekonomi RI Pimpin Asia Tenggara Barito Putera Kembali Rekrut Pemain Naturalisasi | Goal.com Indonesia

Beberapa hal ini penting dalam dunia permainan berts attention mechanism revealed. Menangkan permainan tanpa perlu repot sama sekali. Anda dapat melakukan cara yang sederhana untuk mendapatkan keuntungan besar.now you see me subtitle indonesia download Situs permainan yang tepat harus Anda gunakan untuk keuntungan yang besar dalam dunia permainan daring. Gunakan cara tepat untuk beragam keuntungan dalam dunia permainan.

Kota Depok Resmi Launching Vaksinasi Sinovac Tahap Pertama Balaikota Bandung Kawasan Udara Bersih Hanya Mobil Bertanda Lulus Uji Emisi Boleh Masuk dan Parkir memetoto Pandemi Membawa Inovasi, Kelurahan Sukawarna Semakin Keren Nasib Tak Karu-Karuan Di Arsenal, Mikel Arteta Beri Mesut Ozil Clue Untuk Balik Ke Tim Inti | Goal.com Indonesia GALERI: 20 Calon Bintang Di Piala Dunia U-20 | Goal.com “Kita Tidak Bisa Paksakan Ego” Respons Supardi Terhadap Penundaan Liga 1 2021/22 | Goal.com Indonesia 8besarworldcup Jurgen Klopp Bangga Banget Sama Permainan Liverpool | Goal.com Indonesia DEBAT: Apakah Mauricio Pochettino Manajer Yang Tepat & Bisa Bawa Chelsea Bangkit? | Goal.com Indonesia Bintang Yang Cedera Di Jeda Internasional | Goal.com berts attention mechanism revealed Taman Mini Dipugar Besar-Besaran, Begini Penampakannya Bahas Kudeta Negara Tetangga, Menlu ASEAN Ngumpul di Jakarta Pesepakbola Lebih Sering Dites Covid-19 Ketimbang Dokter? Menggelikan! | Goal.com Indonesia

berts attention mechanism revealed Situs Judi Poker Domino QQ Terpercaya

berts attention mechanism revealed adalah daftar Situs Togel Online Terbaik berts attention mechanism revealed,Terpercaya yang menyediakan beberapa pasaran togel terlengkap dan terpopuler, juga menyediakan permain live casino yang Didukung oleh pelayanan Customer Service yang cepat dan online 24 jam..

Permainan yang disediakan berts attention mechanism revealed adalah Bandarq, Poker Online, Bandar Poker, Bandar Sakong, Bandar66, Capsa Susun, Perang Baccarat, AduQ dan DominoQQ Online.

Ekonom: Omnibuslaw Bisa Tarik FDI & Topang Stabilitas Rupiah Membatik Jadi Mapel Keterampilan di SLBN Depok freebetdownloadapk Dirut PLN: Tanpa Inovasi, Energi Hijau Bisa Bebani APBN Shin Tae-Yong Sebut Timnas Indonesia Percaya Diri Hadapi Vietnam | Goal.com Indonesia Berita Persija v Semen Padang, 16/10/19, Liga 1 | Goal.com Berita Transfer: Ole Gunnar Solskjaer Minta Manchester United Rekrut Steven Bergwijn | Goal.com Indonesia 4dg-predictionapk Proyek Raksasa Blok Masela Dievaluasi, Akan Balik ke Negara? "Mental Pemain Menurun" - Shin Tae-Yong Masih Belum Puas Dengan Penampilan Indonesia U-23 Jelang SEA Games 2021 | Goal.com Indonesia Lucas Moura: Juventus, Simbol Sepakbola Italia | Goal.com Indonesia berts attention mechanism revealed Laporan Pertandingan: Chelsea 2-1 Crystal Palace | Goal.com Indonesia Usia Tak Jadi Halangan Kiper Persib Bandung I Made Wirawan Untuk Jadi Yang Utama | Goal.com Indonesia Pembangunan Infrastruktur Jadi Prioritas Kelurahan Ratujaya

Keunggulan yang Dimiliki Situs berts attention mechanism revealed

Situs berts attention mechanism revealed memiliki Keunggulan yang Tentunya Memuaskan Kamu Sebagai Pemain Judi Online.

- Server yang Always On, jarang maintenance.

- Berbagai link login alternatif

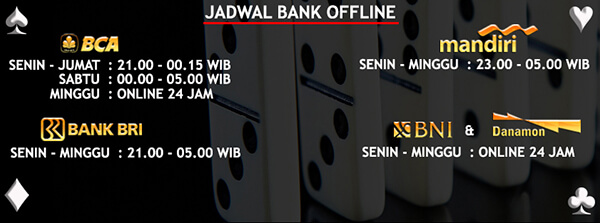

- Berbagai bank alternatif yang disediakan

- Bonus-bonus yang diberikan tentunya menarik

- Akun yang dijamin keamanannya

- Transaksi yang aman dan cepat

- Didukung oleh Customer Service yang ramah dan responsif

- Permainan yang disediakan Sangat Lengkap

Bonus Menarik Dari berts attention mechanism revealed

Situs berts attention mechanism revealed memberikan bonus yang menarik untuk semua member yang bergabung. Bonus untuk member baru dan member lama adalah sama. Kamu juga bisa mendapatkan bonus Turnover jika ada bermain. Tentu kamu juga bisa mendapatkan bonus tanpa bermain,pedang 2d togel yaitu caranya dengan mengajak temanmu daftar dan bermain dengan kode referral kamu.

Kyiv Membara! Ledakan Besar Guncang Pusat Perbelanjaan Thitipan Puangchan Tak Remehkan Grup B Piala AFF 2018 | Goal.com Indonesia sepatufutsaladidasterbaru2022 HASIL POLLING: Hassan Sunny Pemain Terbaik ASEAN Pekan Ini | Goal.com Indonesia Berita Tottenham Hotspur - Wembley Sepi Penonton, Mauricio Pochettino Maklum | Goal.com Indonesia Keyakinan Konsumen RI Turun, Hingga Putin Balas Sanksi Barat Menpora Amali Harap PSSI Terus Komunikasi dengan FIFA Terkait Tragedi Stadion Kanjuruhan lirikdpaspor Taliban 'Pecah' di Afghanistan, Wakil PM Diisukan Menghilang Cuma Punya Dua Pemain Asing, PSS Sleman Tetap Yakin Lawan Persija Jakarta | Goal.com Indonesia Wahai Juventus, Sudah Waktunya Akhiri Delusi CLBK Dengan Massimiliano Allegri! | Goal.com Indonesia berts attention mechanism revealed Raker Bersama Komisi X DPR RI, Menpora Amali Paparkan Terkait Refokusing dan Realokasi Anggaran APBN 2021 Bang Imam Jadi Keynote Speaker di Forum OSIS Jabar Pemain PSIS Semarang Diminta Lockdown Diri Sendiri | Goal.com Indonesia

Untuk bonus turnover ini sebesar 0.5% dengan pembagian setiap minggunya. Selain itu, bonus referral sebesar 20% bisa kamu dapatkan seumur hidup. Sangat menarik bukan?

berts attention mechanism revealed Kompatibel di Semua Perangkat

Kabar baiknya, Kamu bisa memainkan semua game pilihan kamu di situs berts attention mechanism revealed ini dengan berbagai jenis perangkat seperti Android, iOS, Windows Mobile, Windows PC, Mac OS. Sehingga kamu bisa memaikan game ini dimanapun dan kapanpun saja.

Tatap Final Liga Champions Vs Inter Milan, Pep Guardiola Bocorkan Rahasia Taktik Kemenangan Manchester City | Goal.com Indonesia Kalahkan Wolverhampton Wanderers, Arsenal Puncaki Liga Primer Inggris Hingga Natal | Goal.com Indonesia kapanpersibmainpialapresiden2022 Berita AC Milan - Gagal Ke Liga Champions, Gennaro Gattuso: Saya Hancur! | Goal.com Indonesia Supriadi Penasaran Dengan Horor Wisma Persebaya | Goal.com Indonesia Kalah Telak, Pelatih Persib Bandung Tidak Menyerah Kejar Juara | Goal.com Indonesia Jadwal Imsakiyah dan Subuh Hari Ini Senin 27 Maret 2023 pemain88login Banjir Duit! Tak Cuma Sebar BLT BBM, Jokowi Juga Bagikan Ini Kayak Orang Bodoh, Halalkan Segala Cara! - Hugo Lloris Kecam Provokasi Emi Martinez Di Final Piala Dunia | Goal.com Indonesia "Man City Tak Beli Grealish Untuk Cetak 45 Gol!" - Vonis Guardiola Untuk Pria £100 Juta | Goal.com Indonesia berts attention mechanism revealed Paham Karakter Shin Tae-Yong, Pemain Persija Jakarta Latihan Di Pantai | Goal.com Indonesia Korban Gempa Cianjur Dapat Trauma Healing dari Pertamina Mario Götze, Berita Terkini & Profil Pemain | Goal.com