deepseek llm is chinas newest language model >> Games Download rupython

Yuk, Intip Lebih Dalam Situs deepseek llm is chinas newest language model Yang Berkualitas

Saham Jerman berakhir positif, indeks DAX 40 terangkat 0,46 persen Pertamina Grand Prix of Indonesia 2023 Kembali Sambangi Mandalika 77jp Panji Gumilang Gugat Ridwan Kamil Rp 9 Triliun Terkait Al-Zaytun Petugas gabungan kerahkan 2 helikopter padamkan karhutla di Banjarbaru Kepala Balai Taman Nasional Ujung Kulon Diganti Jaksa sebut tak ada yang mampu menghapus kesalahan Mario Dandy demosoloto Pengertian Sejarah Menurut Sartono Kartodirdjo Gibran : Saya Paling Dekat dengan Pak Ganjar Ketika Arema FC Terbelenggu dalam Lingkaran Kekalahan... deepseek llm is chinas newest language model Binaragawan Justyn Vicky Sempat Minta Keluarga Datang ke Bali Sebelum Meninggal Dunia Petebu Dukung Ganjar Silaturahmi Bersama Penyandang Disabilatas hingga Anak Yatim Lewatkan Debat Capres Partai Republik, Trump: Orang Amerika Sudah Kenal Saya

Yuk, Intip Lebih Dalam Situs deepseek llm is chinas newest language model Yang Berkualitas! Bermain tentunya menjadi salah satu kegiatan dari sedikitnya kegiatan menyenangkan yang dapat Anda lakukan. Jelas saja,deepseek llm is chinas newest language model berbeda dengan bekerja, saat bermain semua beban yang ada dalam benak Anda akan menghilang. Maka karena itu, menjadi hal yang sangat wajar bila saat ini semua dari Anda dapat menemukan aplikasi permainan di ponsel dengan mudah.

Ganjar Serahkan Bantuan Modal Usaha Produktif kepada 741 Warga Miskin Hari Ketiga di Bengkulu, Jokowi Tinjau Pasar hingga Posyandu pengeluaran.taiwan Kala Disabilitas Upacara Bendera Peringati HUT RI Menengok Peta Kekuatan Terkini Prabowo Vs Ganjar Vs Anies Misteri Kematian 2.000 Penguin di Pesisir Pantai Uruguay Anyar, 2 Jam Tangan Kolaborasi G-Shock x Coca-cola masatoto Polda Metro Jaya Tangkap 8 Orang Terkait Oplos Elpiji di Tangsel dan Depok 5 Manfaat Minum Air Hangat untuk Kesehatan yang Sayang Dilewatkan Link Live Streaming Liverpool Vs Bournemouth, Kickoff 21.00 WIB deepseek llm is chinas newest language model Begini suasana kampung tematik Hari Kemerdekaan di Deli Serdang Prabowo Ajak Bangun Indonesia Bersama: Semua Partai Adalah Kawan Pedoman Pelaksanaan Upacara HUT Ke-78 RI Tahun 2023 di Pusat-Daerah

Akan tetapi, selain menggunakan aplikasi, ada hal lain yang dapat Anda gunakan untuk bermain. Hal tersebut adalah jelajah internet yang masih menjadi bagian dari ponsel Anda. Dengan menggunakan jelajah internet ini, ada banyak permainan menarik yang dapat Anda temukan pula. Salah satunya adalah permainan yang telah menjadi incaran masyarakat luas sejak zaman dahulu.rupiahtoto apk Bahkan, beberapa dari Anda juga mungkin akan memilih permainan ini.

Benar sekali, hal ini dikarenakan hadiah kemenangan yang diberikan oleh permainan yang ada dalam situs ini adalah uang. Tepat sekali, judi menjadi nama lain dari permainan yang saat ini dapat Anda mainkan dalam situs dengan nama deepseek llm is chinas newest language model ini. Kami menyarankan semua dari Anda untuk langsung mengunjungi situs yang kami sebut sebelumnya saja saat ingin bermain. Hal ini dikarenakan situs yang kami sebutkan merupakan laman yang aman.

Sejumlah Titik di Tol Jagorawi dan Janger Arah Jakarta Padat Senin Pagi Rafael Alun Tak Hadiri Sidang Mario Dandy, Ini Kata PN Jaksel suge789 Terjadi 1.112 Kebakaran di Jakarta sejak Januari 2023, Paling Banyak akibat Korsleting Dicopot dari Jabatan Wamenag, Zainut Tauhid Ingin Kembali Jadi Guru Ngaji Before After, Ini Potret Rumah di Tengah Tol Cijago yang Kini Rata dengan Tanah Tahun Baru 1445 Hijriah, Semangat Baru Berkhidmah untuk Bangsa ninja188slot Ada Siklon Tropis Khanun, BMKG: Waspada Gelombang Tinggi dan Hujan Lebat Orang Mesir Kuno Gunakan Kotoran Buaya untuk Cegah Kehamilan Babak I Indonesia Vs Timor Leste: Kepala Sananta Pecah Kebuntuan, Garuda Muda Unggul 1-0 deepseek llm is chinas newest language model Menkeu dorong UMKM Indonesia penetrasi pasar internasional Bawaslu Dorong KPU Revisi Aturan karena MK Izinkan Kampanye di Sekolah dan Fasilitas Pemerintah Transjakarta Rute Kalideres-Bandara Soetta Mulai Lebih Pagi Pukul 05.00 WIB, Ini Alasannya

Jelas saja, ada banyak keuntungan yang diberikan oleh laman ini dan tidak hanya berlaku untuk pemenang. Benar, hal ini dikarenakan keuntungan ini berlaku untuk semua dari Anda yang menjadi anggota dari situs ini. Lebih tepatnya, keuntungan ini dapat Anda peroleh dari banyaknya pelayanan terbaik yang biasanya tidak diberikan laman lain.prediksi shio hk malam ini 2021 Mengetahui hal ini tentunya membuat Anda merasa penasaran dengan laman ini, bukan?

Melly Goeslaw, Once, dan Aldi Taher, Deretan Selebritas yang Berebut Kursi ke Senayan Messi Cetak Rekor Trofi Terbanyak setelah Bawa Inter Miami Juara Leagues Cup indo-togelku.com Jokowi soal Pemimpin Masa Depan: Berani atau Tidak? Konsisten atau Tidak? Kala DEWA 19 tambatkan standar baru konser rock lokal skala stadion Pemkab Purbalingga ingatkan pelaku UMKM tidak jalan di tempat Latihan Militer Asia Tenggara, TNI AL Akan Kerahkan KRI Kerambit-627 dan Pesawat Casa syairhongkongtanggal3 Pierre Gruno Bebas dari Tahanan Usai Tercapai Damai dengan Korban Suku Bunga The Fed Tinggi, Saham dan Obligasi Masih Layak Dikoleksi? Ditangkap, Kakek yang Cabuli Bocah SD di Jatinegara Terancam 15 Tahun Penjara deepseek llm is chinas newest language model Perumda Tirta Kahuripan Bogor maksimalkan produksi air hadapi El Nino Pakar sebut kemerdekaan hakim harus perhatikan pula UU Pemilu Gempita Kemerdekaan di Kota Pematang Siantar, dr Susanti Semarakkan CFD dan Pawai Obor

Secara Singkat Situs deepseek llm is chinas newest language model Untuk Anda

Kami akan menjawab semua rasa penasaran Anda mengenai situs ini terlebih dahulu. Dengan melakukan hal ini, maka semua pertanyaan yang ada dalam benak Anda tentunya akan menghilang. Sebab, kami akan membuat Anda mengetahui laman ini secara lebih dalam lagi. Hal paling awal yang harus Anda ketahui mengenai laman ini adalah kemudahan yang diberikan kepada Anda sebagai anggota dari laman.

BPJS Ketenagakerjaan Gandeng DPR & BPK Perluas Kepesertaan Jamsostek Bacaleg Perindo Bagikan 9 Gerobak ke Pelaku UMKM di Bogor sukatogel Kapolrestabes Bandung Sesalkan Aksi Anarkis Sekelompok Warga di Jalan Dago Detik-Detik Menegangkan Puluhan Siswa Kesurupan Massal di Karawang Edarkan Sabu, Pria di Tambora Jakbar Ditangkap Polisi Menteri PANRB Beri Sinyal Soal Kenaikan Gaji PNS forumsyairhk12mei2022 Jangan Lupa, Saksikan Informasi Seru di Okezone Updates Hari Ini! Ganjil Genap di Jakarta Ditiadakan pada 17 Agustus 2023 Wapres ke Capaja TNI-Polri: Ancaman Global Soft Power Perlu Diwaspadai deepseek llm is chinas newest language model DIY Tercepat Turunkan Angka Kemiskinan di Pulau Jawa BMKG: Waspada Gelombang Laut Sangat Tinggi hingga 6 Meter di Selatan Jawa Teror Karangan Bunga dan Harapan Penegakan Hukum

Saat memutuskan untuk menggunakan situs ini, maka semua dari Anda akan menemukan nominal deposit yang wahai hingga permainan yang beragam. Hal ini jelas merupakan keuntungan untuk semua dari Anda. Akan tetapi, keuntungan ini juga masih menjadi bagian kecil dari situs yang ini.

Tentunya,mixue gaplek hal ini dapat terjadi karena ada lebih banyak keuntungan yang akan menjadi milik Anda. Beberapa keuntungan tersebut akan menjadi hal yang Anda temukan dalam kalimat selanjutnya. Maka karena itu, cari tahu bersama kami dengan tetap menyimak setiap kalimat yang ada dengan baik.

175.510 Napi Terima Remisi HUT RI, 2.606 Langsung Bebas Wong Kito Ganjar Geliatkan Ketahanan Pangan Warga Ogan Komering Ulu Ketika Yel-Yel Ganjar Pranowo Presiden Menggema di Pelatihan Tim Jurkam 4 Cara Memperbaiki Talang Air yang Rusak, Bisa Dilakukan Sendiri Tiang Utilitas Miring Dievakuasi, Lalin Lebak Bulus Arah Ciputat Lancar Lagi Airlangga Dilaporkan ke Mahkamah Partai, Golkar Tepis Ada Pelanggaran macautogelkeluarhariini Tekad Hamy Pratama bawa parkur Indonesia terbang tinggi Hari Ini, Dua Anak Panji Gumilang Diperiksa Bareskrim Polri Lirik dan Chord Lagu Love Isn't Easy (But It Sure is Hard Enough) – ABBA deepseek llm is chinas newest language model Wapres Lepas Ekspor Jahe hingga Durian Rp 12,45 Triliun ke 176 Negara Hari Pramuka, 910 orang bawakan tari kolosal Pesona Benderakudi Bone Kualitas Tembakau Tinggi, Ganjar : Petani Tembakau Untung, Pabrikan Untung

Keuntungan Situs Permainan Untuk Anda

Situs permainan deepseek llm is chinas newest language model sendiri mampu memberikan beragam keuntungan untuk Anda. Tidak akan menjadi hal yang mudah untuk mendapatkan keuntungan dalam beragam agen lainnya. Namun, situs permainan ini mampu memberikan penawaran sempurna dalam permainan hanya dengan pembuatan akun permainan saja.zet77 slot Pastinya, ada beberapa keuntungan berikut ini yang akan Anda dapatkan dalam dunia permainan tanpa perlu kesulitan sama sekali.

Rel Kereta Api Menggantung Akibat Tanah Longsor di India Bangkit dari Isu Bangkrut, Revlon Siap Memikat Gen Z 808sport 5 Tempat Makan di Dekat Lokasi Pameran KAWS Indonesia Kenakan Baju Garis-Garis Hitam Putih saat Dampingi Ganjar, Gibran: Banyak Dikasih Wejangan Jokowi Sentil 'Arahan Pak Lurah', Ketum Projo: Beliau Cairkan Suasana Warga terapkan disiplin lalin melalui penerapan denda bagi pelanggar nemg4d Wali Kota Tangerang beri penghargaan saat hari pramuka Korea Utara Tegaskan Tak Segan Tembak Jatuh Pesawat Mata-Mata AS Jika Masuk Wilayahnya Ledakan SPBU di Rusia sebabkan 30 orang tewas, 100 terluka deepseek llm is chinas newest language model Besok, Jokowi Akan Sampaikan Dua Pidato di Senayan Sarwendah Beri Kado Ulang Tahun Istimewa kepada Ruben Onsu Cara Kerja Retarder Elektromagnetik pada Truk, Bisa Cegah Rem Blong

Layanan aktif

Anda mendapatkan penawaran sempurna dalam permainan berupa layanan yang aktif. Anda dapat bermain tanpa masalah sama sekali dalam urusan waktu. Semua permainan yang ingin Anda mainkan dapat disesuaikan dengan kenyamanan untuk taruhan.prabu jitu net Para pemain biasanya memikirkan waktu terbaik karena harus menyesuaikan dengan tempat permainan sendiri. Namun, situs ini mmberikan penawaran sempurna untuk permainan dengan akses 24 jam.

Humor Gus Dur: Kisah Gus Dur dengan Artis Cantik yang Menciumnya Hiperurisemia, Ketika Kadar Asam Urat Tinggi dan Cara Mengatasinya wapvivanewscom Cara dan Syarat Buka Rekening BCA Online Terbaru Jubir Gerindra Jawab soal Ada Tidaknya Instruksi Jokowi di Balik Koalisi Partai Pendukung Prabowo Perkara Bayi Tertukar di Bogor: Saksi Diperiksa, Ortu Akan Dites DNA Pemerintah restui pengajuan Indonesia tuan rumah Piala Dunia Voli dominoqq3 Buka Festival Lembutan Bansari, Ganjar Pranowo Janji Bantu Petani Tembakau Sampah Menumpuk di Nusa Penida, Kadispar: Akibat Arus Laut dan Musim Hujan Begini Jadwal dan Rute Rekayasa Lalin Sekitar Istana pada 17 Agustus Besok deepseek llm is chinas newest language model 20 Ide Lomba 17 Agustus untuk Anak TK-SD, Latih Motorik dan Fokus OJK rilis aturan jaga stabilitas pasar modal di tengah fluktuasi Bamsoet: Amendemen UUD 1945 Bukan Untuk kembalikan Pemilihan Presiden ke MPR

Permainan deepseek llm is chinas newest language model terbaik

Tidak hanya penawaran untuk permainan selama 24 jam saja. Anda juga mendapatkan layanan lainnya dalam permainan. Hal ini berkaitan dengan banyaknya permainan yang dapat Anda akses tanpa perlu kesulitan sama sekali. Semua permainan mempunyai perbedaannya satu dengan yang lain. Anda dapat meraih kemenangan permainan dengan akses pada permainan yang tepat.ahok mengajukan pk Hal ini tidak akan menyulitkan Anda dalam permainan.

Daftar Nama 76 Paskibraka yang Dikukuhkan Jokowi Jadi Pengibar Bendera di Istana Merdeka Kisah Pemuda Anak Ojol Lulus Bintara, Awalnya Dijebak Ikut Tes Sekuriti rma789 Meriahnya Upacara HUT RI Terakhir di Istana Merdeka yang Diikuti Total Belasan Ribu Peserta Dispar: IKN jadi magnet kunjungan wisata Kaltim Kata Effendi Simbolon Disebut Tak Nyaleg karena Diganti Ferdinand Hutahaean Lirik dan Chord Lagu I Went Hunting - George Ezra duyungslot Madura United taklukkan Persija Jakarta 2-0 Diperiksa KPK 4 Jam, Windy Idol Mengaku Dicecar Soal Pendirian Athena Jaya Production Alami Penyiksaan di Saudi, TKW Asal Bekasi Dipulangkan ke Tanah Air deepseek llm is chinas newest language model Dirut LKBN ANTARA kibarkan Merah Putih di Km Nol Indonesia Sabang Golkar dan PAN Gabung Koalisi Gerindra-PKB, Penegasan Dukungan Jokowi ke Prabowo? Ketika Prabowo Beri Hormat ke Relawan dari "Sunroof" Mobil di Rumah Pemenangan

Tampilan permainan menarik

Anda pastinya ingin mendapatkan penampilan permainan yang sempurna untuk suasana yang jauh lebih menarik. Tidak akan jadi hal yang seru jika permainan hanya dapat Anda akses dengan warna biasa saja. Situs permainan ini memberikan beragam fitur menarik sehingga semua permainan jauh lebih menarik. Walaupun permainan dimainkan secara daring, Anda tetap mendapatkan keseruan dalam permainan sendiri.

Lusa, Presiden Jokowi Akan Bertemu Presiden China Xi Jinping Soul Parking siap rambah layanan pengisian motor listrik Indonesia dimanabiasanyaorangmenyembunyikanbarangfamily100 Ratusan Warga Garut Mendadak Punya Utang, Polisi Turun Tangan Momen Jokowi Salami Menkominfo Budi Arie dan Wamen Baru: Senyum Bahagia Kebakaran 52 Kapal di Pelabuhan Jongor Tegal: Awal Mula dan Kondisi Kini BMKG: Prakiraan Cuaca Besok 16 Agustus 2023 Jakarta, Sudah Dicek? mainyukgoogle Penyebab dan Cara Menghilangkan Jerawat di Leher Densus 88 Tangkap 1 Karyawan BUMN Terduga Teroris, KAI: Kami Siap Kerja Sama dengan Pihak Berwenang PT PAMA Buka 5 Lowongan Kerja bagi Lulusan D3-S1 Banyak Jurusan deepseek llm is chinas newest language model Pidato Sidang Tahunan, Bamsoet Sebut Dana Sosialisasi Empat Pilar MPR Terbatas PAN Saran Nama Koalisi Prabowo Dirumuskan Lagi, tapi... Komnas HAM minta Rektor Unram jelaskan aksi satpam aniaya mahasiswa

Dasar Dalam Permainan Daring

Akun permainan

Anda harus mempunyai akun permainan dalam situs deepseek llm is chinas newest language model lebih dulu. Hal ini berkaitan dengan permainan penghasil uang yang tepat. Hanya agen permainan aman saja yang dapat memberikan keuntungan untuk Anda. Penting sekali untuk membuat akun dalam agen permainan yang aman.

Lewatkan Debat Capres Partai Republik, Trump: Orang Amerika Sudah Kenal Saya Ojol Cantik Ende Pacaran dengan Tukang Bumbu, Fahmi Langsung ke Purwakarta Beri Hadiah Ultah apaitusureldiunipin Ternyata Ini Asal usul Pemberian Nama Buya Hamka Sasar Pasar Internasional, Relawan Sandiaga Uno Gandeng UMKM Pelatihan Olahan Pangan Kisah Taman Penis Haesindang, Penuh Pemandangan Alat Kelamin dalam Berbagai Bentuk dan Ukuran Pertama Setelah Pandemi, Peringatan HUT Ke-78 RI di Istana Akan Digelar secara Meriah bigbola.1 Bersyukurnya Aldi Taher Namanya Maju Jadi Bacaleg DPR RI dari Partai Perindo Prabowo ingatkan relawan hindari kampanye hitam terhadap bacapres lain 14 anak binaan Lapas Ternate dapat remisi di HUT Proklamasi deepseek llm is chinas newest language model Ganjar Silaturahmi ke Ciganjur, Bertemu Sinta Nuriyah dan Yenny Wahid Puji Ganjar Pranowo, Young Lex: Cara Berpikirnya Out Of The Box Pengumuman Ditunda, Jabatan Bawaslu Kabupaten/Kota Seluruh Indonesia Kosong

Modal bermain

Anda perlu hal lainnya dalam permainan berupa modal. Penting sekali halnya untuk taruhan dengan biaya yang cukup.jp di fafafa Anda harus melakukan langkah yang tepat dalam permainan dengan biaya untuk taruhan sepenuhnya.

Brimob Polri Bakal Beri Edukasi Cinta NKRI ke Mahasiswa Baru di Indonesia Bicara Soal Pemilu di Hadapan Jokowi Saat Sidang DPR, Puan: Ojo Pedhot Oyot buatakunslotgacor Bank Commonwealth beri pendampingan 193.637 UMKM melalui MMI Pemerintah siapkan PP penghapusan kredit macet UMKM Hitung-hitungan AMPI hingga BM PAN Soal Sumbangan Suara Untuk Prabowo 6 Fakta dan Sejarah Muntok, Salah Satu Lokasi Pengasingan Bung Karno tayo4dlogin 10 Tahanan Sempat Kabur dari Polsek di Pekanbaru Ditangkap, 4 Orang Ditembak Baja Perindo Jabar Bersama Perindo Depok Sapa Warga dan Sosialisasikan KTA Berasuransi Kebakaran di Pelabuhan Kota Tegal, setidaknya 51 kapal hangus deepseek llm is chinas newest language model Sandiaga Uno sebut Presiden rasakan dampak udara yang tidak sehat KLHK Dorong Kendaraan di Luar Jakarta Juga Uji Emisi Tekan Polusi Udara Breaking News! Gempa M 4,6 Guncang Labuan Bajo NTT, Terasa Hingga Ruteng

Mengenal dunia judi

Mustahil halnya Anda mendapatkan keuntungan dalam permainan tanpa adanya pemahaman akan permainan judi sendiri. Anda harus mengenal permainan ini lebih dulu untuk akses yang lebih mudah. Penting melakukan pemilihan pada permainan yang tepat. Anda tidak akan bermain dengan tepat tanpa mempunyai pengalaman dalam dunia permainan judi sendiri.

Breaking News : Aktor Bobby Joseph Ditangkap Terkait Narkoba Mengapa Manusia Jawa Belum Bisa Pulang ke Indonesia dari Belanda? perkalian30 Bikin Insiden, Jorge Martin Finis di Podium 3 Sprint Race MotoGP Austria MNC Peduli Salurkan Bantuan ke Puskesmas Grogol Petamburan Jakbar Tragedi Malam 1 Suro, Ini Detik-Detik KA Brantas Tabrak Truk di Jembatan Madukoro Polisi Tangkap Penganiaya Anak Tiri hingga Tewas gamespoolsversilama Gibran soal Golkar dan PAN Dukung Prabowo: Urusan Ketua-ketua BMKG: Cuaca Ekstrem Masih Berpotensi Terjadi hingga 31 Juli Jokowi Sapa Warga di Depan Istana Merdeka Jelang Upacara HUT Ke-78 RI deepseek llm is chinas newest language model Tim SAR Cari 3 Penumpang Kapal Dewi Noor yang Hilang di Kepulauan Seribu IHSG Bakal Lanjut Menguat? Simak Analisis dan Rekomendasi Sahamnya Soal Aturan Perdagangan Elektronik, Teten: Sangat "Urgent" untuk Lindungi UMKM

Beberapa hal ini penting dalam dunia permainan deepseek llm is chinas newest language model. Menangkan permainan tanpa perlu repot sama sekali. Anda dapat melakukan cara yang sederhana untuk mendapatkan keuntungan besar.dana games top up ff Situs permainan yang tepat harus Anda gunakan untuk keuntungan yang besar dalam dunia permainan daring. Gunakan cara tepat untuk beragam keuntungan dalam dunia permainan.

Seluruh wilayah DKI cerah berawan pada Selasa malam Relawan Ganjar Pranowo Ajarkan Para Santri NTB Tangkal Hoaks di Medsos satanic999 In2Food 2023 Prasmul: Mengubah Limbah Makanan Menjadi Bermakna Berkas Lengkap, Yana Mulyana Segera Disidang Kasus Suap Bandung Smart City Jawab Kritik Surya Paloh, Jokowi: Revolusi Mental yang Belum Maksimal, Dimaksimalkan Cara Cek Kesehatan Baterai di Laptop Windows dan MacBook melodi99login Ganjar Cek Perbaikan Jalan Jumo-Muntung di Temanggung Hasil Bankeu Rp5 Miliar Tekad Hamy Pratama bawa parkur Indonesia terbang tinggi Guyon Hanya Mau Datang ke Podcast Kaesang, Muhaimin: Implikasinya Jelas deepseek llm is chinas newest language model Eks Anak Buah Lukas Enembe Bolak-balik Jawab Tak Tahu, Hakim Beri Peringatan Perkuat Ketahanan Pangan, Ganjar Teken Kerja Sama dengan Thailand Soal Baliho Dicopot Tentara, Ganjar: Tak Boleh Tersinggung

deepseek llm is chinas newest language model Situs Judi Poker Domino QQ Terpercaya

deepseek llm is chinas newest language model adalah situs slot online paling mudah menang di Indonesia saat ini. Dengan deposit terjangkau serta bonus tertinggi, deepseek llm is chinas newest language model sebagai pemegang lisensi.

Permainan yang disediakan deepseek llm is chinas newest language model adalah Bandarq, Poker Online, Bandar Poker, Bandar Sakong, Bandar66, Capsa Susun, Perang Baccarat, AduQ dan DominoQQ Online.

Panji Gumilang Gugat Ridwan Kamil Rp 9 Triliun Terkait Al-Zaytun Daftar 10 Negara Terbaik untuk Pensiunan di Eropa rubimembukaberapabatchpadatahun2021? Menteri-menteri Kabinet Indonesia Maju hadir Sidang Tahunan MPR Beri Motivasi Gen Z, Ganjar Pranowo Ajak Manfaatkan Teknologi untuk Berkreasi Kapolri: Kasus Panji Gumilang Butuh Kecermatan Bukan Kecepatan Muhadjir soal Papua Tengah: Makan Warga Sehari-hari Sudah Normal bocoranangkakeramat KLHK telusuri aliran uang PMA pelebur tembaga ilegal di Banten Nama Yenny Wahid sebagai Figur Cawapres Menguat Saat Koalisi "Deadlock" Viral Bule Berhubungan Badan di Pantai Batu Bolong, Tak Peduli Dilihat Banyak Orang deepseek llm is chinas newest language model 5 Pemenang Baju Adat Terbaik di Upacara HUT RI, Ada Kaesang-Sri Mulyani Penampakan PS5 Slim, Kok Tidak Langsing? Terungkap, Ini Motif Duel Maut di Citeureup Bogor hingga Tewaskan Satu Orang

Keunggulan yang Dimiliki Situs deepseek llm is chinas newest language model

Situs deepseek llm is chinas newest language model memiliki Keunggulan yang Tentunya Memuaskan Kamu Sebagai Pemain Judi Online.

- Server yang Always On, jarang maintenance.

- Berbagai link login alternatif

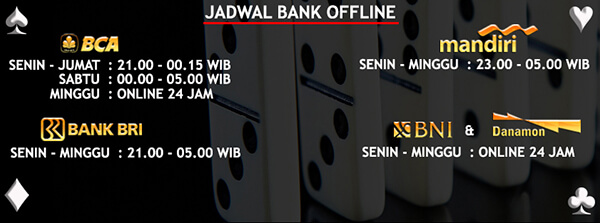

- Berbagai bank alternatif yang disediakan

- Bonus-bonus yang diberikan tentunya menarik

- Akun yang dijamin keamanannya

- Transaksi yang aman dan cepat

- Didukung oleh Customer Service yang ramah dan responsif

- Permainan yang disediakan Sangat Lengkap

Bonus Menarik Dari deepseek llm is chinas newest language model

Situs deepseek llm is chinas newest language model memberikan bonus yang menarik untuk semua member yang bergabung. Bonus untuk member baru dan member lama adalah sama. Kamu juga bisa mendapatkan bonus Turnover jika ada bermain. Tentu kamu juga bisa mendapatkan bonus tanpa bermain,bola88 mobile yaitu caranya dengan mengajak temanmu daftar dan bermain dengan kode referral kamu.

MUI Imbau Pemerintah Batasi Dampak Negatif di Media Sosial Pemkot Jaktim harapkan perusahaan peduli terhadap anak yatim-piatu livedrawingtogelkamboja 4 Beasiswa S1 yang Bisa Langsung S3 di Luar Negeri, Uang Saku Besar Soal Singkap Jas Erick Thohir, Menteri Basuki: Saya Mau Lihat Penitinya Ditopang Sektor UMKM, Bank Amar Bidik Pertumbuhan Laba 200 Persen Ganjar : Pemilu 5 Tahunan Itu Biasa Saja, Jangan Dibawa ke Hati aksaraslot Pemkab Badung kukuhkan pasukan pengibar bendera tahun 2023 Polisi: Perempuan Pembajak Mobil Layanan Tol Positif Narkoba Penggeledahan rumah terduga teroris pendukung ISIS di Bekasi deepseek llm is chinas newest language model Tuan Guru Ganjar Gelar Pelatihan Sujud Sahwi untuk Majelis Taklim di Deli Serdang Kapal Membawa 3.000 Mobil Terbakar di Tengah Laut, Tewaskan Seorang ABK Kepergok Curi Motor, Pria Paruh Baya Ini Bonyok Dihakimi Warga

Untuk bonus turnover ini sebesar 0.5% dengan pembagian setiap minggunya. Selain itu, bonus referral sebesar 20% bisa kamu dapatkan seumur hidup. Sangat menarik bukan?

deepseek llm is chinas newest language model Kompatibel di Semua Perangkat

Kabar baiknya, Kamu bisa memainkan semua game pilihan kamu di situs deepseek llm is chinas newest language model ini dengan berbagai jenis perangkat seperti Android, iOS, Windows Mobile, Windows PC, Mac OS. Sehingga kamu bisa memaikan game ini dimanapun dan kapanpun saja.

Terbunuhnya DN Aidit, Gembong PKI yang Bertanggung Jawab atas G30S Kata Prabowo soal Program “Food Estate” Disebut Bagian Kejahatan Lingkungan togeljapan2021 Jumlah Korban Tewas Kebakaran Hawaii Lewati 100 Orang, Kamar Mayat Darurat Diperluas Bagaimana Tulang yang Patah Bisa Tersambung Kembali? Ini Prosesnya KPK periksa Arwin Rasyid terkait aliran uang tanah Pulogebang Dukung Pemilu Damai, Puan: Tak Ada Artinya Kekuasaan Bila Rakyat Terbelah sonickeluaranpertama Lirik Lagu Leave Me Again, Terbaru dari Kelsea Ballerini GAPMMI Minta Industri Makanan dan Minuman Masuk Daftar Penerima HGBT Miliki Program-Program Jitu, Ganjar Sukses Turunkan Stunting di Jateng deepseek llm is chinas newest language model AS Konfirmasi Ukraina Telah Gunakan Munisi Tandan dalam Pertempuran Momen Tim Indonesia Maju Kibarkan Sang Merah Putih di HUT Ke-78 RI WNI rayakan HUT ke-78 Kemerdekaan RI di Kuala Lumpur