practical considerations in rag application design | Situs Judi With Withdraw Tercepat rupython

Yuk, Intip Lebih Dalam Situs practical considerations in rag application design Yang Berkualitas

Ketua NPC Indonesia Beri Penjelasan Terkait Ditunjuknya Gibran Sebagai Ketua INASPOC Persebaya Surabaya Tak Pilih-Pilih Lawan Di Babak Delapan Besar | Goal.com Indonesia mahjongjinpai Inggris Perpanjang Rekor Clean Sheet Di Babak Kualifikasi | Goal.com Indonesia Eredivisie: Feyenoord 6-2 Ajax | Goal.com Indonesia Gaskan - Jawaban Simpel Pep Guardiola Saat Manchester City Mau Rekrut Erling Haaland | Goal.com Indonesia Peningkatan Pelayanan Kesehatan Jadi Salah Satu Fokus RSUD Depok di 2022 bioskop4d Berita Borussia Dortmund - Belum Genap 20 Tahun, Jadon Sancho Sudah Cetak 25 Gol | Goal.com Indonesia Demi Neymar, Pemerintah Qatar Siap Turun Tangan | Goal.com Indonesia Chelsea Disarankan Gaet Jack Wilshere | Goal.com Indonesia practical considerations in rag application design Berita Transfer - Stoke City Tak Ingin Ditinggal Jack Butland | Goal.com Indonesia Argentina Menang Dramatis! Lionel Messi & Emi Martinez Bikin Belanda Angkat Koper Dari Piala Dunia 2022 | Goal.com Indonesia KOTA BANDUNG LAKSANAKAN PERINGATAN HARI KESEHATAN NASIONAL

Yuk, Intip Lebih Dalam Situs practical considerations in rag application design Yang Berkualitas! Bermain tentunya menjadi salah satu kegiatan dari sedikitnya kegiatan menyenangkan yang dapat Anda lakukan. Jelas saja,practical considerations in rag application design berbeda dengan bekerja, saat bermain semua beban yang ada dalam benak Anda akan menghilang. Maka karena itu, menjadi hal yang sangat wajar bila saat ini semua dari Anda dapat menemukan aplikasi permainan di ponsel dengan mudah.

Yuk Latihan Band di Bandung Creative Hub, Gratis Loh Libur Panjang Picu Kasus Aktif Covid-19 di RI 'Meledak' jokerroyal888 Penampakan Gerbong Kereta Cepat Baru Turun di Tanjung Priok Berita Manchester United - Jasper Cillessen Jadi Pengganti David De Gea? | Goal.com Indonesia Banyak Tokoh Penting, Yuk Ikut Golf Economic Outlook Edition! Bakal Calon Lawan Indonesia Punya Pemain yang Pernah Hancurkan MU sloter77 Bukan Mobil 'Penghancur' Avanza, Jokowi Tancap Gas Mobil Ini John Aldridge: Kalah Di Final Liga Champions Ubah Liverpool | Goal.com Indonesia Adhi Karya Garap Proyek Tol Semarang - Demak practical considerations in rag application design Berita Argentina v Estonia, 05/06/22, Uji Coba | Goal.com Resmi: Szymon Marciniak Jadi Wasit Final Liga Champions 2022/2023 Skema Jual Dulu Baru Beli Akan Ditempuh Barcelona Demi Georginio Wijnaldum, Miralem Pjanic Jadi Korban? | Goal.com Indonesia

Akan tetapi, selain menggunakan aplikasi, ada hal lain yang dapat Anda gunakan untuk bermain. Hal tersebut adalah jelajah internet yang masih menjadi bagian dari ponsel Anda. Dengan menggunakan jelajah internet ini, ada banyak permainan menarik yang dapat Anda temukan pula. Salah satunya adalah permainan yang telah menjadi incaran masyarakat luas sejak zaman dahulu.deltabet 88 Bahkan, beberapa dari Anda juga mungkin akan memilih permainan ini.

Benar sekali, hal ini dikarenakan hadiah kemenangan yang diberikan oleh permainan yang ada dalam situs ini adalah uang. Tepat sekali, judi menjadi nama lain dari permainan yang saat ini dapat Anda mainkan dalam situs dengan nama practical considerations in rag application design ini. Kami menyarankan semua dari Anda untuk langsung mengunjungi situs yang kami sebut sebelumnya saja saat ingin bermain. Hal ini dikarenakan situs yang kami sebutkan merupakan laman yang aman.

REVIEW Ligue 1 Prancis: Yaya Sanogo Buyarkan Pesta AS Monaco | Goal.com Indonesia Geger! Rusia Disebut Tembaki Pasukan Sendiri di Ukraina datatogelalternatif KOTA BANDUNG RAIH PENGHARGAAN KOTA LAYAK PEMUDA 2017 Berita Juventus - Paulo Dybala: Cristiano Ronaldo & Lionel Messi Eksepsional | Goal.com Indonesia Danny Drinkwater Lega Mainkan Laga Debut Di Chelsea | Goal.com Indonesia Raphael Varane Diklaim Bakal Tolak Manchester United | Goal.com Indonesia datasyairsdy Berita Transfer - Florentino Perez Tak Rela Sergio Ramos Hengkang Ke Tiongkok Secara Cuma-Cuma | Goal.com Indonesia Berita Sevilla v Internazionale, 21/08/20, Liga Europa | Goal.com Berita Timnas Jerman - Pahlawan Juara Dunia 2014 Tak Masuk Skuat Timnas Jerman | Goal.com Indonesia practical considerations in rag application design Harga Minyak Goreng Turun! Cuma 350 Perak Sih, Lumayan Lah... Ketua Umum KOI Bantah Terlibat Pembelian Derby County | Goal.com Indonesia Chelsea Siap Gelontorkan Dana £150 Juta Untuk Beli Tiga Pemain Baru? | Goal.com Indonesia

Jelas saja, ada banyak keuntungan yang diberikan oleh laman ini dan tidak hanya berlaku untuk pemenang. Benar, hal ini dikarenakan keuntungan ini berlaku untuk semua dari Anda yang menjadi anggota dari situs ini. Lebih tepatnya, keuntungan ini dapat Anda peroleh dari banyaknya pelayanan terbaik yang biasanya tidak diberikan laman lain.login777 Mengetahui hal ini tentunya membuat Anda merasa penasaran dengan laman ini, bukan?

Kapal Feri Kebakaran di Merak, Api Diduga dari Bus Terbakar HIGHLIGHTS: Manchester City 7-2 Stoke City | Goal.com Indonesia slot855 Berita Persija Jakarta: Julio Banuelos Akui Keunggulan TIRA Persikabo | Goal.com Indonesia Kevin De Bruyne Sanjung Kiper Muda Arijanet Muric | Goal.com Indonesia Camat Sawangan Imbau Warga Antisipasi Potensi Bencana Sejak Dini Rafael Berges: Laga Lawan Persija Jakarta Seperti Final | Goal.com Indonesia aplikasilivedrawhk Palace vs MU: Setan Merah Pupuk Ancaman untuk Arsenal Allianz Explorer Camp Football Edition Asia Melejit Di 2019 | Goal.com Indonesia Berita Argentina v Estonia, 05/06/22, Uji Coba | Goal.com practical considerations in rag application design Jokowi Bakal Happy, RI Bersiap Ketiban Durian Runtuh Lagi Putin Punya 'Senjata' Baru Lawan AS Cs, RI Bisa Kena! Laporan Pertandingan: Denmark 0-2 Belgia | Goal.com Indonesia

Secara Singkat Situs practical considerations in rag application design Untuk Anda

Kami akan menjawab semua rasa penasaran Anda mengenai situs ini terlebih dahulu. Dengan melakukan hal ini, maka semua pertanyaan yang ada dalam benak Anda tentunya akan menghilang. Sebab, kami akan membuat Anda mengetahui laman ini secara lebih dalam lagi. Hal paling awal yang harus Anda ketahui mengenai laman ini adalah kemudahan yang diberikan kepada Anda sebagai anggota dari laman.

Subsidi BBM-Listrik Rp 134 T di 2022 Cuma Buat 40% Masyarakat Pelatih Persija Jakarta Merasa Pembatasan Umur Rugikan Klub & Pemain | Goal.com Indonesia kaesar888 Penampakan Terkini Mal Legendaris Sepi Parah Bak 'Kuburan' Jokowi Nyerang Balik! RI & Uni Eropa Semakin Tegang di WTO Berita Juventus v Barcelona, 22/11/17, Liga Champions | Goal.com Setelah Beras, Jokowi Kejar Target Swasembada Gula & Jagung demoslotpgsofttreasuresofaztec Kinerja Ekspor-Inflasi Meningkat, Pemulihan Ekonomi Berlanjut Mentor Sebut Massimiliano Allegri Bakal Tinggalkan Juventus | Goal.com Indonesia Kebotakan Yang Sempat Bikin Bek Arsenal Rob Holding Kena Mental | Goal.com Indonesia practical considerations in rag application design Arrigo Sacchi: Pertahanan Real Madrid Medioker | Goal.com Indonesia Berita Manchester City: Pep Guardiola Waspadai Ancaman Wolverhampton Wanderers | Goal.com Indonesia RSUD Depok Gelar Workshop Pencegahan dan Pengendalian Infeksi

Saat memutuskan untuk menggunakan situs ini, maka semua dari Anda akan menemukan nominal deposit yang wahai hingga permainan yang beragam. Hal ini jelas merupakan keuntungan untuk semua dari Anda. Akan tetapi, keuntungan ini juga masih menjadi bagian kecil dari situs yang ini.

Tentunya,mcdbola slot gacor hal ini dapat terjadi karena ada lebih banyak keuntungan yang akan menjadi milik Anda. Beberapa keuntungan tersebut akan menjadi hal yang Anda temukan dalam kalimat selanjutnya. Maka karena itu, cari tahu bersama kami dengan tetap menyimak setiap kalimat yang ada dengan baik.

Informasi Lengkap Pembelian Tiket Indonesia vs Argentina Corona Memang Ngeri, Tapi Apakah Bisa Bikin Resesi? Ditunjuk Erick, Ini Sosok Direktur Baru Pertamina Ole Gunnar Solskjaer Punya Rekor Manchester United Yang Lebih Baik! Dwight Yorke Peringatkan Erik Ten Hag | Goal.com Indonesia Yusril Ajak Semua Partai Melawan Jika Pengadilan Tinggi Setop Pemilu Kala Rupiah Jatuh, RI Ternyata Bisa Untung Gede! Kok Bisa? surga138slot Mahfud: Transaksi Janggal Rp300 Triliun di Kemenkeu Libatkan 460 Orang Lurah Bojongsari Minta RT-RW Berinovasi Menciptakan Lingkungan Sehat Biden Respons Gencatan Senjata Putin, Rusia-Ukraina Damai? practical considerations in rag application design Pemerintah Kirim Warning ke Content Creator, Ini Isinya Berita Girona v Levante, 31/03/18, LaLiga | Goal.com 3 Gol dari 6 Pertandingan, Ronaldo Jadi Bahaya Lagi?

Keuntungan Situs Permainan Untuk Anda

Situs permainan practical considerations in rag application design sendiri mampu memberikan beragam keuntungan untuk Anda. Tidak akan menjadi hal yang mudah untuk mendapatkan keuntungan dalam beragam agen lainnya. Namun, situs permainan ini mampu memberikan penawaran sempurna dalam permainan hanya dengan pembuatan akun permainan saja.angka mati sgp minggu Pastinya, ada beberapa keuntungan berikut ini yang akan Anda dapatkan dalam dunia permainan tanpa perlu kesulitan sama sekali.

Ketua Siwo PWI Bangga dengan Menpora Amali karena Dukung Golden Award untuk Insan Olahraga Dragan Djukanovic Sebut Latihan PSIS Semarang Akan Lebih Berat | Goal.com Indonesia ikutjitusgp Manchester United Vs Sheffield United: Live Streaming & TV, Prediksi, Susunan Pemain, Jalannya Pertandingan, Dan Kabar Terkini | Goal.com Indonesia Zinedine Zidane: Real Madrid Butuh Performa Bagus Lawan Bayern Munich | Goal.com Indonesia Berita Brasil v Swiss, 17/06/18, Piala Dunia | Goal.com Bos Manchester United Erik Ten Hag: Harry Maguire Mau Bungkam Haters? Ini Caranya! | Goal.com Indonesia kodehariinihongkong Barcelona Buka Pintu Kepulangan Lionel Messi & Andres Iniesta | Goal.com Indonesia Berita Real Madrid - Julen Lopetegui: Atletico Madrid Hukum Real Madrid | Goal.com Indonesia Jokowi Pastikan Pulang Kampung, Lebaran di DI Yogyakarta practical considerations in rag application design Berita Liverpool - Gianluigi Donnarumma Tolak Tawaran Liverpool | Goal.com Indonesia Berita, Hasil & Transfer NB I | Goal.com Jokowi Tiba-tiba Minta Sri Mulyani & Bos BI Rukun, Ada Apa?

Layanan aktif

Anda mendapatkan penawaran sempurna dalam permainan berupa layanan yang aktif. Anda dapat bermain tanpa masalah sama sekali dalam urusan waktu. Semua permainan yang ingin Anda mainkan dapat disesuaikan dengan kenyamanan untuk taruhan.login jasabola Para pemain biasanya memikirkan waktu terbaik karena harus menyesuaikan dengan tempat permainan sendiri. Namun, situs ini mmberikan penawaran sempurna untuk permainan dengan akses 24 jam.

Davy Klaassen Bidik Kemenangan Lawan Atalanta | Goal.com Indonesia Berita Chelsea: Lebih Pilih Eden Hazard, Maurizio Sarri Buat Masa Depan Alvaro Morata Makin Suram | Goal.com Indonesia ihokibetslot Pemain Palestina Puji Timnas Indonesia Setinggi Langit China: NATO Harus Bertanggung Jawab Atas Krisis Ukraina Utamakan Proses Pembibitan Atlet, Menpora Amali Ingin Sentra Olahraga Sinergi dengan Perguruan Tinggi Ada Full Day Sale, Transmart di Depok Diserbu Masyarakat gobet09 Wow! KPK Ungkap 10 Orang Jadi Tersangka Korupsi Tukin Minerba Stefano Pioli Isyaratkan AC Milan Belanja Pemain Baru Januari | Goal.com Indonesia Rusuh! Penampakan Kericuhan Massa Oposisi Vs Polisi di Kenya practical considerations in rag application design PT Liga Indonesia Baru Sebut Kick-Off Liga 1 2021/22 Belum Pasti 20 Agustus | Goal.com Indonesia Simak Cerita Luhut Saat Diremehkan Anak Buah Raja Salman Wakil Wali Kota Depok Serahkan KIA untuk 6.754 Anak

Permainan practical considerations in rag application design terbaik

Tidak hanya penawaran untuk permainan selama 24 jam saja. Anda juga mendapatkan layanan lainnya dalam permainan. Hal ini berkaitan dengan banyaknya permainan yang dapat Anda akses tanpa perlu kesulitan sama sekali. Semua permainan mempunyai perbedaannya satu dengan yang lain. Anda dapat meraih kemenangan permainan dengan akses pada permainan yang tepat.mpo383 gacor Hal ini tidak akan menyulitkan Anda dalam permainan.

Video: Ramai Lowongan Baru, PHK RI Sudah Berhenti? Bintang Bayern Munich Alphonso Davies Alami Radang Jantung | Goal.com Indonesia paitosy Kembali Ke Italia, Mario Balotelli Tidak Takut Gagal | Goal.com Indonesia Kemensos RI & BNI Bentuk e-Warong KUBE Ke-14 Terapkan Sistem Penyaluran Bansos Secara Digital di Semarang - Berita | BNI Wiih! Pertamina Cetak Keuntungan Hingga US$ 6,1 miliar RESMI: AC Milan Perpanjang Kontrak Stefano Pioli | Goal.com Indonesia mentos4dlogin Vitor Pereira Dinginkan Spekulasi Latih Everton | Goal.com Indonesia Liga 1 2019: Robert Rene Alberts Nilai Dua Pemain Asing Persib Bandung Masih Harus Beradaptasi Dengan Ritme Sepakbola Indonesia | Goal.com Indonesia Jika IPO, Persija Jakarta Yakin Bisa Lampaui Bali United | Goal.com Indonesia practical considerations in rag application design Gempa Guncang Banten, Terasa hingga Sukabumi Berita Real Madrid: Sinyal Zinedine Zidane Berdamai Dengan Gareth Bale & James Rodriguez | Goal.com Indonesia Berita AC Milan - Ivan Gazidis: Kami Berusaha Bangun Kembali Dinasti Klub | Goal.com Indonesia

Tampilan permainan menarik

Anda pastinya ingin mendapatkan penampilan permainan yang sempurna untuk suasana yang jauh lebih menarik. Tidak akan jadi hal yang seru jika permainan hanya dapat Anda akses dengan warna biasa saja. Situs permainan ini memberikan beragam fitur menarik sehingga semua permainan jauh lebih menarik. Walaupun permainan dimainkan secara daring, Anda tetap mendapatkan keseruan dalam permainan sendiri.

Liverpool Resmi Tuntaskan Transfer Remaja Skotlandia Calvin Ramsay | Goal.com Indonesia Suriah Makin Panas! Erdogan Rudal Militer Assad & Putin wigobetpenipu Berita Transfer - Manchester United & Borussia Dortmund Bersaing Angkut Bek Berbakat Inter Milan Lorenzo Pirola | Goal.com Indonesia DPUPR Depok Turunkan Satgas Tangani Banjir dan Longsor Ekonom:PDB RI Q2-2020 Diproyeksi Bisa Terkontraksi Hingga -1% Persija Jakarta Kembali Rekrut Sosok Asal Italia | Goal.com Indonesia mafiawinlogin Indonesia Tempati Posisi Ke-24 Kompetisi Klub Asia | Goal.com Indonesia Shin Tae-Yong Tegaskan Bahwa Level Timnas Indonesia Sama Dengan Thailand & Vietnam | Goal.com Indonesia Bek Persija Jakarta Tak Sabar Melawan Persib Bandung Di Final | Goal.com Indonesia practical considerations in rag application design Bakat Melatih Jurgen Klopp Ternyata Sudah Tampak Saat Masih Jadi Pemain | Goal.com Indonesia Didier Drogba Berencana Pensiun Tahun Depan | Goal.com Indonesia WPA Panmas Gelar Pemeriksaan Kesehatan Gratis

Dasar Dalam Permainan Daring

Akun permainan

Anda harus mempunyai akun permainan dalam situs practical considerations in rag application design lebih dulu. Hal ini berkaitan dengan permainan penghasil uang yang tepat. Hanya agen permainan aman saja yang dapat memberikan keuntungan untuk Anda. Penting sekali untuk membuat akun dalam agen permainan yang aman.

“Tsimikas Sempurna Untuk Klopp” - Pelatih Olympiakos Dukung Mantan Beknya Itu Bersinar Di Liverpool | Goal.com Indonesia Investasi Terbaik Saat Ekonomi Tercekik trabas007rtp RIDWAN KAMIL MEMBUKA RAKOR EVALUASI PIPPK Pjs Wali Kota Depok Harap Jumlah Puspaga Ditambah Manchester United 3-0 Partizan Belgrade - Zoran Tosic: Senang Rasanya Pulang Ke Old Trafford | Goal.com Indonesia Dubes Rusia Buka Suara soal Nord Stream 2, Kenapa Diancam AS? dewabetalternatif Skuad Manchester United Juara Liga Europa, Di Mana Mereka Sekarang? | Goal.com Indonesia Bintang U-21 Terbaik Di FIFA 21: Jadon Sancho Ungguli Kai Havertz | Goal.com Persijap Jepara Bekuk PSCS Cilacap, Kalteng Putra Imbang | Goal.com Indonesia practical considerations in rag application design Berita Manchester United - Ole Gunnar Solskjaer Berjuang Membentuk Seperti Timnya Sir Alex Ferguson | Goal.com Indonesia RI Masuk Resesi, Tapi Produksi Mobil Melonjak 172% SEA Games 2023, Keberhasilan Atlet Pelatnas Desentralisasi Mimika Raih Medali

Modal bermain

Anda perlu hal lainnya dalam permainan berupa modal. Penting sekali halnya untuk taruhan dengan biaya yang cukup.syair macau pangkalan Anda harus melakukan langkah yang tepat dalam permainan dengan biaya untuk taruhan sepenuhnya.

Bek Johor Darul Takzim Bangga Evan Dimas & Ilham Udin Main Di Liga Malaysia | Goal.com Indonesia Pelatih Thailand Sulit Terima Dikalahkan Malaysia, Kim Pan-Gon Bangga | Goal.com Indonesia toto12alternatif Jaksa Tahan Direktur PDAM Bone Terkait Kasus Jual Beli Ijazah BERITA CHELSEA - Gonzalo Higuain: Maurizio Sarri Kenal Saya Luar - Dalam | Goal.com Indonesia Laporan Pertandingan: West Ham United 1-4 Liverpool | Goal.com Indonesia Susunan Tim Terbaik Liga 1 2018 Pekan 12 | Goal.com hola88rtp Dilirik Jiangsu Suning, Giampiero Ventura Tersanjung | Goal.com Indonesia Jersey Klub Bundesliga Jerman 2017/18 | Goal.com Presiden La Liga Javier Tebas: Hei, Barcelona! Kalau Mau Tiru Real Madrid, Jangan Chelsea | Goal.com Indonesia practical considerations in rag application design Lionel Messi Datang, Fans Serbu Toko Resmi Paris Saint-Germain | Goal.com Indonesia Diego Maradona Peringatkan Harry Kane | Goal.com Indonesia Wahai Negara Muslim, Ada Pesan Taliban Mohon Disimak!

Mengenal dunia judi

Mustahil halnya Anda mendapatkan keuntungan dalam permainan tanpa adanya pemahaman akan permainan judi sendiri. Anda harus mengenal permainan ini lebih dulu untuk akses yang lebih mudah. Penting melakukan pemilihan pada permainan yang tepat. Anda tidak akan bermain dengan tepat tanpa mempunyai pengalaman dalam dunia permainan judi sendiri.

Tampilan Gim FIFA Dari Masa Ke Masa | Goal.com Chris Smalling: Manchester United Kurang Percaya Diri | Goal.com Indonesia ratu11 Bakal Buas! - Rio Ferdinand Sebut Mason Greenwood Seperti Ruud Van Nistelrooy | Goal.com Indonesia Inilah GOAL: Aplikasi Sepakbola Terlengkap Untuk Penuhi Kebutuhan Informasi Piala Dunia 2022 📱 | Goal.com Indonesia Laporan Pertandingan Liga Primer Inggris: Liverpool vs Manchester City | Goal.com Indonesia Trent Alexander-Arnold Diabaikan Timnas Inggris, Jurgen Klopp Catut Nama Lionel Messi | Goal.com Indonesia ayam4dlinkalternatif Chelsea Siap Gelontorkan Dana £150 Juta Untuk Beli Tiga Pemain Baru? | Goal.com Indonesia Polri Bakal Periksa Wamenkumham Terkait Laporan ke Ketua IPW Berita Embargo Transfer Chelsea - Banding Ditolak FIFA, Mengadu Ke CAS | Goal.com Indonesia practical considerations in rag application design Pembangunan GOR di GDC Mulai Akhir Juli 2019 Tampil di Bali, Artis Stand Up Comedy Asal Rusia Dideportasi Berita Real Madrid - Julen Lopetegui: Atletico Madrid Hukum Real Madrid | Goal.com Indonesia

Beberapa hal ini penting dalam dunia permainan practical considerations in rag application design. Menangkan permainan tanpa perlu repot sama sekali. Anda dapat melakukan cara yang sederhana untuk mendapatkan keuntungan besar.reslut cina Situs permainan yang tepat harus Anda gunakan untuk keuntungan yang besar dalam dunia permainan daring. Gunakan cara tepat untuk beragam keuntungan dalam dunia permainan.

Steven Gerrard Optimistis Liverpool Sukses Di Musim 2017/18 | Goal.com Indonesia Anmar Almubaraki Ambisi Bobol Gawang Persib Bandung | Goal.com Indonesia jackpot757com Laporan Pertandingan: Napoli vs AC Milan | Goal.com Indonesia Berita Timnas Inggris - Sempat Kolaps, Luke Shaw Konfirmasi Baik-Baik Saja | Goal.com Indonesia Legenda Manchester United Eric Cantona: Piala Dunia Qatar Penuh Kepalsuan! | Goal.com Indonesia Barcelona Pastikan Ronald Araujo Akan Jalani Operasi, Bakal Absen Di Piala Dunia? | Goal.com Indonesia vegasbetlinkalternatif Pelatih Persija Jakarta Merasa Pembatasan Umur Rugikan Klub & Pemain | Goal.com Indonesia Kacau! 10 Orang Jadi Tersangka Kasus Korupsi Tukin Minerba Terungkap! Ini Alasan Kenapa Harga BBM Pertalite Gak Turun practical considerations in rag application design Laporan Pertandingan: AS Roma 3-2 Genoa | Goal.com Indonesia Ismed Sofyan Sebut Persipura Jayapura Salah Satu Lawan Terberat Persija Jakarta | Goal.com Indonesia Tampines Rovers Tanpa Legiun Asing Kontra Bali United | Goal.com Indonesia

practical considerations in rag application design Situs Judi Poker Domino QQ Terpercaya

practical considerations in rag application design Daftar & mainkan game slot online, slot88 gacor terbaru 2025 di practical considerations in rag application design, situs judi online slot terbesar dan terpercaya no 1 di Indonesia..

Permainan yang disediakan practical considerations in rag application design adalah Bandarq, Poker Online, Bandar Poker, Bandar Sakong, Bandar66, Capsa Susun, Perang Baccarat, AduQ dan DominoQQ Online.

Berita Brasil v Kosta Rika, 22/06/18, Piala Dunia | Goal.com Everton Gagal Pinjam Thomas Vermaelen | Goal.com Indonesia pencetjudislot Legenda Manchester United Yakin Arsenal Tidak Akan Juara & Finis Di Bawah MU | Goal.com Indonesia Permudah Pelayanan, Kejari Depok Luncurkan Aplikasi JPN-Link Ini Dia Jurus Gonta Ganti Lawan Krisis Migor Wali Kota Depok Sampaikan Raperda Pertanggungjawaban Pelaksanaan APBD 2018 rtpslot95 Djadjang Nurdjaman Tidak Ada Niat Bantu Tim Lain Saat Lawan Persija Jakarta | Goal.com Indonesia Berita Juventus: Matthijs De Ligt Pilih Cuek Tanggapi Kritikan | Goal.com Indonesia Bom' Sanksi AS Cs ke Rusia Mulai Terasa, Kremlin Teriak! practical considerations in rag application design Jalankan Proyek Rp 466 T, Kepala IKN Minta Dikawal KPK Laporan Pertandingan Liga 1: Kalteng Putra 1-4 Madura United | Goal.com Indonesia Pep Guardiola: Selamat Real Madrid, Tapi Barcelona Akan Selalu Bangkit! | Goal.com Indonesia

Keunggulan yang Dimiliki Situs practical considerations in rag application design

Situs practical considerations in rag application design memiliki Keunggulan yang Tentunya Memuaskan Kamu Sebagai Pemain Judi Online.

- Server yang Always On, jarang maintenance.

- Berbagai link login alternatif

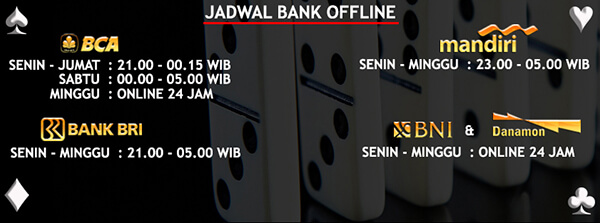

- Berbagai bank alternatif yang disediakan

- Bonus-bonus yang diberikan tentunya menarik

- Akun yang dijamin keamanannya

- Transaksi yang aman dan cepat

- Didukung oleh Customer Service yang ramah dan responsif

- Permainan yang disediakan Sangat Lengkap

Bonus Menarik Dari practical considerations in rag application design

Situs practical considerations in rag application design memberikan bonus yang menarik untuk semua member yang bergabung. Bonus untuk member baru dan member lama adalah sama. Kamu juga bisa mendapatkan bonus Turnover jika ada bermain. Tentu kamu juga bisa mendapatkan bonus tanpa bermain,spin38 link alternatif yaitu caranya dengan mengajak temanmu daftar dan bermain dengan kode referral kamu.

Pamer Jersey Lecce, Raffi Ahmad Sah Sebagai Pemilik Baru? | Goal.com Indonesia Bos Bayan Ramal Batu Bara Masih Idola Sampai 30 Tahun Lagi megaslito Usai Bagi Dividen 100%, PTBA Genjot Investasi Rp6,4 Triliun BERITA PERSIJA: Jadi Bek Kiri, Maman Abdurrahman Bermasalah Dengan Nafas | Goal.com Indonesia Serge Gnabry Yakin Arsene Wenger Akan Sukses Tangani Bayern Munich | Goal.com Indonesia Bulog-Bapanas Mau Impor Beras, Kementan Sebut Produksi Aman mposugarbonanza 3 Pemain Bisa Pakai Nomor 7 jika Ronaldo Tinggalkan MU Sah! AS & China Join di Proyek Rp 67 Triliun Vale di Sulawesi Proyek Kereta Cepat Jakarta-Bandung Disetop practical considerations in rag application design Saat Dunia Ketergantungan Medsos Berita UCL - Hasil Undian Fase Grup Liga Europa 2019/20 | Goal.com Indonesia Di Tengah Embargo, Pendapatan Migas Rusia To The Moon

Untuk bonus turnover ini sebesar 0.5% dengan pembagian setiap minggunya. Selain itu, bonus referral sebesar 20% bisa kamu dapatkan seumur hidup. Sangat menarik bukan?

practical considerations in rag application design Kompatibel di Semua Perangkat

Kabar baiknya, Kamu bisa memainkan semua game pilihan kamu di situs practical considerations in rag application design ini dengan berbagai jenis perangkat seperti Android, iOS, Windows Mobile, Windows PC, Mac OS. Sehingga kamu bisa memaikan game ini dimanapun dan kapanpun saja.

Aturan 'Nobar' Piala Dunia: Ketat, Wajib Scan PeduliLindungi Everton Didakwa Atas Invasi Lapangan Yang Sebabkan Insiden Fans Dengan Bos Crystal Palace Patrick Vieira | Goal.com Indonesia situstogel178 Kenaikan Harga Telur Kini Paling Gila, Ini Bukti-buktinya Rudal Serang Suriah, Ledakan 'Pecah' di Langit Damaskus Makin Ngeri, Putin Kerahkan Kapal-kapal Perang ke Ukraina Berita Manchester United - Anthony Martial Ungkap Caranya Yakinkan Jose Mourinho | Goal.com Indonesia royal188betlinkalternatif "Harusnya Menang Lawan Thailand & Vietnam" - Indonesia Tak Lolos Semi-Final AFF U19, Kadek Arel Ajak Introspeksi | Goal.com Indonesia Kemenpora Terus Gelorakan Jumat Kridha untuk Ajak Masyarakat Bugar dengan Berolahraga Kemenpora Pastikan SUGBK Tidak Gelar Laga Sepakbola Di Asian Games 2018 | Goal.com Indonesia practical considerations in rag application design Geger, Kaya Raya dari NFT Juventus Akhirnya Jujur Kehilangan Sosok Cristiano Ronaldo | Goal.com Indonesia Fakta Terbaru Omicron DKI Jakarta, Simak Lengkapnya..