researchers from eth zurich have developed ultrafastbert a bert variant that achieves comparable | Anime Lengkap Sub Indonesia rupython

Yuk, Intip Lebih Dalam Situs researchers from eth zurich have developed ultrafastbert a bert variant that achieves comparable Yang Berkualitas

PSSI Apreasiasi Program Sosialisasi Youth Fun Juggling Competition | Goal.com Indonesia Ramai Biaya Kereta Cepat Jakarta-Bandung Membengkak, Berapa? sinyalhilangxiaomiredmi2 Video: Bye Covid-19! Festival Ramadan Dubai Kembali Dibuka Harga Avtur Melonjak, Muncul Fenomena Transit dan Rute Kosong Manusia £84 Juta Ini Siap Mendarat Di Arsenal Gantikan Pierre-Emerick Aubameyang | Goal.com Indonesia Keren! Buruan Sae Jadi Sorotan Mata Internasional indexemashariini Deretan Gol Telat Di Piala Dunia 2018 | Goal.com Tak Hanya Jakarta, Kawasan Pantura Diprediksi Bakal Tenggelam Kenapa Pemain Liga Inggris Sulit Dapat Ballon d'Or? researchers from eth zurich have developed ultrafastbert a bert variant that achieves comparable Cuma Ada Satu Tawaran - Alasan Bernardo Silva Bertahan Di Manchester City Meski Diincar Barcelona | Goal.com Indonesia Kompetisi Dihentikan, Liverpool Akan Dinobatkan Sebagai Juara | Goal.com Indonesia Sekjen PSSI Minta Masyarakat Jangan Mudah Terprovokasi | Goal.com Indonesia

Yuk, Intip Lebih Dalam Situs researchers from eth zurich have developed ultrafastbert a bert variant that achieves comparable Yang Berkualitas! Bermain tentunya menjadi salah satu kegiatan dari sedikitnya kegiatan menyenangkan yang dapat Anda lakukan. Jelas saja,researchers from eth zurich have developed ultrafastbert a bert variant that achieves comparable berbeda dengan bekerja, saat bermain semua beban yang ada dalam benak Anda akan menghilang. Maka karena itu, menjadi hal yang sangat wajar bila saat ini semua dari Anda dapat menemukan aplikasi permainan di ponsel dengan mudah.

Tes CPNS Dibuka Juni, Cek Jadwal & Kriteria yang Dibutuhkan Cerita Momen Ketegangan Final SEA Games 2023 dari Sudut Pandang Kapten Rizki Ridho yamahaaeroxbekasbandung Genjot Ekonomi 5,8% di 2022, RI Butuh Investasi Rp 5.900 T Tianjin Quanjian Belum Berhenti Kejar Diego Costa | Goal.com Indonesia Jokowi Resmikan Bendungan Tapin Kalimantan Selatan Rp986 M Persiba Balikpapan Buka Seleksi Besar-Besaran | Goal.com Indonesia lagulagumaherzain Shin Tae-Yong Panggil Kiper PSIS Semarang Ke TC Timnas Indonesia U-19 | Goal.com Indonesia Saya Ingin Pensiun Di Sini - Karim Benzema Ucapkan Selamat Tinggal Kepada Real Madrid | Goal.com Indonesia Pegawai Mangkir Kerja Pasca Cuti Lebaran Bisa Rusak Kepercayaan Masyarakat researchers from eth zurich have developed ultrafastbert a bert variant that achieves comparable STY: Zanadin Fariz Tak Bisa Main di Piala Asia U-20 Persita Mau Santai Dulu Habis Menang, Persik Menolak Disebut Main Jelek | Goal.com Indonesia Barcelona vs MU: Antisipasi Lionel Messi, David De Gea Jalani Persiapan Super Spesial | Goal.com Indonesia

Akan tetapi, selain menggunakan aplikasi, ada hal lain yang dapat Anda gunakan untuk bermain. Hal tersebut adalah jelajah internet yang masih menjadi bagian dari ponsel Anda. Dengan menggunakan jelajah internet ini, ada banyak permainan menarik yang dapat Anda temukan pula. Salah satunya adalah permainan yang telah menjadi incaran masyarakat luas sejak zaman dahulu.kucing tak kunjung melahirkan Bahkan, beberapa dari Anda juga mungkin akan memilih permainan ini.

Benar sekali, hal ini dikarenakan hadiah kemenangan yang diberikan oleh permainan yang ada dalam situs ini adalah uang. Tepat sekali, judi menjadi nama lain dari permainan yang saat ini dapat Anda mainkan dalam situs dengan nama researchers from eth zurich have developed ultrafastbert a bert variant that achieves comparable ini. Kami menyarankan semua dari Anda untuk langsung mengunjungi situs yang kami sebut sebelumnya saja saat ingin bermain. Hal ini dikarenakan situs yang kami sebutkan merupakan laman yang aman.

Ramalan 'Merinding' 2023 dari Nostradamus sampai Baba Vanga AFF Futsal Cup 2019: Black Steel Imbangi Klub Kuat Thailand | Goal.com Indonesia aplikasimelacaknohp Berita Internazionale v Benevento, 30/01/21, Serie A | Goal.com Harga Minyak Dunia Anjlok, BBM Bisa Turun Bu Sri Mulyani? Ivar Jenner dan Justin Hubner Gembira Ria Ikut Latihan Timnas U-20 Liverpool vs Arsenal: Anfield Jadi Kuburan The Gunners? pampershuggies Penampakan Harta Karun Super Langka RI, Jadi Rebutan Asing! Jokowi Sudah Wanti-wanti, Ini Jalur Favorit Perjalanan Nataru Persib Bandung Tanpa Dua Pemain Asing Ke Makassar | Goal.com Indonesia researchers from eth zurich have developed ultrafastbert a bert variant that achieves comparable Gelar Youth Creativepreneur Workshop, Kemenpora Harap Pemuda Tetap Kreatif Ditengah Pandemi Covid-19 Menghidupkan Pariwisata Indonesia Pasca Merebaknya Corona Terus Bertambah, Total Pasien Corona Tewas di Iran 354 Orang

Jelas saja, ada banyak keuntungan yang diberikan oleh laman ini dan tidak hanya berlaku untuk pemenang. Benar, hal ini dikarenakan keuntungan ini berlaku untuk semua dari Anda yang menjadi anggota dari situs ini. Lebih tepatnya, keuntungan ini dapat Anda peroleh dari banyaknya pelayanan terbaik yang biasanya tidak diberikan laman lain.cara mengaktifkan developer option Mengetahui hal ini tentunya membuat Anda merasa penasaran dengan laman ini, bukan?

Jokowi Minta Tak Ada PHK, Tanggapan Pengusaha Bikin Kaget Jokowi Larang Mudik, Produsen Mobil Ngaku Tak Kaget! kawatjaringgalvanis Menang Tipis Atas Leicester City, Diego Simeone: Leg Kedua Akan Sulit | Goal.com Indonesia 3 Pemain Bidikan STY untuk Timnas Indonesia yang Gacor di Eropa Alfredo Vera Berperan Besar Dalam Karier Osvaldo Haay | Goal.com Indonesia Manchester United, Milan, Arsenal: Sepuluh Klub Terboros Di Bursa Transfer Musim Panas 2021 Sejauh Ini | Goal.com Indonesia caramembuattaugeuntukdijual Calvin Ramsay: Wonderkid Skotlandia Yang Diminati Klub Inggris & Italia | Goal.com Indonesia Dani Ceballos, Berita Terkini & Profil Pemain | Goal.com Zinedine Zidane: Semua Orang Cinta Isco | Goal.com Indonesia researchers from eth zurich have developed ultrafastbert a bert variant that achieves comparable Final Piala AFF 2022: Kondisi Teerasil Dangda Masih Misterius Mahfud: Kasus Korupsi BTS Johnny Plate Tak Terkait Calon di Pilpres Anak Unggah Foto Mengharukan Pele, Rayakan Natal di Rumah Sakit

Secara Singkat Situs researchers from eth zurich have developed ultrafastbert a bert variant that achieves comparable Untuk Anda

Kami akan menjawab semua rasa penasaran Anda mengenai situs ini terlebih dahulu. Dengan melakukan hal ini, maka semua pertanyaan yang ada dalam benak Anda tentunya akan menghilang. Sebab, kami akan membuat Anda mengetahui laman ini secara lebih dalam lagi. Hal paling awal yang harus Anda ketahui mengenai laman ini adalah kemudahan yang diberikan kepada Anda sebagai anggota dari laman.

China Minggir, Ini 'Raja' Baru Pemberi Utang RI Cs Berita Manchester United: Pukul Arsenal, Ole Gunnar Solskjaer Teringat Kenangan Indah Masa Lalu | Goal.com Indonesia shoopeexpresshemat Berita EPL - Mohamed Diame: Newcastle United Bisa Kalahkan Manchester United | Goal.com Indonesia Makin Sengit! Rusia Masuk, Ledakan & Baku Tembak di Kyiv Pele & 20 Pencetak Gol Terbanyak Sepanjang Masa | Goal.com Daftar Tamu yang Disambut Jokowi Pada Hari Pertama KTT G20 warnarambutabusilver Menpora Imam Nahrawi: Bonus Untuk Timnas Indonesia U-22 Rp2,1 Miliar! | Goal.com Indonesia RI Tetap Undang Rusia di G20, Pengamat: Langkah Tepat Perluas Jangkauan, Puskesmas Cilangkap Beri Penyuluhan Kesehatan Lewat Instagram researchers from eth zurich have developed ultrafastbert a bert variant that achieves comparable Menteri PUPR Kejar 10 Proyek KPBU, Ada Tol Dalam Kota Bandung Diler Panik, Diskon Rp 70 Juta Makin Lama Mobil Tak Laku! Berita Transfer - RESMI: Paris Saint-Germain Rekrut Wonderkid Xavi Simons | Goal.com Indonesia

Saat memutuskan untuk menggunakan situs ini, maka semua dari Anda akan menemukan nominal deposit yang wahai hingga permainan yang beragam. Hal ini jelas merupakan keuntungan untuk semua dari Anda. Akan tetapi, keuntungan ini juga masih menjadi bagian kecil dari situs yang ini.

Tentunya,biznet per bulan hal ini dapat terjadi karena ada lebih banyak keuntungan yang akan menjadi milik Anda. Beberapa keuntungan tersebut akan menjadi hal yang Anda temukan dalam kalimat selanjutnya. Maka karena itu, cari tahu bersama kami dengan tetap menyimak setiap kalimat yang ada dengan baik.

Striker FC Porto Toni Martinez: Usia 38 Tahun, Tapi Bek Portugal Pepe Bermain Seperti Pemain 25 Tahun | Goal.com Indonesia Tinggal Tunggu Waktu Saja! Arsenal Makin Dekat Dengan Finalisasi Transfer Mykhailo Mudryk | Goal.com Indonesia Dikritik Anies, Jokowi Dibela Pengusaha Bangun Banyak Tol Mengapa Banyak Dualisme Di Klub Sepakbola Indonesia? | Goal.com Indonesia Malaysia Suram: Covid Meledak Lagi, Tak Punya Perdana Menteri Penghargaan Parahita Eka Praya (APE) 2014 ukuranrenggentengmetalpasir Bertemu Sekjen AIPA, Puan Dorong Partisipasi Generasi Muda ASEAN Alvaro Morata, Cesc Fabregas & Bintang Spanyol Yang Tersingkir Dari Skuat Piala Dunia 2018 | Goal.com Progres Duo Asing Persebaya Surabaya Berjalan Bagus | Goal.com Indonesia researchers from eth zurich have developed ultrafastbert a bert variant that achieves comparable Jonathan Tah Gantikan Posisi Antonio Rudiger | Goal.com Indonesia Hukuman Baru untuk Rusia, AS Cs Buat Putin 'Kelaparan' Mayjen Nur Alamsyah Resmi Jadi Komandan Korps Marinir

Keuntungan Situs Permainan Untuk Anda

Situs permainan researchers from eth zurich have developed ultrafastbert a bert variant that achieves comparable sendiri mampu memberikan beragam keuntungan untuk Anda. Tidak akan menjadi hal yang mudah untuk mendapatkan keuntungan dalam beragam agen lainnya. Namun, situs permainan ini mampu memberikan penawaran sempurna dalam permainan hanya dengan pembuatan akun permainan saja.pusat oleh oleh khas makassar Pastinya, ada beberapa keuntungan berikut ini yang akan Anda dapatkan dalam dunia permainan tanpa perlu kesulitan sama sekali.

Berita Paris Saint-Germain - Kylian Mbappe Pecahkan Rekor 45 Tahun | Goal.com Indonesia WHO Sisihkan 4,73 Juta Vaksin Kepada Korut, Kim Jong-Un Mau? kueultahuntukanaklakilaki Berita Arsenal - Fenerbahce Bantah Akan Rekrut Mesut Ozil | Goal.com Indonesia Juventus Jajaki Transfer Mesut Ozil | Goal.com Indonesia Djadjang Nurdjaman: Ada Someone Gantikan Elthon Maran | Goal.com Indonesia Berita Persis Solo v Persikabo 1973, 23/01/23, Liga 1 | Goal.com atasyahomestay Laporan Pertandingan Audi Cup: Tottenham Hotspur 2-2 Bayern Munich (Ap. 6-5) | Goal.com Indonesia Barito Putera Awali Piala Indonesia Dengan Mulus | Goal.com Indonesia Paulo Dybala: Gonzalo Higuain Harus Sabar | Goal.com Indonesia researchers from eth zurich have developed ultrafastbert a bert variant that achieves comparable Jose Mourinho Jadi Kandidat Pengganti Mauricio Pochettino Di Paris Saint-Germain | Goal.com Indonesia Berita Persiba Balikpapan v Semen Padang, 21/09/17, Liga 1 | Goal.com Tiba-Tiba Ahok Bertemu Ketua MPR Bamsoet, Ada Apa?

Layanan aktif

Anda mendapatkan penawaran sempurna dalam permainan berupa layanan yang aktif. Anda dapat bermain tanpa masalah sama sekali dalam urusan waktu. Semua permainan yang ingin Anda mainkan dapat disesuaikan dengan kenyamanan untuk taruhan.review masker rambut kering dan mengembang Para pemain biasanya memikirkan waktu terbaik karena harus menyesuaikan dengan tempat permainan sendiri. Namun, situs ini mmberikan penawaran sempurna untuk permainan dengan akses 24 jam.

Patung Ganesha yang Hilang di Bromo Diganti dengan Koleksi Trowulan Jadwal Liga Inggris Hari Ini: Arsenal vs Brentford kegunaanemulsion Manchester United Kembali Dekati Marcelo Brozovic | Goal.com Indonesia Jose Mourinho: Gagal Juara Liga Europa Bukan Berarti Musim Manchester United Buruk | Goal.com Indonesia Hasil Liga Inggris: Main Impresif, MU Hajar Brentford Berita Chemnitzer FC v Bayern Munich, 12/08/17, DFB Pokal | Goal.com obatroyalgurukosaminobatapa Final Bulu Tangkis Putri SEA Games 2023: Febriana/Amalia Kalah, Indonesia Vs Thailand 0-2 Angelo Alessio Terkesan Dengan Penampilan Pemain Muda Persija Jakarta | Goal.com Indonesia LEPAS ATLET KE PON XX PAPUA, ODED: JIKA PULANG BAWA MEDALI, KADEUDEUH MENANTI researchers from eth zurich have developed ultrafastbert a bert variant that achieves comparable Jurgen Klinsmann Kagumi Harry Kane | Goal.com Indonesia Bali United Jadi Penentu Nasib Aji Santoso | Goal.com Indonesia Luke Shaw Comeback Lawan Burton Albion? | Goal.com Indonesia

Permainan researchers from eth zurich have developed ultrafastbert a bert variant that achieves comparable terbaik

Tidak hanya penawaran untuk permainan selama 24 jam saja. Anda juga mendapatkan layanan lainnya dalam permainan. Hal ini berkaitan dengan banyaknya permainan yang dapat Anda akses tanpa perlu kesulitan sama sekali. Semua permainan mempunyai perbedaannya satu dengan yang lain. Anda dapat meraih kemenangan permainan dengan akses pada permainan yang tepat.harga nutrishe intensive bright glow serum Hal ini tidak akan menyulitkan Anda dalam permainan.

Persib Bandung Negosiasi Dengan Klub Luar Negeri Terkait Michael Essien | Goal.com Indonesia Abnormal! AS Roma Kehilangan Tiga Pemain Akibat Cedera Di Babak Pertama Kontra Manchester United | Goal.com Indonesia asuransidibayardimukatermasukakun Livecam Potret Baru Gempa Turki-Suriah: Melukis di Atas Reruntuhan Laporan Pertandingan: Paris Saint-Germain 0-2 Reims | Goal.com Indonesia PDIP Tegaskan Jokowi Dukung Ganjar di Pilpres 2024 bomboogiejeans Kiprah Jan Vertonghen Di Euro 2016 Berakhir | Goal.com Indonesia Video: Hiruk Pikuk Muslim Bangladesh Jelang Hari Raya Jokowi Segera Kirim Bantuan Bagi Korban Gempa Turki & Suriah researchers from eth zurich have developed ultrafastbert a bert variant that achieves comparable Video: Pesawat Jokowi Mungil Diantara Milik Biden-Jinping Siap Dibangun, Begini Penampakan Tol Menuju Kota 'Raksasa' Evaluasi Capaian Tim Indonesia SEA Games 2021 Vietnam Harus Dilakukan Guna Tingkatkan Prestasi Lebih Baik

Tampilan permainan menarik

Anda pastinya ingin mendapatkan penampilan permainan yang sempurna untuk suasana yang jauh lebih menarik. Tidak akan jadi hal yang seru jika permainan hanya dapat Anda akses dengan warna biasa saja. Situs permainan ini memberikan beragam fitur menarik sehingga semua permainan jauh lebih menarik. Walaupun permainan dimainkan secara daring, Anda tetap mendapatkan keseruan dalam permainan sendiri.

Xpora jadi Role Model Berdayakan UMKM Orientasi Ekspor - Berita | BNI Cinta Suam-Suam Kuku Juventini Pada Juventus Era Massimiliano Allegri | Goal.com Indonesia xpandersport2019bekas Julian Draxler: Bayern Munich Pantas Menang | Goal.com Indonesia HIGHLIGHTS: Arsenal 2-1 Swansea City | Goal.com Indonesia Legenda Manchester United Akan Meriahkan Lomba Lari Di Jakarta | Goal.com Indonesia Dorong Serapan Anggaran, Pemda Harap Juklak-Juknis Dipercepat caramengaturjamalexandrechristie West Ham United Bisa Jadi Perahu Thomas Tuchel Untuk Balas Dendam Dengan Chelsea | Goal.com Indonesia Jokowi Tegas Nih! Eksportir Wajib Tahan Dolar 3 Bulan di RI AS Parkir Jet Bomber Dekat Papua, Manas-manasin Korut? researchers from eth zurich have developed ultrafastbert a bert variant that achieves comparable Porto Klaim Juara Primeira Liga Portugal 2019/20 | Goal.com Indonesia "Itu Momen Michael Jordan" - Ole Gunnar Solskjaer Senang Cristiano Ronaldo Jadi Penyelamat Man United | Goal.com Indonesia Sepak Bola Eropa Resmi Tanpa Messi dan Ronaldo

Dasar Dalam Permainan Daring

Akun permainan

Anda harus mempunyai akun permainan dalam situs researchers from eth zurich have developed ultrafastbert a bert variant that achieves comparable lebih dulu. Hal ini berkaitan dengan permainan penghasil uang yang tepat. Hanya agen permainan aman saja yang dapat memberikan keuntungan untuk Anda. Penting sekali untuk membuat akun dalam agen permainan yang aman.

REVIEW Serie A Italia: Sengit, Sassuolo Kontra Fiorentina Berakhir Imbang | Goal.com Indonesia Berita Transfer: Arsenal Ikut Bersaing Dapatkan Piotr Zielinski | Goal.com Indonesia hijabparispesta Agen: Italia & Tiongkok Jadi Opsi Samir Nasri | Goal.com Indonesia Gally Freitas Punya Keinginan Main Di Liga Indonesia | Goal.com Indonesia Berita Spanyol v Argentina, 27/03/18, Uji Coba | Goal.com Penampakan Tol yang Bisa Bikin JKT-Bandung Kurang dari 1 Jam ukuranus10berapacm Pelatih Timnas Indonesia U-22 Takkan Panggil Pemain Baru | Goal.com Indonesia Andrezinho Dicoret, Persela Lamongan Coba Pemain Maroko | Goal.com Indonesia Berita Chelsea - Pelatih Eintracht Frankfurt Siapkan Dua Pemain Kawal Eden Hazard | Goal.com Indonesia researchers from eth zurich have developed ultrafastbert a bert variant that achieves comparable Terburu-Buru Umpan Ke Cristiano Ronaldo, Erik Ten Hag Kecam Permainan Manchester United | Goal.com Indonesia Tiket Penerbangan Blue Origin Laku USD 28 Juta Kim Jong Un Klaim Sukses Coba Drone Nuklir Bawah Laut

Modal bermain

Anda perlu hal lainnya dalam permainan berupa modal. Penting sekali halnya untuk taruhan dengan biaya yang cukup.gamis syar i ceruti Anda harus melakukan langkah yang tepat dalam permainan dengan biaya untuk taruhan sepenuhnya.

Berita Sevilla v Roma, 31/05/23, Liga Europa | Goal.com Javier Mascherano & 20 Pemain Termahal Di Liga Super Tiongkok | Goal.com hitunglahluaspermukaankubus 13 Fakta Unik Mohamed Salah | Goal.com Indonesia Real Madrid Mau Bajak Marcos Alonso Dari Chelsea | Goal.com Indonesia Berita Manchester City - Gabriel Jesus Diyakini Bisa Jadi Salah Satu Pemain Terbaik Dunia | Goal.com Indonesia Pelatih Pastikan FK Senica Tanpa Egy Maulana Vikri & Witan Sulaeman Hingga Akhir Musim | Goal.com Indonesia atomyadalah Tunjukkan Seberapa Besar Kalian Suka Sepakbola! | Goal.com Indonesia Kisah Jonathan Woodgate: Pemain Potensial Liga Primer Inggris Yang Jadi Flop Real Madrid Karena Cedera | Goal.com Indonesia Asnawi Mangkualam Debut Di K2 League, Main Sebagai Penyerang Sayap & Dapat Poin | Goal.com Indonesia researchers from eth zurich have developed ultrafastbert a bert variant that achieves comparable BRI Salurkan Kredit Ramah Lingkungan Rp 562 T di 2020 Tok! Dua Raperda Kota Bandung Disahkan Kevin-Prince Boateng Bertahan Di Las Palmas Lebih Lama | Goal.com Indonesia

Mengenal dunia judi

Mustahil halnya Anda mendapatkan keuntungan dalam permainan tanpa adanya pemahaman akan permainan judi sendiri. Anda harus mengenal permainan ini lebih dulu untuk akses yang lebih mudah. Penting melakukan pemilihan pada permainan yang tepat. Anda tidak akan bermain dengan tepat tanpa mempunyai pengalaman dalam dunia permainan judi sendiri.

Andre Gomes & Deretan Transfer Paling Absurd Musim Panas Ini | Goal.com Potret Sydney Banjir: Jalan Putus, Daratan Berubah Jadi Danau helmtengkorak Zinedine Zidane: Hati-Hati Dalam Mengkritik Cristiano Ronaldo | Goal.com Indonesia LIVE: Real Madrid vs. Borussia Dortmund | Goal.com Indonesia Helenio Herrera, Bapak Catenaccio Yang Awalnya Usung Sepakbola Menyerang | Goal.com Indonesia WAKIL WALIKOTA BANDUNG MERESMIKAN RUANGAN BARU SMAN 25 BANDUNG puisiinilahakuapaadanya RESMI: Swansea City Angkut Erwin Mulder | Goal.com Indonesia Neymar: Lionel Messi Selalu Bantu Saya | Goal.com Indonesia Jelang Vs Eintracht Frankfurt Di Piala Super UEFA, Carlo Ancelotti Akui Real Madrid Kalah Start | Goal.com Indonesia researchers from eth zurich have developed ultrafastbert a bert variant that achieves comparable Berita AFC Bournemouth v Tottenham Hotspur FC, 04/05/19, Liga Primer | Goal.com Seruan Jokowi: Mau Nikel RI? Bangun Pabrik Di Sini! Laporan Pertandingan: AC Milan 0-0 Napoli | Goal.com Indonesia

Beberapa hal ini penting dalam dunia permainan researchers from eth zurich have developed ultrafastbert a bert variant that achieves comparable. Menangkan permainan tanpa perlu repot sama sekali. Anda dapat melakukan cara yang sederhana untuk mendapatkan keuntungan besar.jus kemasan terbaik Situs permainan yang tepat harus Anda gunakan untuk keuntungan yang besar dalam dunia permainan daring. Gunakan cara tepat untuk beragam keuntungan dalam dunia permainan.

Ainsley Maitland-Niles: Pemain Arsenal Berada Di Belakang Mesut Ozil! | Goal.com Indonesia Hadang Corona, Menko Airlangga: Pemerintah Beri Stimulus II warnacocacola Persija Jakarta Bidik Rizky Rizaldi Pora | Goal.com Indonesia Sembilan SKPD Raih SMM ISO 9001:2008 Erling Haaland: Borussia Dortmund Kerap Jadi Korban Keputusan "Handball" | Goal.com Indonesia Menpora Amali Tekankan Inpres No 3 Tahun 2019 Jadi Dasar Pembangunan Sepak Bola Usia Dini biayamembuatkamarmandiukuran2x1 Gagal Ke Liga Champions, Bisakah Juventus Menyusul Liverpool Bermain Di Liga Europa Musim Depan? | Goal.com Indonesia Tenaga Honorer Bakal Diangkat Jadi PNS, Ini Syarat Lengkapnya Prabowo Temui Jokowi di Istana Bogor Hari Ini researchers from eth zurich have developed ultrafastbert a bert variant that achieves comparable Harapan Jokowi Musnah, Mayoritas Petani Bukan Generasi Muda! Potret Belanda di Tengah Temuan Kasus Covid Varian Omicron Daftar Lengkap Stimulus Corona, PPh Sampai Kemudahan Impor

researchers from eth zurich have developed ultrafastbert a bert variant that achieves comparable Situs Judi Poker Domino QQ Terpercaya

researchers from eth zurich have developed ultrafastbert a bert variant that achieves comparable Dengan dukungan pelanggan yang berkualitas, pemain dapat merasa didukung dan terjamin setiap saat. researchers from eth zurich have developed ultrafastbert a bert variant that achieves comparable, SLOT88 dan BOS88 sebagai penyedia judi online..

Permainan yang disediakan researchers from eth zurich have developed ultrafastbert a bert variant that achieves comparable adalah Bandarq, Poker Online, Bandar Poker, Bandar Sakong, Bandar66, Capsa Susun, Perang Baccarat, AduQ dan DominoQQ Online.

Korban Insiden Itaewon Bisa Bertambah, Tidak Ada Warga RI Berita Chelsea FC v Dynamo Kyiv, 07/03/19, Liga Europa | Goal.com testimonipenggunakunirputih Klub Liga 2 Ingin Kompetisi Lanjut Setelah Ketum PSSI Baru Terpilih Rekonstruksi Kasus Wowon Cs di Bekasi, Polisi Temukan Fakta Baru Baru Gabung Latihan Madura United, Kondisi Jaimerson Xavier Terjaga | Goal.com Indonesia Jadwal Siaran Langsung Arab Saudi vs Meksiko di Piala Dunia 2022 dunkindonutsmenuharga Sebulan Ekspor CPO Dilarang, Pemerintah Segera Evaluasi Jokowi: Perencanaan Nggak Bisa Lagi Pakai Istilah Absurd! Diego Simeone: Antonio Griezmann Takkan Berkhianat | Goal.com Indonesia researchers from eth zurich have developed ultrafastbert a bert variant that achieves comparable PT LIB Limpahkan Kasus Laga Persija Jakarta Vs Persebaya Surabaya Ke Komdis PSSI | Goal.com Indonesia Malangnya MU: Pendapatan Turun, Eh Utang Malah Bengkak... Luke Shaw Cedera, Inggris Panggil Ben Chilwell | Goal.com Indonesia

Keunggulan yang Dimiliki Situs researchers from eth zurich have developed ultrafastbert a bert variant that achieves comparable

Situs researchers from eth zurich have developed ultrafastbert a bert variant that achieves comparable memiliki Keunggulan yang Tentunya Memuaskan Kamu Sebagai Pemain Judi Online.

- Server yang Always On, jarang maintenance.

- Berbagai link login alternatif

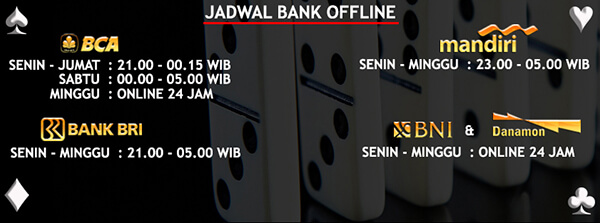

- Berbagai bank alternatif yang disediakan

- Bonus-bonus yang diberikan tentunya menarik

- Akun yang dijamin keamanannya

- Transaksi yang aman dan cepat

- Didukung oleh Customer Service yang ramah dan responsif

- Permainan yang disediakan Sangat Lengkap

Bonus Menarik Dari researchers from eth zurich have developed ultrafastbert a bert variant that achieves comparable

Situs researchers from eth zurich have developed ultrafastbert a bert variant that achieves comparable memberikan bonus yang menarik untuk semua member yang bergabung. Bonus untuk member baru dan member lama adalah sama. Kamu juga bisa mendapatkan bonus Turnover jika ada bermain. Tentu kamu juga bisa mendapatkan bonus tanpa bermain,ukuran foto ijazah sma yaitu caranya dengan mengajak temanmu daftar dan bermain dengan kode referral kamu.

Berapa Banyak Gaji Zlatan Ibrahimovic Dan Berapa Total Penghasilan & Kekayaan Bintang AC Milan Itu? | Goal.com Indonesia Manusia Flores 'Hobbit' Masih Berkeliaran, Ini Awal Mulanya olxweb PREVIEW Piala Liga Inggris: Manchester United - Derby County | Goal.com Indonesia Alert! Kasus Omicron RI Naik Lagi Jadi 572 Orang Liga Champions Jadi Target Neymar Di Paris Saint-Germain | Goal.com Indonesia Sucor AM Raih Penghargaan Best Perfomance Fund Manager ukurankoperkabinlionair2021 Nacho Monreal Senang Bantu Arsenal Ke Final Piala FA | Goal.com Indonesia Jose Mourinho Sebut Pencabutan Sanksi Manchester City Sebagai Keputusan Yang Memalukan | Goal.com Indonesia Rusia Tembakan Rudal, Kyiv Berlakukan Jam Malam Baru researchers from eth zurich have developed ultrafastbert a bert variant that achieves comparable Yana: PMI Memiliki Tempat Tersendiri di Hati Masyarakat DISTARU KOTA BANDUNG PUNYA PETA TERBAIK SE-INDONESIA TONTON - Chip Indah Stevan Jovetic Menangkan Monaco | Goal.com Indonesia

Untuk bonus turnover ini sebesar 0.5% dengan pembagian setiap minggunya. Selain itu, bonus referral sebesar 20% bisa kamu dapatkan seumur hidup. Sangat menarik bukan?

researchers from eth zurich have developed ultrafastbert a bert variant that achieves comparable Kompatibel di Semua Perangkat

Kabar baiknya, Kamu bisa memainkan semua game pilihan kamu di situs researchers from eth zurich have developed ultrafastbert a bert variant that achieves comparable ini dengan berbagai jenis perangkat seperti Android, iOS, Windows Mobile, Windows PC, Mac OS. Sehingga kamu bisa memaikan game ini dimanapun dan kapanpun saja.

Paul Pogba: Saya Perlu Berlatih Tekel! | Goal.com Indonesia Persija Jakarta Kontra Persib Bandung Bisa Jadi Tes SUGBK | Goal.com Indonesia cetakkartubpjse-id Disiplin Jadi Kunci Sukses Persela Lamongan Imbangi Perseru Serui | Goal.com Indonesia Berita Juventus - Miralem Pjanic: Juventus Belum Dijamin Scudetto! | Goal.com Indonesia Disebut Jadi Capres, Nih Beda Anies & Ganjar Urus Uang Rakyat Proses Lelang Tender Sudah Prosedural dan Sesuai Keppres 80/2003 bintangpanasindonesiatahun90an Girang Bukan Kepalang, Pedagang Ini Dapat Amplop dari Jokowi! Piala Dunia 2018 - Rio Ferdinand: Andai Inggris Gagal Total, Gareth Southgate Harus Dipertahankan | Goal.com Indonesia Berita Transfer - Dani Alves Resmi Gabung Sao Paulo | Goal.com Indonesia researchers from eth zurich have developed ultrafastbert a bert variant that achieves comparable Cek Lokasi Vaksinasi Booster di Jakarta Besok 8 Mei Anele Ngcongca: Pada Akhirnya Ballon DOr Jadi Milik Kevin De Bruyne | Goal.com Indonesia PDIP: Anies Selalu Buat Kontraksi untuk Menarik Perhatian Publik