RLHF для высокопроизводительного принятия решений стратегии и оптимизация

RLHF для принятия решений и оптимизация

Введение

Управление усилением на основе факторов/обратной связи человека (RLHF) – это развивающаяся область, которая объединяет принципы управления усилением и обратной связи человека. Она будет разработана для оптимизации принятия решений и повышения производительности в сложных реальных системах. RLHF для высокой производительности фокусируется на понимании человеческого поведения, когнитивности, контекста, знаний и взаимодействия путем использования вычислительных моделей и подходов, основанных на данных, для улучшения проектирования, удобства использования и безопасности различных областей.

RLHF стремится преодолеть разрыв между машинно-центричной оптимизацией и человеко-центричным проектированием путем интеграции алгоритмов управления усилением и принципов человеческих факторов. Исследователи стремятся создать интеллектуальные системы, которые адаптируются к потребностям, предпочтениям и возможностям человека, в конечном итоге улучшая пользовательский опыт. В RLHF вычислительные модели моделируют, предсказывают и предписывают человеческие реакции, позволяя исследователям получить представление о том, как люди принимают обоснованные решения и взаимодействуют с сложными средами. Представьте себе сочетание этих моделей с алгоритмами обучения с подкреплением! RLHF стремится оптимизировать процессы принятия решений, улучшать производительность системы и улучшать сотрудничество человека и машины в ближайшие годы.

Цели обучения

- Понимание основ RLHF и их значения в человеко-ориентированном проектировании – это первый и главный шаг.

- Изучение применения RLHF для оптимизации принятия решений и производительности в различных областях.

- Определение ключевых тем, связанных с RLHF, включая обучение с подкреплением, инженерию человеческих факторов и адаптивные интерфейсы.

- Распознавание роли графов знаний в облегчении интеграции данных и получении информации в исследованиях и применениях RLHF.

RLHF: Революционизация человеко-ориентированных областей

Управление усилением с учетом человеческих факторов (RLHF) имеет потенциал трансформировать различные области, где человеческие факторы имеют решающее значение. Оно использует понимание ограничений когнитивности, поведения и взаимодействия человека для создания адаптивных интерфейсов, систем поддержки принятия решений и технологий помощи, адаптированных к индивидуальным потребностям. Это приводит к повышению эффективности, безопасности и удовлетворенности пользователей, способствуя широкому принятию в отрасли.

- Познакомьтесь с ResFields новым подходом искусственного интеллекта для преодоления ограничений пространственно-временных нейронных полей в эффективном моделировании длинных и сложных временных сигналов.

- Раскрытие секретов каталитической эффективности с помощью глубокого обучения глубокий анализ глобальной и локальной сверточной нейронной сети для высокоточного скрининга гетерогенных катализаторов

- Расскажите мне о времени SceNeRFlow – это метод искусственного интеллекта, генерирующий временно согласованные NeRF-ы.

В процессе эволюции RLHF исследователи изучают новые приложения и решают проблемы интеграции человеческих факторов в алгоритмы обучения с подкреплением. Сочетая вычислительные модели, подходы, основанные на данных, и человеко-ориентированное проектирование, RLHF проложил путь к передовому сотрудничеству человека и машины и интеллектуальным системам, которые оптимизируют принятие решений и повышают производительность в различных реальных сценариях.

Почему RLHF?

RLHF крайне ценен для различных отраслей, таких как здравоохранение, финансы, транспорт, игры, робототехника, цепочки поставок, обслуживание клиентов и т. д. RLHF позволяет ИИ-системам учиться таким образом, что они более соответствуют намерениям и потребностям человека, что обеспечивает комфортное, безопасное и эффективное использование в широком спектре приложений для реальных сценариев использования и сложных проблем.

Почему RLHF ценен?

- Позволяет ИИ в сложных средах – это то, что RLHF способен делать. Во многих отраслях среды, в которых работают ИИ-системы, обычно являются сложными и трудными для точного моделирования. В то же время RLHF позволяет ИИ-системам учиться на основе человеческих факторов и применяться в этих сложных сценариях, где традиционный подход не обеспечивает достаточную эффективность и точность.

- RLHF способствует ответственному поведению ИИ в соответствии с человеческими ценностями, этикой и безопасностью. Постоянная обратная связь от людей помогает предотвратить нежелательные действия. С другой стороны, RLHF предоставляет альтернативный способ руководить процессом обучения агента, интегрируя человеческие факторы, суждения, приоритеты и предпочтения.

- Повышение эффективности и снижение затрат. Необходимость проведения обширных проб и ошибок с использованием графов знаний или обучения ИИ-систем может быть быстрым принятием решений в динамических ситуациях.

- Обеспечение RPA и автоматизации для адаптации в реальном времени. Во многих отраслях уже используются RPA или некоторые системы автоматизации, требующие быстрой адаптации ИИ-агентов к изменяющимся ситуациям. RLHF помогает этим агентам быстро учиться на основе обратной связи от людей, улучшая производительность и точность даже в неопределенных ситуациях. Мы называем это “СИСТЕМА ИНТЕЛЛЕКТУАЛЬНОГО ПРИНЯТИЯ РЕШЕНИЙ”, где RDF (ресурсно-ориентированный фреймворк разработки) может даже предоставлять информацию семантической сети в ту же систему, что помогает принимать обоснованные решения.

- Цифровизация экспертных знаний. В каждой отрасли экспертиза является важным фактором. С помощью RLHF ИИ-системы могут учиться на основе знаний экспертов. Аналогично, графы знаний и RDF позволяют нам цифровизировать это знание из демонстраций экспертов, процессов, фактов решения проблем и способностей оценки. RLHF даже может эффективно передавать знания агентам.

- Настройка в соответствии с потребностями. Постоянное улучшение – одно из главных соображений, с которыми ИИ-системы обычно работают для реальных сценариев, где они могут получать обратную связь от пользователей и экспертов, что позволяет ИИ постоянно улучшаться на основе обратной связи и принимаемых решений.

Как работает RLHF?

RLHF соединяет машинное обучение и человеческую экспертизу путем объединения человеческих знаний с техниками обучения с подкреплением, где системы искусственного интеллекта становятся более приспособляемыми с более высокой точностью и эффективностью.

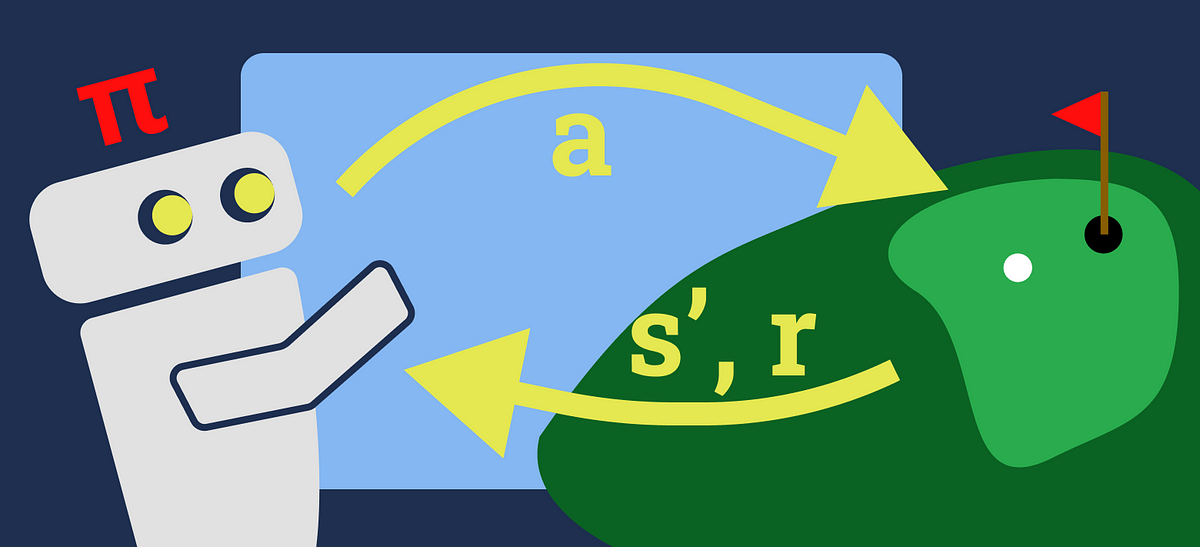

Обучение с подкреплением на основе обратной связи от человека (RLHF) – это подход машинного обучения, который улучшает обучение агентов искусственного интеллекта путем интеграции обратной связи, предоставленной человеком, в процесс обучения. RLHF решает проблемы, с которыми сталкиваются традиционные методы обучения с подкреплением из-за нечетких сигналов вознаграждения, сложных сред и необходимости согласования поведения ИИ с человеческими ценностями.

В RLHF агент искусственного интеллекта взаимодействует с окружающей средой и получает обратную связь в виде вознаграждения. Однако эти вознаграждения могут быть недостаточными, шумными или сложно точно определить. Обратная связь человека становится важной для эффективного направления обучения агента. Эта обратная связь может принимать разные формы, такие как явные вознаграждения, демонстрации желаемого поведения, сравнения, ранжирования или качественные оценки.

Агент интегрирует обратную связь человека в процесс обучения, корректируя свою стратегию, функцию вознаграждения или внутренние представления. Это объединение обратной связи и обучения позволяет агенту уточнять свое поведение, учиться на основе человеческой экспертизы и согласовываться с желаемыми результатами. Основной задачей является соблюдение баланса между исследованием (попыткой новых действий) и эксплуатацией (выбором известных действий) для эффективного обучения с учетом предпочтений человека.

RLHF охватывает различные техники

- Формирование вознаграждения: Обратная связь человека формирует вознаграждения агента, направляя его обучение на желаемые поведения.

- Имитационное обучение: Агенты учатся на основе демонстраций человека, имитируя правильные действия и обобщая их на аналогичные ситуации.

- Ранжирование и сравнение: Люди ранжируют действия или сравнивают стратегии, направляя агента к выбору действий, соответствующих предпочтениям человека.

- Обратная связь по предпочтениям: Агенты используют предпочтительную информацию, предоставленную человеком, для принятия решений, отражающих человеческие ценности.

- Обратная связь критика: Люди выступают в роли критиков, оценивают работу агента и предлагают идеи для улучшения.

Процесс является итеративным, поскольку агент совершенствует свое поведение со временем через постоянное взаимодействие, интеграцию обратной связи и корректировку стратегии. Производительность агента оценивается с использованием традиционных метрик обучения с подкреплением и метрик, измеряющих соответствие человеческим ценностям.

«Я предлагаю использовать графовые базы данных, графы знаний и RDF, так как они оказывают большее влияние, чем традиционные базы данных для RLHF».

Широкое использование RLHF в отрасли

RLHF имеет огромный потенциал для революционизации процессов принятия решений и повышения производительности в различных отраслях. Ниже приведены некоторые основные примеры использования в различных отраслях:

- Производство и индустрия 4.0, 5.0: Рассмотрим сложную производственную систему или процесс. С помощью понимания человеческих факторов и обратной связи RLHF может стать частью цифровой трансформации, повышая безопасность труда, производительность, эргономику или даже устойчивость путем снижения рисков. RLHF можно использовать для оптимизации обслуживания, планирования и распределения ресурсов в сложных промышленных условиях реального мира.

- Банки, финансы, страхование и инвестиции (BFSI): BFSI постоянно улучшает управление рисками, клиентский опыт и процесс принятия решений. Представьте себе человеческую обратную связь и факторы, такие как поведение пользователей, пользовательские интерфейсы, поведение инвесторов и познавательные предубеждения, такие как информационный и подтверждающий предубеждения. Эти бизнес-атрибуты могут привести к персонализированным финансовым рекомендациям, оптимизации торговых стратегий и полному улучшению систем обнаружения мошенничества. Например, «Представьте, что индивидуальный инвестор готов продать акции, которые выросли в цене, но предпочитает держать акции, которые потеряли в цене». RLHF может предложить рекомендации или стратегически обоснованные решения, которые могут быстро решить бизнес-проблемы.

- Фармацевтика и здравоохранение: Путем интеграции RLHF в компанию RLHF может помочь профессионалам в принятии персонализированных рекомендаций по лечению и прогнозировании результатов для пациентов. RLHF будет отличным вариантом для оптимизации клинического принятия решений, планирования лечения, нежелательных лекарственных реакций и производства API.

- Цепочка поставок и логистика: RLHF может сыграть важную и решающую роль в улучшении систем цепочки поставок, транспорта и логистических операций. Рассмотрим человеческие факторы, такие как поведение водителя и психическая нагрузка, связанная с принятием решений. RLHF можно использовать для оптимизации учета запасов с рекомендациями по спросу и планированию распределения, оптимизации маршрутов и управления автопарком. С другой стороны, исследователи работают над усовершенствованием систем помощи водителю, автономных транспортных средств и управления воздушным движением с использованием RLHF, что может привести к более безопасным и эффективным транспортным сетям.

Заключение

Усиленное обучение в человеческих факторах (RLHF) объединяет усиленное обучение с инженерией человеческих факторов для улучшения принятия решений и производительности в различных областях. Оно акцентирует внимание на графах знаний для продвижения исследований. Универсальность RLHF подходит для областей, связанных с принятием решений и оптимизацией человека, предлагая точные данные и исследования.

RLHF + технология графов устраняет фрагментацию данных, улучшая информацию для алгоритмов. Эта статья предоставляет глобальное представление об RLHF, его потенциале и роли графов знаний в оптимизации различных областей.